HDFS报错全面解析与解决策略

Hadoop分布式文件系统(HDFS)在使用过程中可能会遇到各种报错问题,本文将详细探讨常见的HDFS报错及其原因,并提供解决方案,通过全面的分析和逻辑清晰的阐述,帮助用户更好地理解和处理HDFS报错。

一、HDFS常见报错及解决方案

1、命令未找到错误

错误信息:Command 'hdfs' not found, did you mean:

原因:系统中没有设置Hadoop的bin目录到PATH环境变量中。

解决方法

方法1:在执行hadoop命令时,进入Hadoop的安装目录,并在命令前加上./bin,./bin/hadoop fs ls。

方法2:配置环境变量,编辑~/.bashrc文件,添加如下内容:export HADOOP_HOME=/usr/local/hadoop 和export PATH=$HADOOP_HOME/bin:$PATH,然后执行source ~/.bashrc使配置生效。

2、拒绝连接错误

错误信息:java.net.ConnectException: Connection refused

原因:NameNode或DataNode服务未启动,或者端口配置错误。

解决方法

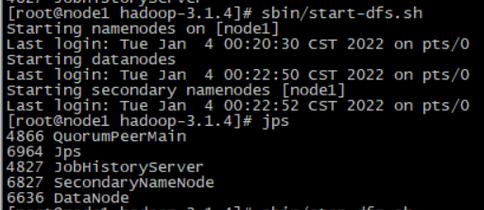

检查服务状态:确保NameNode和DataNode服务已启动,可以使用jps命令查看Java进程,确认NameNode和DataNode是否运行。

检查配置文件:确认coresite.xml和hdfssite.xml中的端口配置正确,特别是dfs.namenode.httpaddress和dfs.datanode.http.address属性。

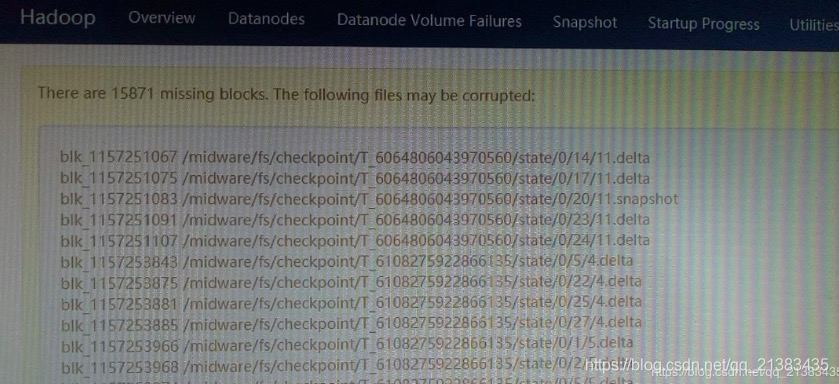

3、块丢失异常

错误信息:org.apache.hadoop.hdfs.BlockMissingException

原因1:DataNode上的块确实丢失。

解决方法:使用hdfs fsck /命令检查文件系统的完整性,并联系系统管理员修复或删除损坏的块。

原因2:客户端无法通过特定的IP或主机名连接到DataNode。

解决方法:检查客户端与DataNode之间的网络连通性,确保能够ping通和telnet到DataNode的端口,如果DataNode配置了主机名,可以在客户端配置dfs.client.use.datanode.hostname=true。

4、权限不足错误

错误信息:org.apache.hadoop.security.KerberosAuthException

原因:Kerberos认证失败,可能是keytab文件配置不正确或缺少相应的主体信息。

解决方法

检查keytab文件:确保keytab文件中包含正确的主体信息,如果缺少,需要重新从KDC服务器抽取并分发到Hadoop集群各节点。

启用块访问令牌:在配置Kerberos集群时,确保dfs.block.access.token.enable设置为true,以允许客户端访问DataNode。

5、安全数据传输配置错误

错误信息:java.lang.RuntimeException: Cannot start secure DataNode without configuring either privileged resources or SASL RPC data transfer protection and SSL for HTTP

原因:DataNode启动时未配置特权资源或SASL RPC数据传输保护和HTTP的SSL。

解决方法:修改hdfssite.xml配置文件,添加或修改以下属性:

- <property>

- <name>dfs.data.transfer.protection</name>

- <value>integrity</value>

- <description>Secure DataNode connections with integrity check.</description>

- </property>

- <property>

- <name>dfs.http.policy</name>

- <value>HTTPS_ONLY</value>

- <description>Ensure DataNode serves HTTPS only.</description>

- </property>

确保sslserver.xml文件中配置了密钥库位置。

二、相关FAQs

1、Q1:如何更改HDFS的默认端口号?

A1:可以通过修改coresite.xml和hdfssite.xml文件中的相关属性来更改HDFS的默认端口号,将dfs.namenode.httpaddress和dfs.datanode.http.address属性的值改为新的端口号,然后重启Hadoop服务。

2、Q2:如何在复杂网络环境中优化HDFS的性能?

A2:在复杂网络环境中,可以通过以下方式优化HDFS性能:

使用多网卡绑定(如NIC teaming)提高网络带宽。

配置适当的TCP参数,如增加TCP缓冲区大小。

确保DataNode之间的网络延迟最小化。

使用CDH等发行版提供的优化工具和配置。

通过对HDFS常见报错的详细分析和解决方案的提供,用户可以更有效地诊断和解决HDFS使用过程中遇到的问题,从而保证系统的稳定运行。