在使用Scrapy进行网络爬虫开发时,很多开发者会遇到reload操作引发的报错问题,这类错误通常伴随难以定位的异常信息,导致爬虫中断运行,本文将结合实际案例,分析Scrapy reload报错的核心原因,并提供可落地的解决方案。

一、Scrapy Reload的典型报错场景

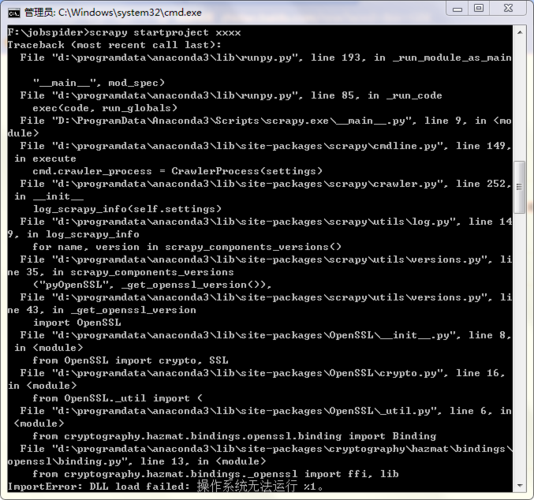

当尝试在Scrapy项目中动态加载或重新加载模块时,控制台可能抛出以下类型的错误:

1、ImportError: cannot import name '...'

2、TypeError: 'module' object is not callable

3、KeyError: 'Spider not found'

4、twisted.internet.error.ReactorNotRestartable

这些报错往往出现在以下操作中:

- 在Jupyter Notebook中反复执行爬虫

- 使用脚本动态修改爬虫代码后重新运行

- 通过外部工具触发爬虫重启

二、根本原因剖析

Scrapy框架的运行机制限制

Scrapy基于Twisted异步框架构建,其事件循环(Reactor)设计为单例模式,当首次运行爬虫时,Reactor被初始化并启动,但无法在同一个进程中重复启动或重启,若强行调用reactor.run()会导致ReactorNotRestartable错误。

验证方法:

在代码中加入以下调试语句:

- from twisted.internet import reactor

- print(id(reactor))

多次运行后若输出相同内存地址,则证明Reactor未被重置。

Python模块加载特性

Python的模块系统采用缓存机制,已加载的模块会存储在sys.modules中,当尝试通过importlib.reload()重新加载包含Spider定义的模块时,可能出现:

- 类继承关系错乱

- 元类(Metaclass)冲突

- 信号连接重复绑定

3. CrawlerProcess的生命周期管理

错误的使用方式:

- process = CrawlerProcess()

- process.crawl(MySpider)

- process.start()

- 再次调用process.start() 会报错

正确做法应确保每个进程只初始化一次CrawlerProcess。

三、解决方案与最佳实践

方案1:使用CrawlerRunner替代(推荐)

- from twisted.internet import reactor

- from scrapy.crawler import CrawlerRunner

- def run_spider():

- runner = CrawlerRunner()

- deferred = runner.crawl(MySpider)

- deferred.addCallback(lambda _: reactor.stop())

- reactor.run(installSignalHandlers=0)

- 每次调用都会创建新Runner

- run_spider()

优势:

- 每次运行创建独立的Runner实例

- 兼容多次执行需求

方案2:子进程隔离

通过subprocess模块启动独立Python进程:

- import subprocess

- subprocess.run(['scrapy', 'crawl', 'myspider'])

适用场景:

- 需要完全隔离运行环境

- 避免内存泄漏累积

方案3:模块热重载优化

若必须使用importlib.reload(),需配合以下操作:

1、清理Scrapy的信号处理器:

- from scrapy import signals

- signins.receivers = {}

2、重置Twisted线程池:

- from twisted.python.threadpool import ThreadPool

- ThreadPool._threadpool = None

四、预防性编程建议

1、环境隔离

使用virtualenv或conda创建专属Python环境,避免依赖冲突,定期执行以下命令检查环境健康状态:

- pip freeze > requirements.txt

- scrapy version -v

2、代码规范

- 在Spider类中添加closed()方法释放资源

- 避免在全局作用域定义网络请求相关对象

3、单元测试覆盖

对爬虫的核心组件编写测试用例:

- from scrapy.http import HtmlResponse

- class TestSpider(unittest.TestCase):

- def test_parse(self):

- fake_response = HtmlResponse(url='', body=html_content)

- results = spider.parse(fake_response)

- self.assertIsInstance(results, Iterable)

4、日志监控

在settings.py中配置详细日志记录:

- LOG_LEVEL = 'DEBUG'

- LOG_STDOUT = True

遇到Scrapy reload报错时,建议优先检查Twisted Reactor状态和模块加载顺序,多数情况下,采用子进程隔离方案能快速解决问题,对于需要频繁调试的场景,推荐结合Jupyter Notebook与CrawlerRunner实现交互式开发,保持代码的松散耦合和及时清理全局状态,是避免这类问题的根本之道。