在使用Python进行网络爬虫开发过程中,header的设置是模拟浏览器请求的重要环节,不正确的header设置可能导致各种错误和异常,以下是关于“header() 报错”问题的详细探讨:

常见Header相关报错类型及解决方法

1、UserAgent相关报错:在构造请求时,常常需要设置UserAgent来伪装成不同的浏览器,如果未正确设置UserAgent,可能会遇到“HTTP Error 403: Forbidden”等错误,这是因为服务器拒绝了没有UserAgent的请求,解决方法是在请求头中添加合适的UserAgent字符串,例如使用浏览器的UserAgent字符串。

2、Referer相关报错:Referer字段用于告诉服务器当前请求是从哪个页面链接过来的,有些网站会检查Referer值,如果不符合预期,可能会返回“HTTP Error 403: Forbidden”或“HTTP Error 400: Bad Request”等错误信息,解决方法是尝试设置正确的Referer值,即上一个页面的URL地址。

3、Cookie相关报错:在进行登录或访问需要身份验证的网站时,如果没有正确设置Cookie,可能会遇到“HTTP Error 403: Forbidden”或“HTTP Error 401: Unauthorized”等错误,解决方法是通过分析登录过程,在请求头中添加正确的Cookie信息。

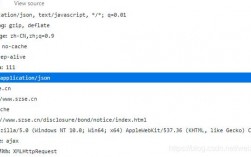

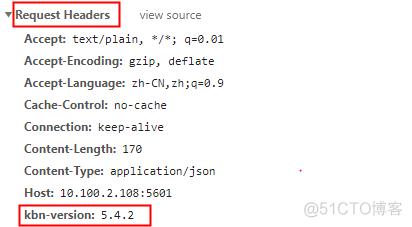

4、AcceptEncoding相关报错:AcceptEncoding字段用于告诉服务器客户端可以接受的内容编码方式,例如gzip、deflate等,有些网站可能会压缩响应内容,如果没有正确设置AcceptEncoding,可能会导致解压缩错误,解决方法是在请求头中设置合适的AcceptEncoding值,与服务器协商合适的内容编码方式。

5、InvalidHeader错误:这个报错通常是由于请求头中包含了无效的字符或格式不正确导致的,UserAgent头部存在空格或特殊字符,可能会导致InvalidHeader错误,解决方法是确保请求头中的每个字段值都是有效的字符串,并且遵循HTTP协议的规范。

6、SSL证书验证失败:当使用requests库发送HTTPS请求时,如果SSL证书验证失败,会抛出SSLError异常,解决方法是通过设置verify=False禁用SSL证书验证(不推荐),或者安装正确的证书文件进行验证。

解决Header报错的方法

1、使用合适的第三方库:一些优秀的第三方库(如Requests、Scrapy)已经提供了方便的Header设置和处理方法,使用这些库可以简化代码,减少出错的可能性。

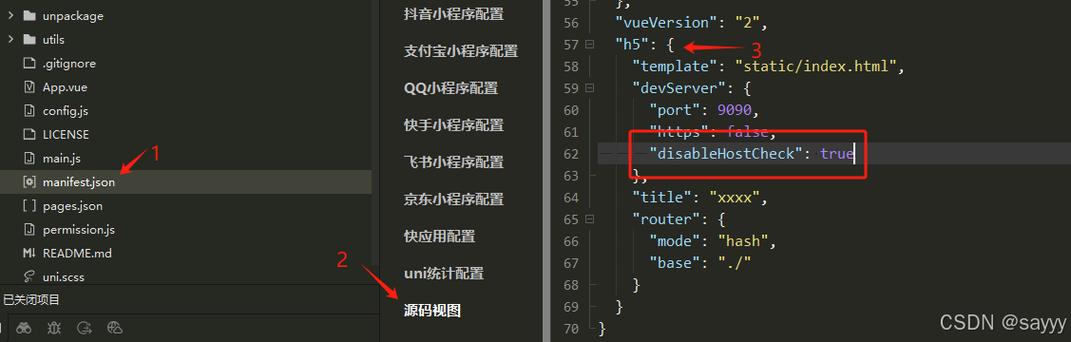

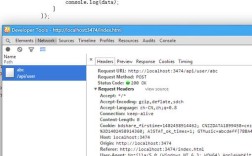

2、分析网站请求过程:通过抓包工具(如Wireshark、Fiddler)或浏览器开发者工具分析网站的请求过程和请求头信息,根据分析结果调整自己的请求头设置。

3、多次尝试与调试:遇到问题时,可以尝试多次请求,并打印出请求头和错误信息,对比分析可能的原因,逐步修改请求头的设置。

在使用Python进行网络爬虫开发时,header的设置是模拟浏览器请求的关键步骤,通过正确设置UserAgent、Referer、Cookie、AcceptEncoding等字段,可以有效避免常见的Header相关报错,利用合适的第三方库和工具进行分析和调试,也能提高爬虫的稳定性和成功率,需要注意的是,我们在进行爬虫开发时应遵守相关法律法规和网站的使用规则,尊重网站的隐私权和服务限制。