构建CentOS环境下Apache集群的实践指南

在高并发、高流量的网络环境中,单台服务器往往难以承载全部负载,通过搭建apache集群,可以将请求分发到多台服务器,提升系统稳定性和响应速度,本文基于CentOS系统,介绍如何快速部署Apache集群,并确保配置符合高可用性与负载均衡的需求。

一、Apache集群的核心架构

Apache集群通常由以下组件构成:

1、负载均衡器(Load Balancer):负责将用户请求分发到后端多台Apache服务器,常用方案包括Apache自带的mod_proxy或第三方工具如Nginx、HAProxy。

2、后端服务器(Backend Servers):多台运行Apache的CentOS服务器,处理实际请求。

3、会话保持(Session Persistence):通过mod_session或数据库存储会话数据,避免用户请求跳转时丢失状态。

二、部署Apache负载均衡器

以下步骤以Apache的mod_proxy模块为例:

1、安装Apache与模块

- sudo yum install httpd mod_ssl mod_proxy mod_proxy_http mod_proxy_balancer

2、配置负载均衡

编辑/etc/httpd/conf/httpd.conf,添加以下内容:

- <VirtualHost *:80>

- ProxyRequests Off

- <Proxy balancer://mycluster>

- BalancerMember http://192.168.1.101:80 route=server1

- BalancerMember http://192.168.1.102:80 route=server2

- ProxySet lbmethod=byrequests # 按请求数分配负载

- </Proxy>

- ProxyPass / balancer://mycluster/

- ProxyPassReverse / balancer://mycluster/

- </VirtualHost>

3、启动服务并验证

- sudo systemctl restart httpd

- sudo firewall-cmd --permanent --add-service=http

- sudo firewall-cmd --reload

通过访问负载均衡器IP,观察请求是否被分发到后端服务器。

三、配置后端Apache服务器

1、同步网站内容

确保所有后端服务器的网站目录(如/var/www/html一致,可通过Rsync或版本控制工具(如Git)实现实时同步。

2、关闭负载均衡器的本地解析

在后端服务器的Apache配置中,添加:

- ProxyRequests Off

- ProxyPreserveHost On

3、启用状态监控页面(可选)

在负载均衡器配置中添加:

- <Location /balancer-manager>

- SetHandler balancer-manager

- Require host localhost # 仅允许本地访问

- </Location>

通过http://负载均衡器IP/balancer-manager可查看集群节点状态。

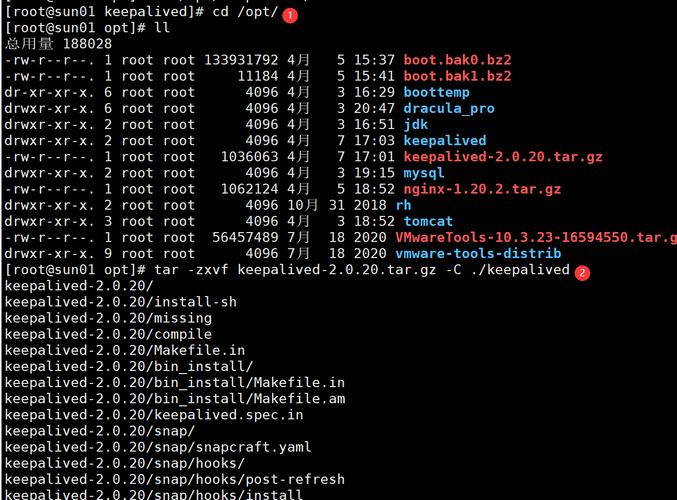

四、保障高可用性:Keepalived方案

为避免负载均衡器单点故障,可通过Keepalived实现主备切换:

1、安装Keepalived

- sudo yum install keepalived

2、配置虚拟IP(VIP)

编辑/etc/keepalived/keepalived.conf,主节点配置示例:

- vrrp_instance VI_1 {

- state MASTER

- interface eth0

- virtual_router_id 51

- priority 100

- advert_int 1

- authentication {

- auth_type PASS

- auth_pass 1111

- }

- virtual_ipaddress {

- 192.168.1.100/24

- }

- }

备用节点需修改state为BACKUP,priority为更低值(如90)。

五、优化与安全建议

启用HTTPS:使用Let’s Encrypt免费证书,提升数据传输安全性。

监控与日志分析:通过Prometheus+Grafana监控服务器状态,结合ELK(Elasticsearch、Logstash、Kibana)分析访问日志。

防火墙规则:仅开放必要端口(如80、443、SSH),禁用未使用的服务。

个人观点

Apache集群的搭建并非一劳永逸,需根据业务规模动态调整节点数量,对于中小型站点,初期可采用2-3台服务器搭配简单负载均衡;若流量激增,可引入容器化技术(如Docker+Kubernetes)实现弹性扩展,技术方案的选择,核心在于平衡成本、效率与可维护性。