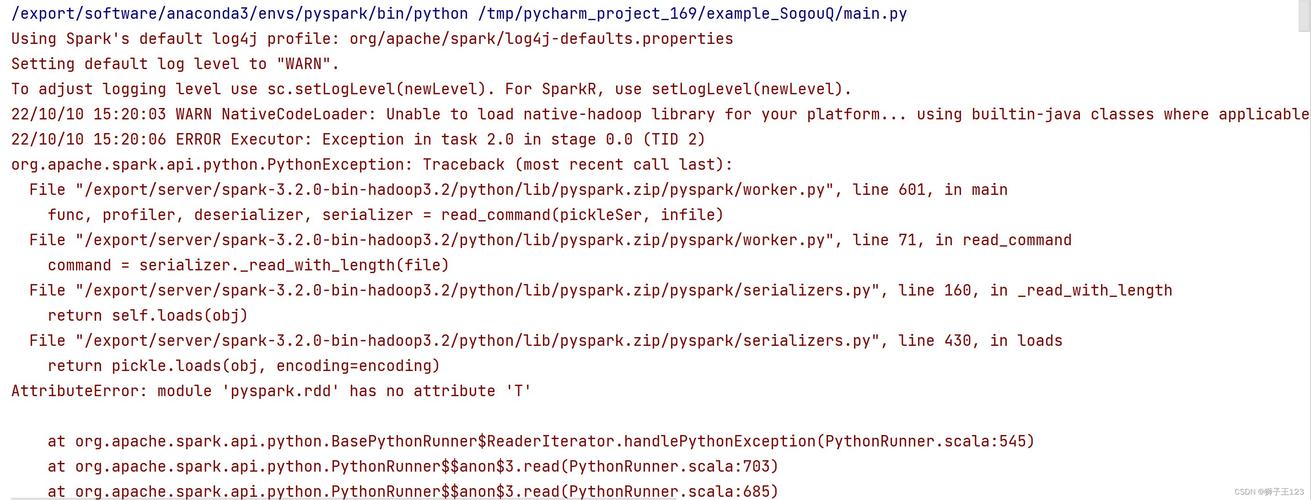

PySpark报错解析与解决方案

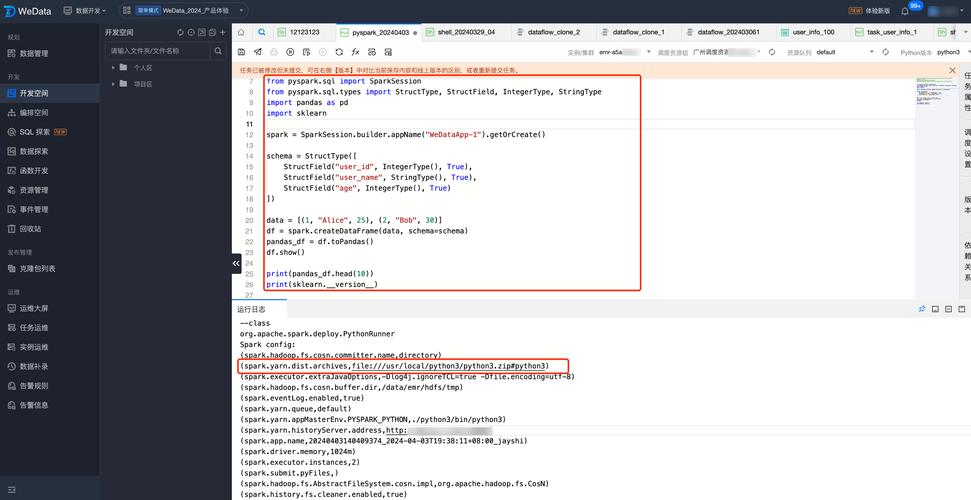

PySpark是一个强大的分布式计算框架,它允许使用Python编程语言进行大规模数据处理,在使用PySpark时,用户可能会遇到各种错误和问题,本文将详细分析常见的PySpark报错及其解决方案,并附有FAQs部分以解答常见问题。

一、常见PySpark报错及解决方案

1. Spark启动从节点报错

报错信息:

- An illegal reflective access operation has occurred

- ...

- WARNING: All illegal access operations will be denied in a future release

解决方案:

这种错误通常是由于JDK版本过高导致的,可以通过在sparkenv.sh文件中添加以下配置来解决:

- export SPARK_LOCAL_IP=127.0.0.1

具体步骤如下:

1、找到sparkenv.sh文件,通常位于$SPARK_HOME/conf目录下。

2、使用文本编辑器打开文件,例如notepad或者vim。

3、在文件末尾添加上述配置。

4、保存并关闭文件。

2. Python版本不匹配

报错信息:

- ERROR: Your Python interpreter from your environment variable PYSPARK_PYTHON does not match the Python interpreter used to run this script.

解决方案:

这种错误是由于PySpark使用的Python解释器版本与当前环境不一致导致的,解决方法是设置正确的Python解释器路径。

- os.environ["PYSPARK_PYTHON"] = "/path/to/correct/python"

- os.environ["PYSPARK_DRIVER_PYTHON"] = "/path/to/correct/python"

确保指定的路径是正确的Python解释器。

3. 未找到winutils.exe

报错信息:

- java.io.FileNotFoundException: java.io.FileNotFoundException: HADOOP_HOME and hadoop.home.dir are unset.

解决方案:

此错误表明系统找不到Hadoop的配置文件,解决方法是将hadoopconfig目录中的winutils.exe文件路径添加到环境变量中,具体步骤如下:

1、将hadoopbin.tar.gz解压到某个目录,例如C:\hadoop3.1.2。

2、将hadoop3.1.2\bin下的winutils.exe复制到Windows系统的C:\hadoop\bin目录下(如果没有该目录则新建)。

3、在系统环境变量中添加HADOOP_HOME,并将其值设置为C:\hadoop。

4、重新启动命令提示符或IDE,使环境变量生效。

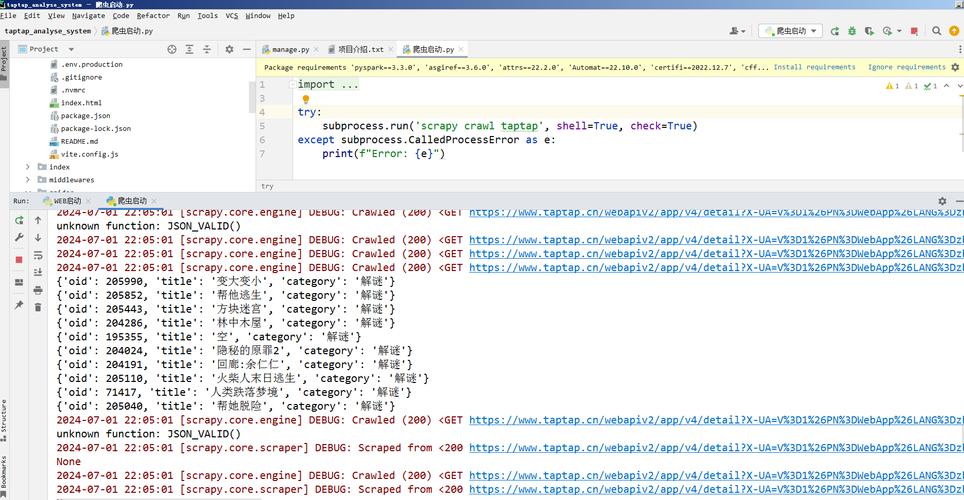

4. PySpark模块导入失败

报错信息:

- ModuleNotFoundError: No module named 'pyspark'

解决方案:

这种错误通常是由于没有正确安装PySpark或者环境变量未正确设置导致的,解决方法如下:

1、检查PySpark安装:在终端或命令提示符中执行以下命令:

- pip show pyspark

如果未显示任何信息,则需要重新安装PySpark:

- pip install pyspark

2、修改环境变量:将PySpark的安装路径添加到系统的环境变量中,在Windows系统中:

右键点击“此电脑” > “属性” > “高级系统设置” > “环境变量”。

在系统变量中找到Path,点击编辑,添加PySpark的安装路径,例如C:\Users\你的用户名\AppData\Local\Programs\Python\Python39\Lib\sitepackages\pyspark。

5. SparkContext初始化失败

报错信息:

- Py4JJavaError: An error occurred while calling None.scalaObject$org$apache$spark$api$python$JavaToPythonCallable$$d8f6e8a6.call()

解决方案:

这种错误通常是由于Java网关进程退出导致的,解决方法如下:

1、确保已正确设置JAVA_HOME环境变量,并且其值指向JDK的安装路径。

2、确保Spark和Hadoop的版本兼容,如果不兼容,请升级或降级相应的软件版本。

3、如果问题依然存在,可以尝试重新配置Spark环境变量,并在sparkenv.sh中指定正确的Java路径。

二、FAQs

Q1: 如何在Jupyter Notebook中使用PySpark?

A1: 要在Jupyter Notebook中使用PySpark,可以按照以下步骤操作:

1、安装findspark库:

- pip install findspark

2、在Notebook中初始化findspark并创建SparkSession:

- import findspark

- findspark.init()

- from pyspark.sql import SparkSession

- spark = SparkSession.builder.appName("MyApp").getOrCreate()

3、现在可以在Notebook中使用Spark的功能了。

Q2: 如何解决PySpark中的Java版本不兼容问题?

A2: 如果遇到Java版本不兼容的问题,可以尝试以下方法:

1、确认安装了正确版本的JDK,Spark通常与特定版本的JDK兼容,可以在Spark官网上查看具体的兼容性信息。

2、在sparkenv.sh文件中设置SPARK_JAVA_HOME环境变量,指向正确的JDK路径。

- export SPARK_JAVA_HOME=/path/to/correct/jdk

3、如果问题依然存在,可以尝试更换JDK版本,确保其与Spark版本兼容。

通过上述详细的分析和解决方案,用户可以更好地理解和解决在使用PySpark过程中遇到的各种报错问题,希望本文对大家有所帮助!