Python爬虫常见报错及解决方法

在Python爬虫开发过程中,遇到各种报错是常见的现象,这些错误可能来自网络请求、网页解析、数据存储等多个方面,本文将详细汇总一些常见的爬虫报错及其解决方法,帮助开发者更高效地解决问题,提高爬虫程序的稳定性和可靠性。

1. 请求超时(HTTP Error 408: Request Timeout)

HTTP Error 408: Request Timeout

解决方法:

增加请求的超时时间,可以使用requests库的timeout参数进行设置。

import requests url = 'http://example.com' response = requests.get(url, timeout=10) # 设置超时时间为10秒

2. 代理问题(HTTP Error 407: Proxy Authentication Required)

HTTP Error 407: Proxy Authentication Required

解决方法:

设置代理并传递给requests库,

proxies = {

'http': 'http://10.10.1.10:3128',

'https': 'https://10.10.1.10:1080',

}

response = requests.get('http://example.com', proxies=proxies)3. 网页解析错误(找不到指定的标签或属性等解析错误)

AttributeError: 'NoneType' object has no attribute 'text'

解决方法:

检查正则表达式或BeautifulSoup解析代码,确保能够正确匹配目标网页结构,可以参考目标网页的HTML源码,检查标签和属性是否正确。

from bs4 import BeautifulSoup

import requests

url = 'http://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

print(soup.find('div', class_='example'))4. 编码问题(UnicodeDecodeError或UnicodeEncodeError)

UnicodeDecodeError: 'utf8' codec can't decode byte...

解决方法:

确认网页的编码方式,并在解析网页时指定正确的编码方式。

response = requests.get('http://example.com')

response.encoding = 'utf8' # 指定编码方式为utf8

html = response.text5. 无效的URL(Invalid URL)

Invalid URL: //example.com/page

解决方法:

检查URL是否有效,确保协议、域名和路径等部分正确无误,可以使用在线的URL校验工具进行验证。

url = 'http://example.com/page' response = requests.get(url)

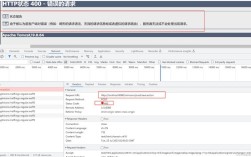

6. 爬虫被目标网站封禁(HTTP Error 429: Too Many Requests)

HTTP Error 429: Too Many Requests

解决方法:

降低爬取频率,可以使用time模块进行适当的延迟。

import time import requests url = 'http://example.com' response = requests.get(url) time.sleep(2) # 暂停2秒后再进行下一次请求

爬取的数据为空或不存在

爬取的数据为空或目标数据不存在。

解决方法:

检查爬取的URL和解析逻辑是否正确,确保能够获取到目标数据,也要注意目标网站是否进行了反爬虫处理,如使用动态加载、验证码等手段。

from bs4 import BeautifulSoup

import requests

url = 'http://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

data = soup.find('div', class_='data')

if not data:

print("未找到目标数据")

else:

print(data.text)8. 数据存储问题(无法将数据写入文件或数据库等存储方式)

无法将数据写入文件或数据库等存储方式。

解决方法:

检查存储路径、权限和数据库连接等是否正确,也要注意数据格式是否符合存储要求,可以使用tryexcept语句捕获异常并进行相应的处理。

try:

with open('data.txt', 'w', encoding='utf8') as f:

f.write(data)

except Exception as e:

print(f"数据存储失败: {e}")9. 无法获取cookie或session信息(导致登录失败或无法保持登录状态)

无法获取到cookie或session信息,导致登录失败或无法保持登录状态。

解决方法:

可以使用requests库的cookies参数来传递cookie信息,或者使用requests.Session()来保持会话状态。

import requests

session = requests.Session()

login_url = 'http://example.com/login'

login_data = {'username': 'your_username', 'password': 'your_password'}

session.post(login_url, data=login_data)

response = session.get('http://example.com/protected_page')

print(response.text)10. JSON解析错误(JSONDecodeError)

JSONDecodeError: Expecting value: line 1 column 1 (char 0)

解决方法:

确保从服务器返回的数据是有效的JSON格式,并且使用json.loads()方法进行解析。

import json import requests url = 'http://example.com/api/data' response = requests.get(url) data = json.loads(response.text) print(data)

FAQs常见问题解答

Q1: 爬虫到底是什么?为什么要模仿浏览器?

A1: 爬虫是一种按照一定规则自动抓取万维网信息的程序或脚本,它通过模仿浏览器的行为,发送HTTP请求并获取服务器响应的数据,然后根据需要筛选和处理这些数据,爬虫的核心目的是自动化地获取互联网上的信息,以便后续分析和使用。

Q2: 如果爬虫被封禁IP怎么办?如何避免被封?

A2: 如果爬虫被封禁IP,可以尝试以下几种方法来避免被封:

1、降低爬取频率:在每次请求之间增加随机延时,避免频繁访问同一网站。

2、使用代理IP:通过代理服务器中转请求,避免直接暴露真实IP地址,可以使用免费或付费的代理服务。

3、模拟浏览器行为:在请求头中添加UserAgent等信息,模拟真实浏览器的行为,减少被识别为爬虫的风险。