Scrapy报错详解及解决方案

背景介绍

Scrapy是一个用Python编写的高级网络爬虫框架,广泛应用于数据爬取和网页抓取领域,在实际使用过程中,开发者可能会遇到各种报错问题,本文将详细解析Scrapy常见的报错类型及其解决方法,帮助开发者更好地理解和解决这些问题。

常见报错类型及解决方法

TimeoutError

描述:

twisted.internet.error.TimeoutError: User timeout caused connection failure

原因:

这种错误通常是由于请求超时引起的,可能是因为目标网站响应速度过慢或网络连接不稳定。

解决方法:

捕获异常并重新请求:在中间件中捕获该异常并重新发送请求。

from twisted.internet.error import TimeoutError

def process_exception(self, request, exception, spider):

if isinstance(exception, TimeoutError):

return request # 返回请求对象以重新请求调整超时时间:在settings.py中增加DOWNLOAD_TIMEOUT的值。

DOWNLOAD_TIMEOUT = 30 # 单位为秒使用代理:如果目标网站对某些IP地址有访问限制,可以尝试使用代理服务器。

2. ImportError: No module named 'win32api'

描述:

ImportError: No module named 'win32api'

原因:

这是由于缺少pywin32库导致的,特别是在Windows环境下运行Scrapy时。

解决方法:

安装pywin32库:使用pip进行安装。

pip install pywin32确保环境变量设置正确:检查Python和Scrapy的路径是否已添加到系统的环境变量中。

3. KeyError: 'Spider not found'

描述:

KeyError: 'Spider not found: douban'

原因:

这是由于指定的Spider不存在或未正确定义。

解决方法:

确认Spider存在:检查项目目录下是否有对应的Spider文件,并且文件名正确。

定义Spider类:确保Spider类继承自scrapy.Spider并正确实现。

import scrapy

class DoubanSpider(scrapy.Spider):

name = 'douban'

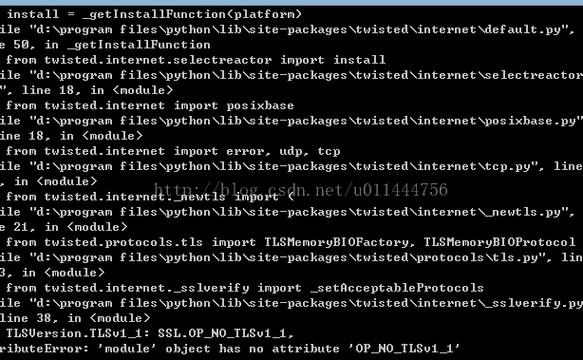

start_urls = ['https://movie.douban.com/']4. AttributeError: module 'OpenSSL.SSL' has no attribute 'SSLContext'

描述:

AttributeError: module 'OpenSSL.SSL' has no attribute 'SSLContext'

原因:

这是由于缺少cryptography库或版本不兼容导致的。

解决方法:

安装或升级cryptography库:使用pip进行安装或升级。

pip install cryptography upgrade检查依赖项:确保所有依赖项都已正确安装,并且版本兼容。

HTTP Error 403

描述:

HTTP Error 403: Forbidden

原因:

这是由于目标网站禁止了爬虫访问,通常是因为没有设置UserAgent或被检测到是爬虫行为。

解决方法:

设置UserAgent:在settings.py中添加默认的UserAgent。

USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'使用代理:通过代理服务器隐藏真实IP地址。

模拟浏览器行为:设置请求头中的其他参数,如Referer、Cookies等。

编码问题

描述:

UnicodeEncodeError: 'ascii' codec can't encode characters in position ...

原因:

这是由于爬取的数据包含非ASCII字符,而默认编码为ASCII导致的。

解决方法:

设置编码格式:在请求头中指定编码格式。

headers = {

'AcceptCharset': 'utf8'

}处理数据编码:在解析数据时显式转换编码。

response.body.decode('utf8')数据库连接问题

描述:

OperationalError: unable to open database file

原因:

这是由于数据库连接设置不正确或数据库服务未运行导致的。

解决方法:

检查数据库连接设置:确保数据库URL、用户名和密码正确。

启动数据库服务:确保数据库服务正在运行。

使用正确的数据库驱动:确保安装了适用于所选数据库的Python库,如sqlite3、psycopg2等。

日志问题

描述:

日志文件过于庞大或包含过多无用信息。

解决方法:

配置日志级别和输出格式:在settings.py中配置日志设置。

LOG_LEVEL = 'WARNING'

LOG_FILE = 'spider.log'

LOG_STDOUT = True使用RotatingFileHandler:限制日志文件大小并自动轮转。

from scrapy.utils.log import configure_logging

from logging.handlers import RotatingFileHandler

import logging

handler = RotatingFileHandler('spider.log', maxBytes=1024*1024*5, backupCount=5) # 每个日志文件最大5MB,保留5个备份

logger = logging.getLogger()

logger.addHandler(handler)

configure_logging(install_root_handler=False)

configure_logging(install_console_handler=True)FAQs

Q1: Scrapy安装过程中出现“缺少Microsoft Visual C++ 14.0”怎么办?

A1: 这是由于缺少编译Python扩展所需的编译器组件,可以通过以下步骤解决:

1、安装Visual C++ Build Tools:从微软官网下载并安装Visual C++ Build Tools。

2、安装特定版本的Build Tools:选择包含“vcvarsall.bat”的版本,通常选择与Python版本匹配的工具即可。

3、重启电脑:安装完成后,重启电脑以确保环境变量生效。

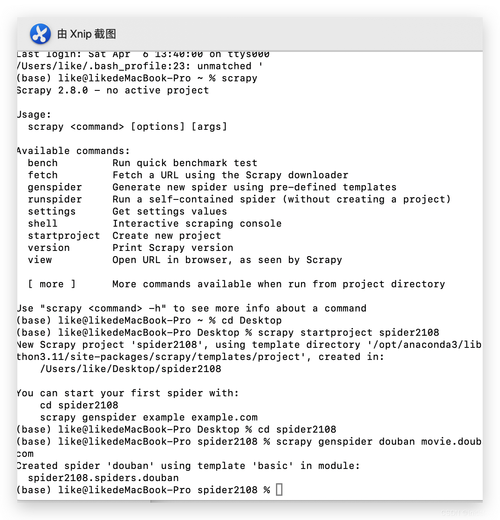

Q2: Scrapy运行时出现“Unknown command: crawl”怎么办?

A2: 这是由于当前目录下没有找到scrapy.cfg文件,导致Scrapy无法识别项目,可以通过以下步骤解决:

1、确认项目结构:确保项目目录下有scrapy.cfg文件。

2、创建新项目:如果文件丢失,可以重新创建一个Scrapy项目。

scrapy startproject myproject3、切换到项目目录:确保在终端或命令行中切换到包含scrapy.cfg文件的项目目录。

cd path/to/your/project4、运行命令:使用正确的命令运行Scrapy。

scrapy crawl yourspidername