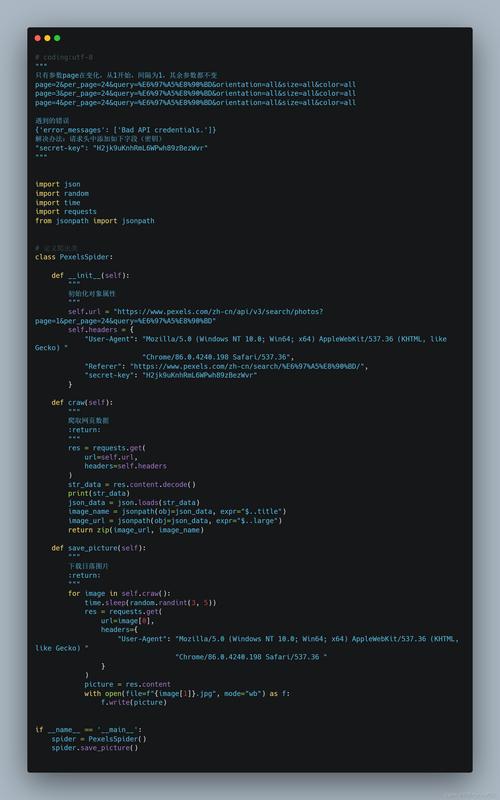

在Python爬虫开发过程中,报错是常见的现象,为了帮助开发者更好地解决这些问题,本文将汇总一些常见的爬虫报错及其解决方法,这些错误涵盖了网络请求、网页解析、数据存储等多个方面,通过详细的解释和示例代码,帮助开发者快速定位并解决问题。

常见爬虫报错及解决方法

1.AttributeError: 'NoneType' object has no attribute 'text'

原因:爬取的网页内容为空或未成功获取到HTML内容,导致后续操作失败。

解决方法:检查URL是否有效,确保网络请求成功,可以在获取响应后打印状态码和内容进行调试。

import requests

from bs4 import BeautifulSoup

url = "https://www.example.com"

response = requests.get(url)

if response.status_code == 200:

html_content = response.text

soup = BeautifulSoup(html_content, 'html.parser')

else:

print("Failed to retrieve content")2.HTTP Error 408: Request Timeout

原因:请求超时,通常是因为目标网站响应时间过长或网络不稳定。

解决方法:增加请求的超时时间,可以使用requests库的timeout参数进行设置。

response = requests.get(url, timeout=10) # 设置超时时间为10秒

3.HTTP Error 407: Proxy Authentication Required

原因:代理服务器需要认证。

解决方法:设置代理并传递认证信息。

proxies = {

'http': 'http://username:password@proxyserver:port',

'https': 'http://username:password@proxyserver:port',

}

response = requests.get(url, proxies=proxies)4.HTTP Error 429: Too Many Requests

原因:访问频率过高,被目标网站封禁。

解决方法:降低爬取频率,使用time模块进行适当的延迟。

import time

for i in range(10):

response = requests.get(url)

time.sleep(1) # 每次请求间隔1秒5.JSONDecodeError: Expecting value: line 1 column 1 (char 0)

原因:JSON格式错误或缺少有效的JSON值。

解决方法:检查JSON数据的格式是否正确,或者捕获异常进行处理。

try:

data = json.loads(response.text)

except json.JSONDecodeError as e:

print("JSON decode error:", e)6.UnicodeDecodeError: 'utf8' codec can't decode byte...

原因:网页编码不正确。

解决方法:确认网页的编码方式,并在解析网页时指定正确的编码方式。

response.encoding = 'gbk' # 根据具体情况设置正确的编码方式 html_content = response.text

7.Invalid URL

原因:URL格式不正确。

解决方法:检查URL是否有效,确保协议、域名和路径等部分正确无误,可以使用在线的URL校验工具进行验证。

from urllib.parse import urlparse

parsed_url = urlparse(url)

if parsed_url.scheme and parsed_url.netloc:

response = requests.get(url)

else:

print("Invalid URL")8.list index out of range

原因:尝试访问列表中不存在的索引。

解决方法:检查列表长度,确保索引在有效范围内。

data = [1, 2, 3]

if len(data) > 2:

print(data[2])

else:

print("Index out of range")相关FAQs

Q1: 如何避免爬虫被目标网站封禁?

A1: 可以通过以下几种方法避免被封禁:

设置合理的访问频率,使用time模块进行延迟。

使用代理IP,避免单一IP频繁访问。

模拟浏览器行为,设置UserAgent和Cookie等信息。

使用随机UserAgent,避免被识别为爬虫。

Q2: 如何处理网页中的验证码?

A2: 处理验证码的方法包括:

手动输入验证码。

使用第三方服务进行验证码识别(如打码平台)。

尝试绕过验证码,例如通过分析请求头和Cookie信息找到绕过的方法。

Python爬虫开发中遇到的报错多种多样,但大多数问题都可以通过仔细检查代码、调试输出和查阅文档来解决,掌握这些常见报错及其解决方法,可以帮助开发者更高效地编写和维护爬虫程序。