在使用PySpark时,可能会遇到各种各样的错误,下面将详细探讨一些常见的错误以及其解决方法,并通过表格形式列出相关解决方案。

PySpark常见报错及其解决方法

| 错误类型 | 报错信息 | 可能原因 | 解决方法 |

| No module named 'pyspark' | 当使用sparksubmit运行PySpark文件时,可能会遇到以下错误信息:No module named 'pyspark'。 | sparksubmit默认只加载Spark的主要库,而PySpark不在其中。 | 通过添加pyfiles参数来将PySpark的库文件添加到sparksubmit的Python路径中。$ sparksubmit pyfiles /path/to/pyspark.zip my_script.py |

| java.lang.OutOfMemoryError | 在使用sparksubmit运行大规模的数据处理任务时,可能会遇到java.lang.OutOfMemoryError错误。 | 默认情况下,Spark为执行任务分配的内存较小。 | 通过增加drivermemory和executormemory参数来增大内存分配。$ sparksubmit drivermemory 4g executormemory 2g my_script.py |

| org.apache.spark.SparkException: PySpark requires the Py4j gateway | 当使用sparksubmit运行PySpark文件时,可能会遇到org.apache.spark.SparkException: PySpark requires the Py4j gateway错误。 | PySpark需要与Py4j进行通信以实现Python与Java之间的交互。 | 使用jars参数来添加py4j的jar文件路径。$ sparksubmit jars /path/to/py4j.jar my_script.py |

| TypeError: 'JavaPackage' object is not callable | 在使用sparksubmit运行PySpark文件时,可能会遇到TypeError: 'JavaPackage' object is not callable错误。 | 编码错误,如在代码中错误地调用了Java对象或包。 | 检查代码并纠正调用错误。 |

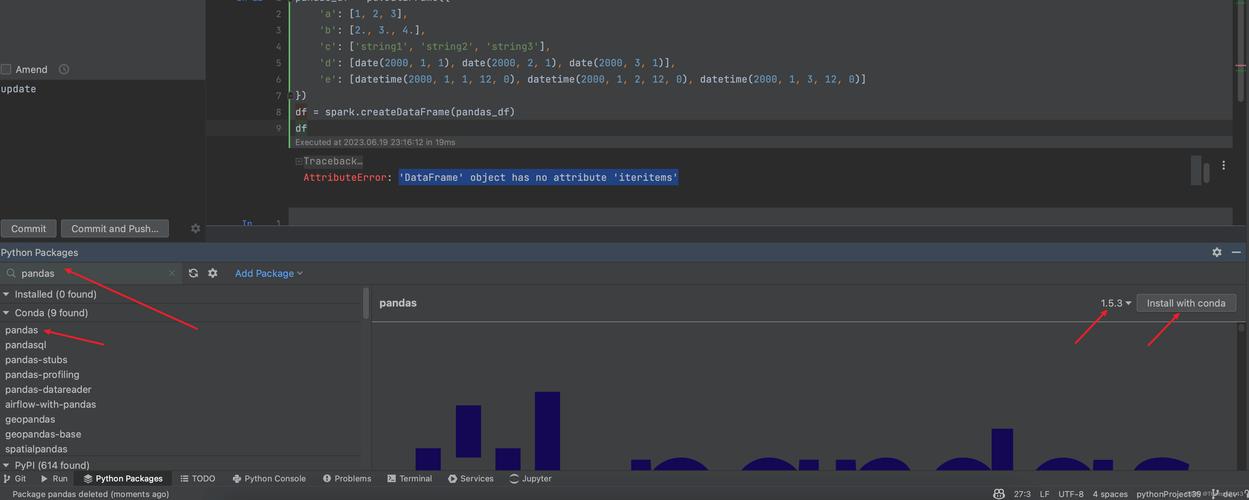

| pyspark版本不匹配 | 例如我当前集群环境Spark3.0.0,python的pyspark3.5.0,没有指定版本默认下载最新的。 | pyspark版本与Spark环境不匹配。 | 替换pyspark版本与spark版本一致。 |

| zipimport.ZipImportError: can’t decompress data; zlib不可用 | 在安装pyspark过程中会报一个错误:zipimport.ZipImportError: can’t decompress data; zlib不可用。 | Python环境中缺少zlib模块。 | 确保安装了zlib模块,可以通过以下命令安装:sudo aptget install zlib1gdev |

| JAVA_HOME is not set | 执行如下 pyspark_model.py 的python脚本,构建SparkSession来执行sparksql,报错信息 [JAVA_HOME is not set]。 | JAVA_HOME环境变量未设置。 | 设置JAVA_HOME环境变量,export JAVA_HOME=/opt/jdk1.8 |

| Py4JError: An error occurred while calling o46.fit | PySpark遇到错误Py4JError: An error occurred while calling o46.fit通常表示在Spark作业执行时,可能出现了跨进程通信错误或者是某个Spark操作失败。 | 可能是由于不正确的数据类型、缺失依赖库、资源限制或是代码逻辑问题。 | 检查数据类型、确保所有必要的依赖库已安装、调整资源分配或修正代码逻辑。 |

FAQs

Q1:如何解决“No module named 'pyspark'”错误?

A1:这个错误通常是因为sparksubmit默认只加载Spark的主要库,而PySpark不在其中,解决方法是通过添加pyfiles参数来将PySpark的库文件添加到sparksubmit的Python路径中。$ sparksubmit pyfiles /path/to/pyspark.zip my_script.py。

Q2:如何应对“java.lang.OutOfMemoryError”错误?

A2:这个错误通常发生在运行大规模数据处理任务时,因为默认情况下,Spark为执行任务分配的内存较小,解决方法是通过增加drivermemory和executormemory参数来增大内存分配。$ sparksubmit drivermemory 4g executormemory 2g my_script.py。

在使用PySpark时,可能会遇到各种错误,但大多数错误都可以通过仔细检查代码、配置环境变量、安装必要的依赖库或调整资源分配来解决,希望以上内容能帮助您更好地理解和解决PySpark中的常见错误。