Spark Lambda 报错?别慌,咱一起搞定它!

在大数据的江湖里,Spark Lambda 本应是咱们得心应手的“神兵利器”,可一旦报错,是不是瞬间就有点懵圈?别着急,今天咱就来唠唠这 Spark Lambda 报错的那些事儿,让新手小白也能轻松应对,不再害怕。

一、啥是 Spark Lambda 报错?

先给大伙简单说说,Spark Lambda 报错,就是在咱用 Spark 框架处理数据,特别是通过 Lambda 函数式编程那套玩法的时候,程序跑着跑着突然“翻车”了,给出一堆错误提示,就好比你正开着车在大数据的高速公路上飞驰,结果突然“砰”的一下,故障灯亮了,这时候就得赶紧找原因,不能让它把咱的数据分析大业给耽误了不是?

二、为啥会报错呢?

这就得好好扒一扒了,原因可能五花八门。

代码写错了:咱写代码就像盖房子,一砖一瓦都得码放整齐,要是语法不对,比如括号没配对,关键字拼错,那肯定不行,比如说,本来该写“val data = ...”,结果写成“vla data = ...”,这就闹笑话了,程序立马就不认咱,报错也就来了,就好比你说话说错字,别人听不懂,事儿也办不成。

数据出问题了:数据可是 Spark 的“食材”,要是“食材”不新鲜或者有问题,那做出来的“数据分析大餐”肯定不行,可能是数据格式不对,比如说人家要求是数字格式,结果你给塞了一串字符进去;也可能是数据缺失,本来一组完整的用户信息,少了个关键字段,这就像做饭少放了重要调料,味道肯定不对,举个例子,你要分析用户的年龄分布,结果年龄那一列好多都是空值,那分析出来的结果能准吗?肯定不行,报错也就随之而来。

依赖没配好:Spark 运行得靠各种依赖包,就像汽车得有汽油才能跑,如果这些依赖没安装全或者版本不兼容,也会报错,比如你用了某个新版本的 Spark 功能,但是对应的依赖库还是老版本的,那它们之间就可能“掐架”,程序就没办法正常运行了。

三、咋解决这些报错呢?

遇到报错别慌,咱有办法。

看报错信息:报错信息就是程序给咱的“求救信号”,一定要仔细看,报错信息里会有个错误代码和错误提示,就像医生看病的诊断书一样,比如说,如果看到“NullPointerException”,咱就知道肯定是有地方用到空指针了,那就顺着报错的代码行往上找,看看是哪个变量没初始化或者哪里返回了空值。

检查代码逻辑:把代码从头捋一遍,看看有没有不合理的地方,就像检查电路一样,每个节点都得看看通不通,可以打印一些关键变量的值,看看数据在程序里是怎么流转的,比如说,你在处理一个数据集合,怀疑中间某个转换步骤出了问题,那就在这个步骤前后打印一下集合的内容和长度,看看数据是不是丢了或者变了样。

核对数据:如果是数据问题导致的报错,那就得好好检查数据了,可以先看看数据的原始格式对不对,用一些简单的工具或者命令先预览一下数据,要是数据量不大,甚至可以手动检查一下关键部分的数据,比如说,你发现某个字段的值总是异常,那就得想想是数据采集环节出了问题,还是数据本身的错误,然后针对性地解决。

四、举几个常见的报错例子

示例一:语法错误

报错信息:“error: not found: value map”

原因:这里把“map”这个关键字拼错了,可能是写成了“mapp”或者其他错误的拼写方式。

解决方法:找到出错的那一行代码,仔细检查拼写,改正为正确的“map”,然后再运行程序,看看问题是否解决。

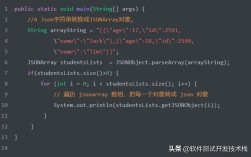

示例二:数据格式错误

报错信息:“java.lang.NumberFormatException: For input string: “abc””

原因:程序期望得到数字格式的数据,但是实际上却读取到了字符串“abc”。

解决方法:检查数据源,看看这个字段的数据格式是否正确,如果是从文件读取的数据,可以用文本编辑器打开文件,检查一下对应字段的内容,如果是从数据库读取的,那就得看看数据库里的数据类型定义和实际存储的数据是否一致,可以在读取数据后,添加一些数据格式转换和验证的代码,确保数据格式正确。

五、怎么预防这些报错呢?

咱可不能每次都等报错了才去解决问题,还得提前做好预防措施。

写好代码规范:就像写字要有笔顺一样,写代码也得有规范,变量命名要清晰明了,让人一看就知道是啥意思;代码缩进要整齐,这样结构才清晰;多写注释,方便自己以后回头看,也方便别人理解你的代码,比如说,你写了一个复杂的数据处理流程,在每个关键的步骤都写上注释,解释为什么要这么做,这样下次再看的时候就不会一脸懵了。

提前检查数据质量:在把数据放进 Spark 里处理之前,先对数据进行清洗和验证,可以写一些小脚本或者用专门的数据质量检查工具,看看数据是否符合要求,比如说,统计一下各个字段的空值率、异常值情况,要是发现问题,提前处理好再进行后续的分析。

及时更新知识和技能:Spark 的技术也在不断发展,新的版本会有新的特性和变化,咱得跟上时代的步伐,多学习新的知识和技能,看看官方文档、技术博客,参加一些线上课程或者技术论坛,了解最新的动态和最佳实践,这样在遇到问题的时候,就能有更多的思路和方法去解决。

其实啊,Spark Lambda 报错并不可怕,只要咱保持冷静,按照正确的方法去排查和解决,就一定能把它拿下,每一次解决报错的过程,也是咱技术进步的机会,就像玩游戏闯关一样,过了这一关,咱的大数据技能又上了一个新台阶,希望大家以后在遇到 Spark Lambda 报错的时候,都能像个高手一样从容应对,顺利搞定数据分析的任务!