Flume报错信息解析与解决方案

在使用apache Flume进行日志收集或数据传输时,用户可能会遇到各种报错信息,这些错误不仅影响数据管道的正常运行,还可能对业务造成潜在风险,本文将针对常见的Flume报错场景,分析其产生原因并提供解决方案,帮助开发者快速定位问题,提升系统稳定性。

一、常见Flume报错类型及原因

1、Channel容量不足导致数据丢失

报错示例:Channel full exception: Unable to add event to channel

原因分析:Flume的Channel(如Memory Channel)容量有限,当Source生产数据的速度超过Sink消费能力时,Channel会迅速填满,触发此错误。

解决方案:

- 增大Channel的capacity和transactionCapacity参数。

- 优化Sink性能,例如增加Sink线程数(sink.threads)或调整批量提交大小(batchSize)。

- 若对数据可靠性要求不高,可改用File Channel替代Memory Channel。

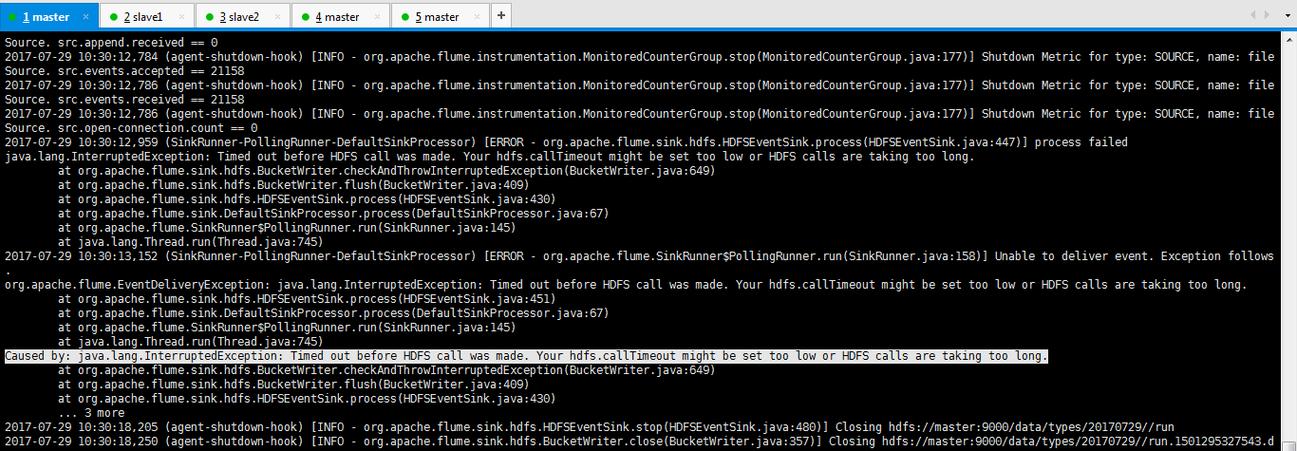

2、Sink写入目标失败

报错示例:Failed to send events to HDFS. Check HDFS availability

原因分析:目标存储(如HDFS、Kafka)连接超时、权限不足或配置错误。

解决方案:

- 检查网络连通性及目标服务状态。

- 验证权限配置(如Kerberos认证、HDFS路径权限)。

- 调整Sink的重试策略,例如增加retry次数和超时时间。

3、Source配置错误或数据格式异常

报错示例:Unsupported source type 或Failed to deserialize event

原因分析:Source类型配置错误(如误用HTTP Source处理二进制数据),或数据格式与解析器不兼容。

解决方案:

- 确认Source类型(如Exec Source、Spooling Directory Source)与数据源匹配。

- 为自定义数据格式实现反序列化接口,或使用内置解析器(如JSONHandler)。

4、内存溢出(OOM)问题

报错示例:java.lang.OutOfMemoryError: Java heap space

原因分析:Channel或Sink处理大量数据时,JVM堆内存分配不足。

解决方案:

- 调整JVM参数(如-Xmx和-Xms)增加堆内存。

- 减少单个批次处理的事件数量(batchSize)。

- 监控堆内存使用情况,避免内存泄漏。

**二、进阶排查技巧

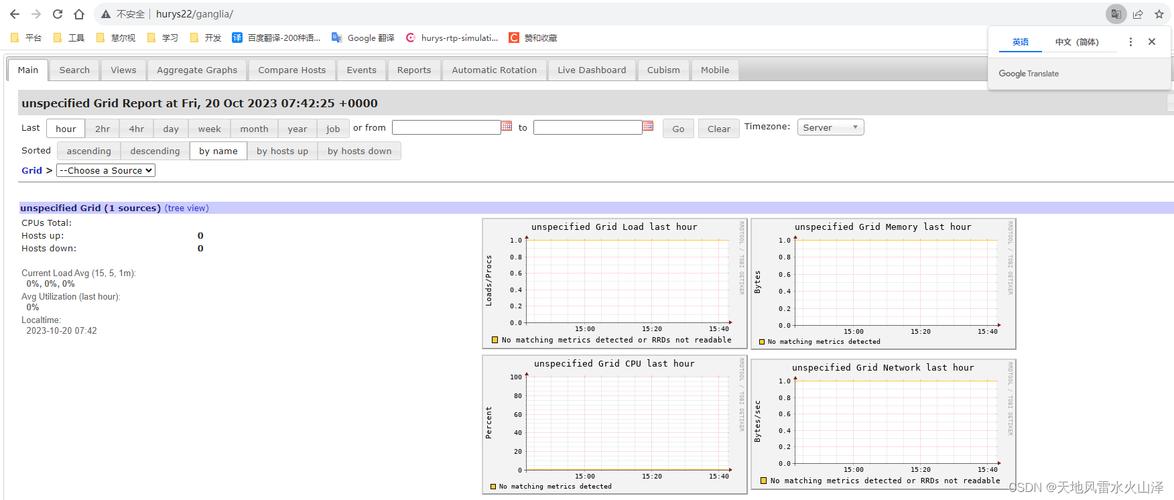

1、日志分析与关键指标监控

Flume的日志文件(默认位于logs/flume.log)是排查问题的核心依据,重点关注以下内容:

WARN/ERROR级别日志:直接反映错误类型及发生位置。

事务提交记录:检查Channel到Sink的事务是否正常提交。

线程状态:确认Source、Channel、Sink的线程是否阻塞或异常终止。

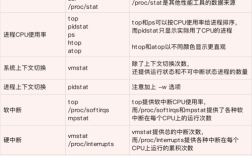

建议结合监控工具(如Prometheus+Grafana)实时跟踪以下指标:

- Channel的当前容量与剩余容量。

- Sink的成功/失败事件计数。

- JVM内存使用率及GC频率。

2、配置优化建议

参数调优:

- 对于高吞吐场景,适当增大batchSize(如从100调整为1000)以提升批量处理效率。

- 调整keep-alive时间,避免因网络波动导致连接中断。

容错机制:

- 启用Channel的byteCapacity限制,防止内存耗尽。

- 配置Sink的backoff策略,在目标不可用时自动降级。

**三、预防性措施

1、环境预检与压力测试

部署Flume前,需对运行环境进行全面检查:

- 确认JDK版本兼容性(推荐JDK 8或11)。

- 测试网络带宽及目标存储的写入性能。

- 通过模拟流量进行压力测试,验证配置的合理性。

2、规范化日志管理

- 为不同组件(Source、Channel、Sink)分配独立的日志文件,便于隔离问题。

- 使用Log4j自定义日志格式,添加时间戳、线程ID等关键信息。

3、定期维护与更新

- 监控社区发布的版本更新,及时修复已知漏洞。

- 定期清理Channel持久化数据(如File Channel的Checkpoint文件),避免磁盘占满。

个人观点

Flume作为高可靠的数据传输工具,其报错信息往往与配置细节或环境稳定性强相关,在实际运维中,开发者需建立系统化的监控体系,结合日志分析与性能调优,才能从根本上降低故障率,建议深入理解Flume的架构设计(如Agent内部的多线程模型),这将大幅提升问题排查效率,遇到复杂问题时,不妨从官方文档或社区案例中寻找灵感,避免重复“踩坑”。