在程序开发或数据处理过程中,遇到decode报错104是许多开发者头疼的问题,这类报错通常与编码转换、数据解析或网络传输异常相关,但具体原因可能因场景不同而千差万别,本文将从实际案例出发,剖析报错的常见诱因,并提供可落地的解决方案,帮助开发者快速定位问题。

一、decode报错104的典型场景

1、数据格式不匹配

当程序尝试解析一段不符合预期格式的数据时,可能触发该错误,用JSON解析器处理非标准JSON字符串,或读取二进制文件时未指定正确的编码格式(如UTF-8、GBK)。

实际案例:某电商平台在接收第三方API返回数据时,因未处理特殊字符(如未转义的双引号),导致JSON解析失败并抛出decode error 104。

2、网络传输异常

数据在传输过程中若发生丢包或截断,接收端可能因数据不完整而无法解码,常见于大文件分块传输或高并发场景。

示例:某视频网站用户上传文件时,因网络波动导致服务器仅接收到部分数据,后端尝试解析时触发报错。

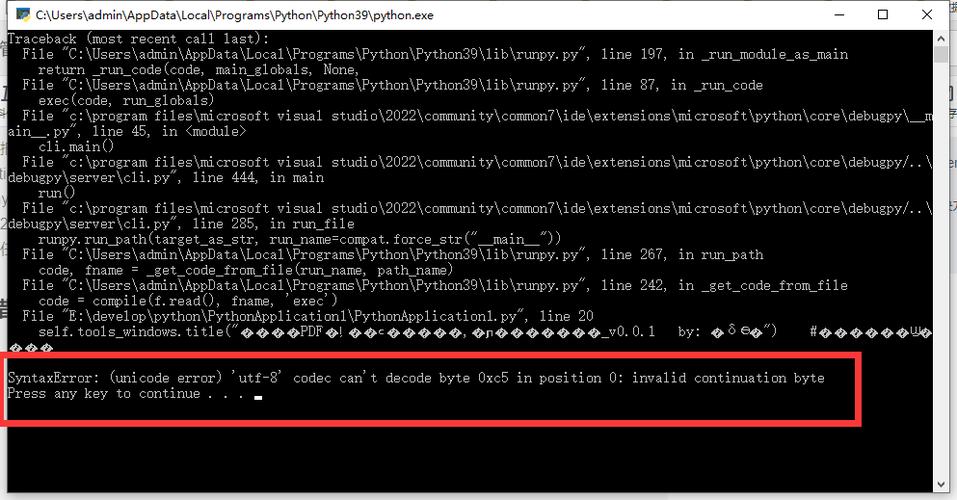

3、编码声明缺失或错误

当文件或数据流未明确声明编码方式,程序可能按默认编码(如ASCII)强制解码,遇到非ASCII字符(如中文)时直接报错。

二、分步骤排查与修复方案

第一步:检查原始数据完整性

- 对于本地文件:使用十六进制编辑器(如Hex Fiend)查看文件头,确认实际编码是否与声明一致。

- 对于网络请求:通过抓包工具(如Wireshark)验证数据是否完整接收,重点关注HTTP响应头中的Content-Length与实际数据量是否匹配。

第二步:统一编码格式

- 强制指定编码:在Python中可尝试data.decode('utf-8', errors='ignore')跳过非法字符,但需谨慎使用以避免数据丢失。

- 转换编码标准:若数据来源为GBK编码而系统使用UTF-8,可使用iconv工具批量转码:

- iconv -f GBK -t UTF-8 input.txt > output.txt

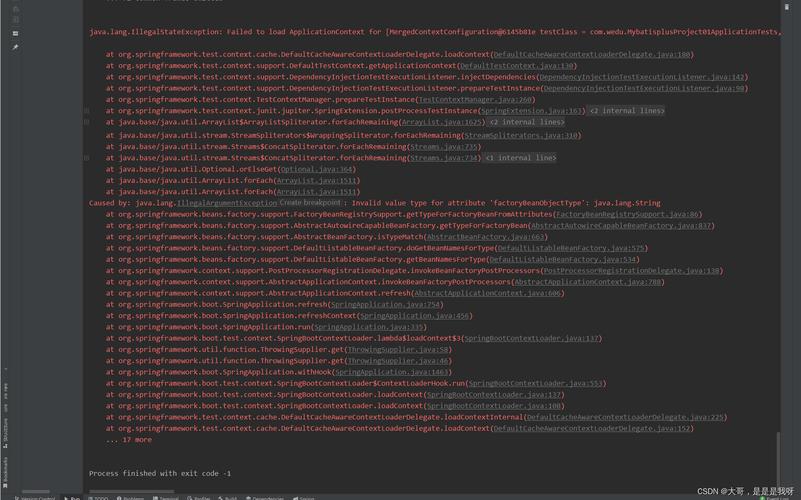

第三步:添加异常处理机制

在关键代码段包裹try-except语句,捕获解码异常并记录日志,避免程序直接崩溃:

- try:

- decoded_data = response.content.decode('utf-8')

- except UnicodeDecodeError as e:

- log_error(f"解码失败:{str(e)},原始数据片段:{response.content[:50]}")

- # 可选:尝试其他编码或返回默认值

三、预防性设计建议

1、明确数据协议规范

在与第三方系统交互时,应在技术文档中强制约定数据格式(如JSON Schema)、编码标准及传输方式,并在接入阶段增加自动化校验测试。

2、使用容错性更强的工具库

- 替换标准JSON库为demjson(支持非严格模式解析);

- 处理含混合编码的文本时,可采用ftfy(Fix Text For You)库自动修正常见编码错误。

3、监控与告警自动化

通过ELK(Elasticsearch、Logstash、Kibana)搭建日志分析系统,对解码错误进行实时统计,设置阈值告警,当单位时间内错误次数超过预期时,自动触发排查流程。

四、关于decode报错104的个人观点

作为经历过多次类似问题的开发者,我认为这类错误的本质往往是“数据与预期的不一致性”,与其在报错后紧急修复,不如在系统设计阶段强化数据校验机制,在API网关层增加数据格式预检功能,或采用Protobuf等强类型序列化协议替代JSON。

另一个常被忽视的细节是团队协作中的规范管理,曾遇到因某成员提交代码时未统一编码声明,导致测试环境与生产环境解析结果不一致,建议将编码检查纳入CI/CD流程,通过工具(如pre-commit钩子)自动拦截不符合规范的代码提交。

面对decode报错104,保持耐心逐层排查比盲目修改更重要,从数据源头到解析逻辑,每一步都可能成为故障点,而清晰的日志记录和版本控制往往是破局的关键。