在处理Hadoop报错时,了解和解决这些错误对于确保大数据处理平台的稳定性和效率至关重要,以下是关于常见Hadoop错误的详细分析、原因以及解决方案。

常见Hadoop报错及其解决方法

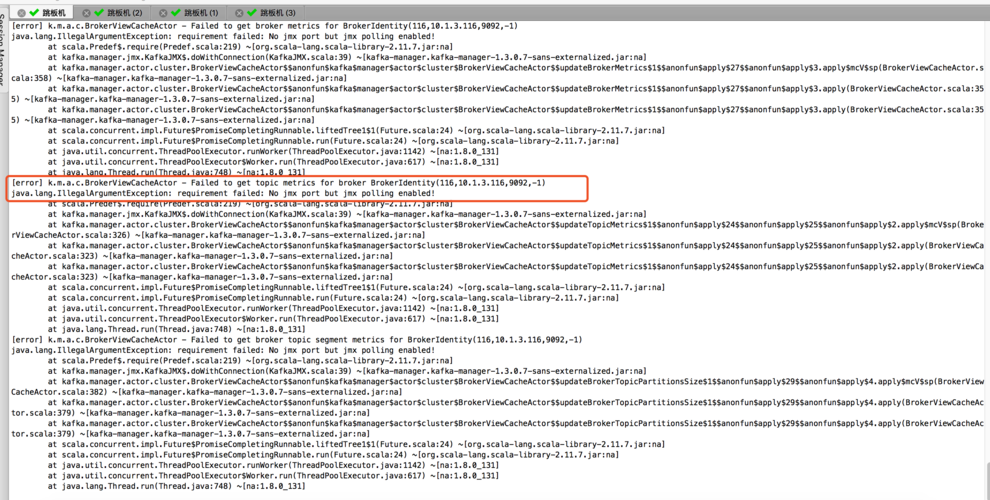

1. YARN ResourceManager报错

描述: YARN(Yet Another Resource Negotiator)是Hadoop的资源管理层,负责管理集群中的计算资源,常见的YARN ResourceManager报错包括内存不足、节点失效等。

可能原因:

内存不足: YARN ResourceManager分配的内存不足以处理当前的作业负载。

节点失效: 某些节点无法正常通信或响应,导致资源分配失败。

解决方法:

增加内存: 通过调整YARN配置文件(yarnsite.xml),增加ResourceManager的内存分配。

检查网络连接: 确保所有节点之间的网络连接正常,并排除硬件故障。

重启节点: 如果某个节点失效,可以尝试重启该节点,或者将其从集群中移除并添加新的节点。

2. HDFS NameNode报错

描述: HDFS(Hadoop Distributed File System)是Hadoop的分布式文件系统,NameNode是其核心组件,负责管理文件系统的命名空间和控制客户端对文件的访问,常见的NameNode报错包括元数据损坏、磁盘空间不足等。

可能原因:

元数据损坏: 由于意外重启或其他原因,导致NameNode的元数据损坏。

磁盘空间不足: NameNode所在的磁盘空间不足,无法存储更多的元数据信息。

解决方法:

备份与恢复: 定期备份NameNode的元数据,并在出现损坏时进行恢复。

增加磁盘空间: 通过增加存储设备或清理不必要的文件来释放磁盘空间。

优化配置: 调整HDFS的配置参数,例如增加副本数量或调整块大小,以优化存储效率。

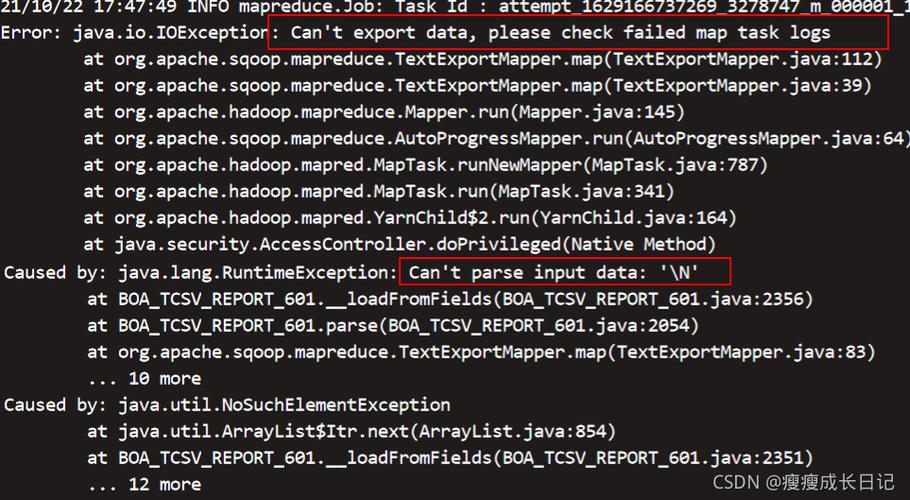

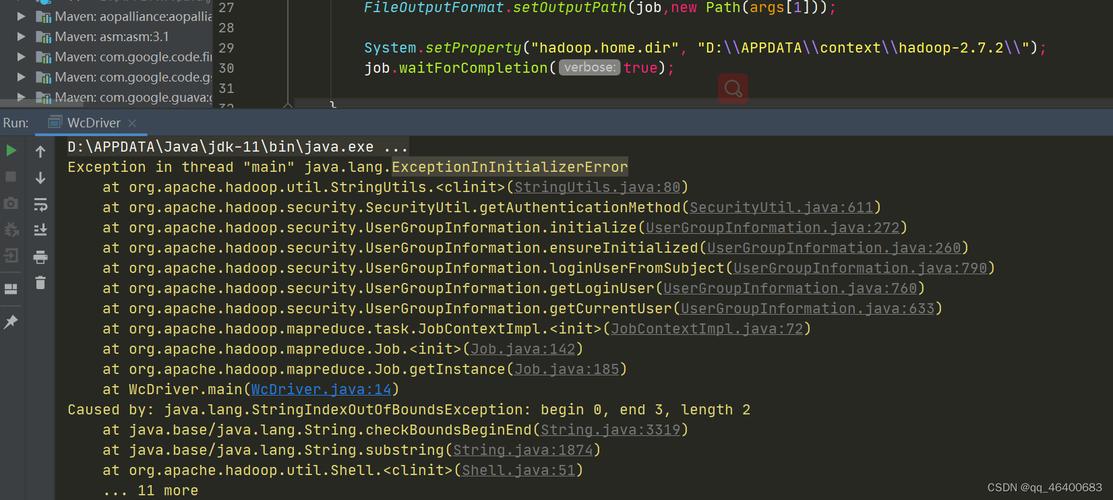

3. MapReduce任务失败

描述: MapReduce是Hadoop的编程模型,用于大规模数据处理,常见的MapReduce任务失败包括任务超时、内存溢出等。

可能原因:

任务超时: 某些任务执行时间过长,超过了预设的时间限制。

内存溢出: 任务执行过程中使用的内存超过了JVM的限制。

解决方法:

调整超时设置: 根据任务的实际需求,调整MapReduce任务的超时设置。

增加内存分配: 通过调整MapReduce的配置参数,增加任务执行过程中可用的内存。

优化代码: 检查并优化MapReduce任务的代码,减少不必要的内存使用。

相关问答FAQs

问题1:如何预防Hadoop集群中的节点失效?

回答: 为预防节点失效,可以采取以下措施:定期对集群中的节点进行健康检查和维护,确保硬件和软件环境的稳定性;配置适当的冗余和容错机制,例如使用多个副本和备用节点;监控集群的性能指标,及时发现并处理潜在的问题。

问题2:如何处理Hadoop作业提交失败的问题?

回答: 如果Hadoop作业提交失败,首先应查看错误日志以确定具体的错误原因;然后根据错误信息调整作业配置或代码;如果问题依然存在,可以尝试重启ResourceManager或NameNode服务;如果问题仍未解决,可以考虑升级Hadoop版本或寻求社区支持。

分析和建议旨在帮助用户更好地理解和解决Hadoop运行中的常见问题,通过细致的排查和合理的配置调整,可以有效提升Hadoop集群的稳定性和性能。