深入剖析Hadoop启动报错"p":运维实战指南

当Hadoop集群启动时遭遇神秘的"p"报错,对运维团队而言往往意味着一个不眠之夜的开端,这类报错信息模糊,却可能导致整个大数据处理流水线陷入停滞,本文将带你直击问题核心,提供系统化的排查与解决方案。

Hadoop启动报错"p"的常见根源

端口占用:隐形"杀手"

Hadoop的核心服务(NameNode, DataNode, ResourceManager, NodeManager等)均依赖特定端口通信,若端口被其他进程抢占(如残留进程、其他应用),启动时将因端口冲突直接失败,常以"p"形式提示绑定错误,使用netstat -tuln | grep <端口号>或lsof -i :<端口号>快速锁定占用者。配置失当:细节决定成败

core-site.xml,hdfs-site.xml,yarn-site.xml等配置文件中的参数错误是高频诱因:- 关键路径缺失/无权访问:

hadoop.tmp.dir指向的临时目录未创建、权限不足(需chmod -R 755)或磁盘空间耗尽。 - 主机名/IP解析异常: 配置文件中使用的主机名无法在集群节点间正确解析(检查

/etc/hosts和 DNS),或使用了错误的网络接口地址。 - 服务绑定IP错误: 服务配置为仅监听

0.0.1(localhost),导致其他节点无法访问。

- 关键路径缺失/无权访问:

资源枯竭:被忽视的瓶颈

启动过程中若系统资源(内存、文件句柄、进程数)不足,JVM 可能无法正常初始化关键组件,监控系统资源使用情况 (free -h,ulimit -a) 至关重要。环境变量缺失:基础中的基础

JAVA_HOME未设置或指向错误路径、Hadoop 自身环境变量(如HADOOP_HOME,HADOOP_CONF_DIR)配置不正确,使启动脚本无法定位必要依赖。版本冲突或文件损坏:隐藏的陷阱

Hadoop 二进制文件或依赖库(如 Hadoop native lib)版本不匹配、下载不完整或意外损坏,校验文件完整性并确保环境统一。

系统化诊断流程:精准定位问题

日志先行: 立即查阅相关服务的日志文件(

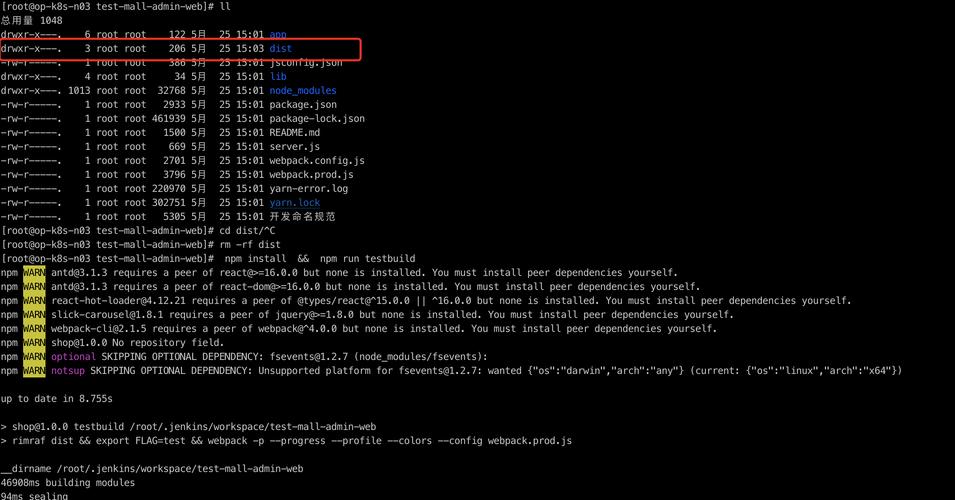

$HADOOP_HOME/logs/下对应服务的*.log及*.out文件)。"p"报错通常伴随更详细的堆栈跟踪信息,是诊断的金钥匙,关键词搜索 "ERROR", "FATAL", "Exception", "bind", "address already in use"。服务隔离启动: 避免在集群所有节点同时执行

start-all.sh,优先单独启动 HDFS:$HADOOP_HOME/sbin/start-dfs.sh观察 NameNode 和 DataNode 日志,成功后再启动 YARN:

$HADOOP_HOME/sbin/start-yarn.sh精确定位故障子系统。

网络与端口验证:

- 在目标节点执行

jps,检查预期 Hadoop 守护进程是否存在。 - 使用

telnet <主机名> <端口>测试服务端口是否可达(如 NameNode 的 8020/9000, ResourceManager 的 8032)。 - 检查集群节点间防火墙规则是否放行必要端口通信。

- 在目标节点执行

配置复审: 逐行核对核心配置文件,特别是涉及路径、主机名、端口和地址绑定的参数,利用

hadoop checknative命令验证本地库状态。资源核查: 检查启动节点的内存、磁盘空间、ulimit 设置(特别是

nproc和nofile),确保满足 Hadoop 要求。

针对性解决方案集锦

解决端口冲突:

- 终止占用端口的无关进程 (

kill -9 <PID>)。 - 若为残留 Hadoop 进程,使用

stop-all.sh后彻底清理 (jps确认后再kill)。 - (谨慎)修改 Hadoop 配置文件,为冲突服务更换非默认端口。

- 终止占用端口的无关进程 (

修正配置错误:

- 确保

hadoop.tmp.dir存在且权限正确 (mkdir -p;chmod -R 755)。 - 验证所有配置文件中使用的主机名/IP 在

/etc/hosts或 DNS 中一致可解析,建议使用 IP 地址或配置全集群统一的 hosts/DNS。 - 检查服务绑定地址(如

dfs.namenode.rpc-address,yarn.resourcemanager.address),确保绑定到正确网络接口(0.0.0或特定 IP),非仅localhost。 - 核对

fs.defaultFS(HDFS 地址) 和yarn.resourcemanager.hostname等关键参数无误。

- 确保

补充资源与环境:

- 清理磁盘空间或扩容。

- 调整系统 ulimit (

/etc/security/limits.conf) 或为 Hadoop 用户单独配置足够资源。 - 确认

~/.bashrc或/etc/profile中JAVA_HOME,HADOOP_HOME,HADOOP_CONF_DIR等环境变量正确设置并生效 (source后echo $VAR验证)。

处理版本与文件问题:

- 重新下载或分发完整、版本一致的 Hadoop 发行包。

- 确保 Hadoop native lib (

$HADOOP_HOME/lib/native/) 存在且与系统架构匹配。

构建稳健防线:预防胜于修复

- 配置管理自动化: 使用 Ansible, Puppet, Chef 等工具集中管理配置文件,确保集群配置一致性和版本控制,变更前备份是铁律。

- 资源监控常态化: 部署 Prometheus+Grafana, Zabbix 等工具,实时监控磁盘、内存、端口状态、Hadoop 服务健康度。

- 主机名/IP 策略: 生产环境强烈建议使用静态 IP 或稳定可靠的内网 DNS 解析,避免依赖易变的

/etc/hosts。 - 权限最小化: 为 Hadoop 服务创建专用系统用户,严格控制目录和文件权限。

- 变更沙盒化: 任何配置或版本升级先在测试环境充分验证。

大数据平台的稳定性,往往建立在对基础细节的极致把控之上,每一次成功的集群启动,都源于对端口、路径、配置项这些"平凡"要素的敬畏,与其被动应对报错,不如将资源监控、配置审计、环境校验融入日常运维的血液——让"p"不再成为深夜警报的起点,而是系统健壮性的一次无声验证。