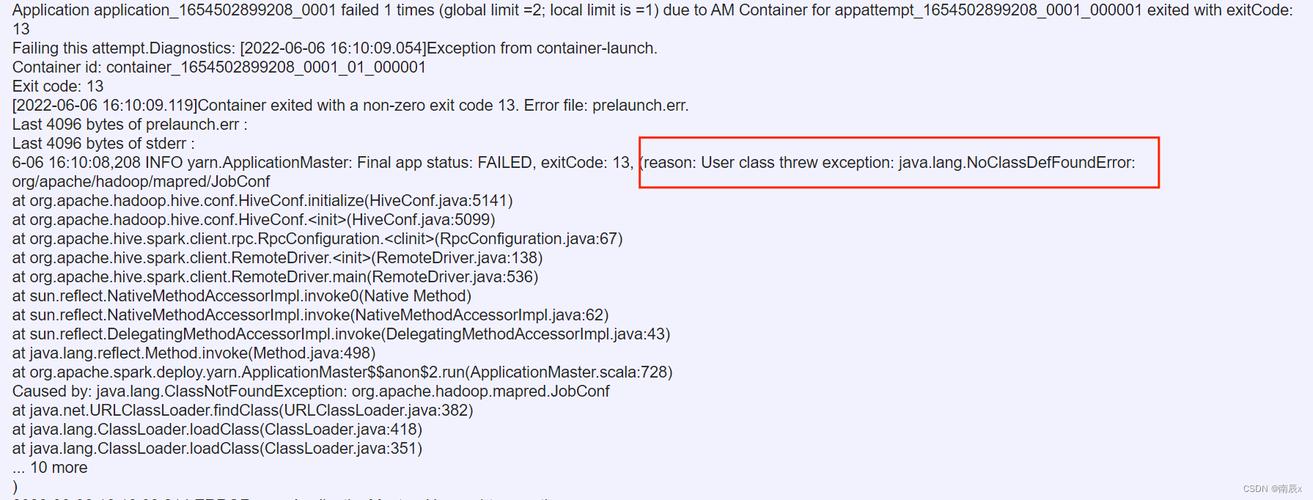

apache Spark 是一个开源的分布式计算系统,广泛用于大数据处理和分析,由于其复杂性和广泛的应用场景,用户在使用 Spark 时可能会遇到各种错误和问题,本文将详细探讨一些常见的 Spark 报错及其解决方案,并附上相关问答 FAQs。

常见 Spark 报错及解决方案

1.java.lang.OutOfMemoryError: Java heap space

原因:这是由于 JVM 堆内存不足造成的,当 Spark 任务需要处理的数据量超出分配给 JVM 的堆内存时,就会抛出这个错误。

解决方案:

增加堆内存:可以通过调整 Spark 提交命令中的executormemory 和drivermemory 参数来增加堆内存。

```bash

sparksubmit class com.example.MyApp \

master local[*] \

executormemory 4G \

drivermemory 4G \

myapp.jar

```

优化数据分区:合理设置 RDD 的分区数,避免过多的数据集中到少数几个分区中。

使用广播变量:对于大字典或大数据集,可以使用广播变量来减少内存消耗。

2.org.apache.spark.SparkException: Task not serializable

原因:这是由于 Spark 在序列化任务以进行网络传输时遇到了不可序列化的对象。

解决方案:

检查闭包:确保所有在map、reduce 等操作中使用的变量都是可序列化的。

使用广播变量:如果需要在多个任务之间共享大型不可变对象(如大字典),可以使用广播变量。

避免懒加载:有时 Spark 的惰性求值机制会导致对象未及时序列化,可以尝试调用.collect() 等行动操作来触发实际计算。

3.java.lang.IllegalArgumentException: requirement failed: No output path specified for the job

原因:这是由于在保存结果时没有指定输出路径。

解决方案:

指定输出路径:在使用saveAsTextFile、parquet 等方法保存结果时,必须指定一个有效的输出路径。

```scala

val output = sc.textFile("input.txt").flatMap(line => line.split(" ")).distinct()

output.saveAsTextFile("output")

```

4.org.apache.hadoop.mapred.InvalidInputException: Input path does not exist

原因:输入路径不存在或不正确。

解决方案:

检查路径:确保输入路径存在且格式正确。

使用通配符:如果输入是多个文件,可以使用通配符。

```scala

val input = sc.textFile("hdfs://namenode:port/path/*.txt")

```

5.org.apache.spark.shuffle.FetchFailedException: Unable to find any valid block

原因:Shuffle 过程中找不到有效的块,通常是由于 Shuffle 文件丢失或损坏。

解决方案:

检查磁盘空间:确保集群节点上的磁盘空间充足。

调整 Shuffle 配置:可以增加 Shuffle 的副本数,减少 Shuffle 文件的丢失风险。

```properties

spark.shuffle.replication=3

spark.shuffle.blockBuffer=64k

```

重新运行任务:如果是偶发的 Shuffle 文件丢失,可以尝试重新运行任务。

相关问答 FAQs

Q1: 如何查看 Spark 任务的日志?

A1: Spark 任务的日志通常可以在 Spark Web UI 中找到,默认情况下,Web UI 会显示在集群的主节点上,端口号为 4040,你也可以通过以下方式查看日志:

1、访问 Spark Web UI:http://<drivernode>:4040

2、查看日志文件:Spark 任务的日志文件通常会存储在<SPARK_HOME>/logs 目录下,可以根据具体任务找到相应的日志文件。

Q2: Spark 任务执行时间过长怎么办?

A2: Spark 任务执行时间过长,可以从以下几个方面进行优化:

1、增加资源:增加集群的资源,包括节点数量、CPU、内存等。

2、优化代码:检查并优化 Spark 代码,避免不必要的转换和行动操作,合理设置缓存。

3、调整配置:调整 Spark 的配置参数,如spark.default.parallelism、spark.sql.shuffle.partitions 等,以提高并行度和性能。

4、监控和调优:使用 Spark Web UI 和监控工具对任务进行监控和调优,找出瓶颈并进行优化。