在使用CDH(Cloudera Distribution for Hadoop)环境中的Spark Shell时,用户可能会遇到各种报错问题,这些问题可能涉及环境配置、权限设置、依赖库缺失等多个方面,下面将详细分析这些错误及其解决方法,并提供相关FAQs以供参考。

错误类型及解决方法

1. YARN内存不足导致的Spark启动失败

错误信息:

- java.lang.IllegalArgumentException: Required executor memory (1024+384 MB) is above the max threshold (1024 MB) of this cluster! Please check the values of 'yarn.scheduler.maximumallocationmb' and/or 'yarn.nodemanager.resource.memorymb'.

原因分析:

这个错误通常是由于YARN集群的配置中,分配给单个执行器的内存不足,无法满足Spark任务的需求。

解决方法:

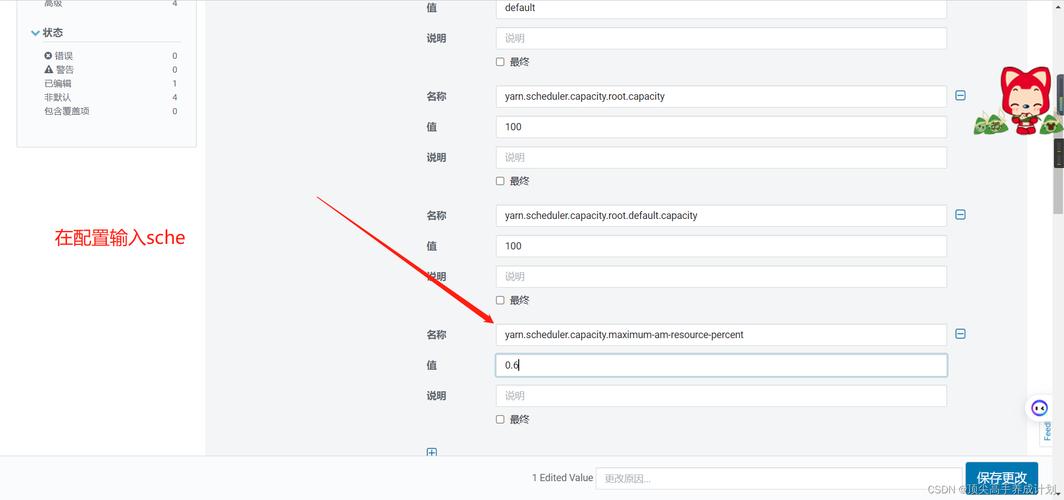

1、登录Cloudera Manager:找到YARN服务(MR2 Included)。

2、修改配置:

在导航栏中找到“配置”选项。

搜索并修改yarn.scheduler.maximumallocationmb和yarn.nodemanager.resource.memorymb参数,将其值设置为2GB或更高。

3、保存更改:点击“保存更改”,并重启YARN服务使设置生效。

4、重新运行命令:返回到Spark节点的命令行,重新执行sparkshell命令。

2. 用户权限问题导致的HDFS访问失败

错误信息:

- org.apache.hadoop.security.AccessControlException: Permission denied: user=root, access=WRITE, inode="/user":hdfs:supergroup:drwxrxrx

原因分析:

此错误是由于当前用户(通常是root)没有足够的权限访问HDFS上的特定目录。

解决方法:

1、切换用户:使用具有适当权限的用户(如hdfs用户)来启动Spark Shell。

- sudo u hdfs sparkshell

2、配置环境变量:确保HADOOP_CONF_DIR和YARN_CONF_DIR环境变量已正确设置。

- export HADOOP_CONF_DIR=/path/to/hadoop/etc/hadoop

- export YARN_CONF_DIR=/path/to/hadoop/etc/hadoop

3、检查HDFS权限:确保目标目录对当前用户可写。

- hadoop fs chmod R 775 /user

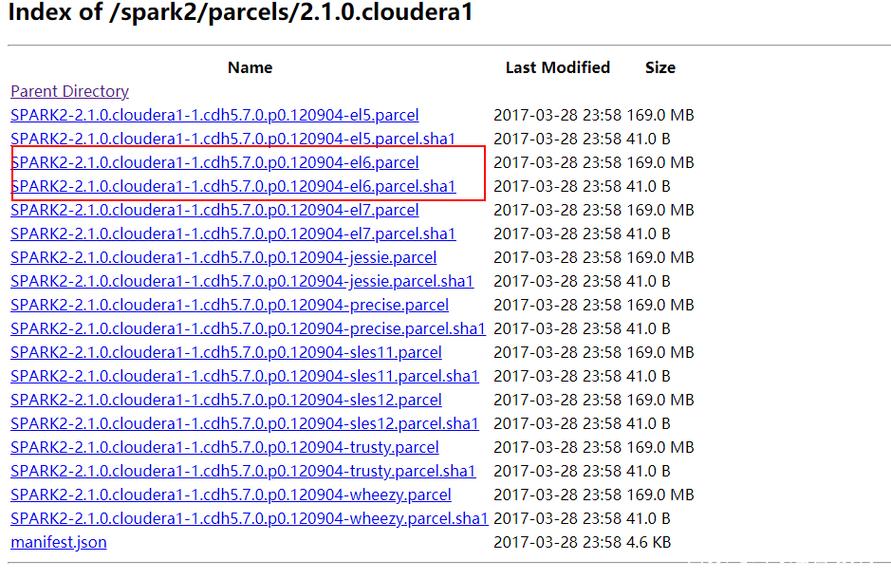

3. 缺少依赖库导致的ExecutorLauncher找不到

错误信息:

- Error: Could not find or load main class org.apache.spark.deploy.yarn.ExecutorLauncher

原因分析:

这个问题通常是由于Spark所需的依赖库没有正确上传到HDFS或本地文件系统中。

解决方法:

1、上传Jar包:将Spark的Jar包上传到HDFS。

- hdfs dfs put $SPARK_HOME/jars/* /spark/jars/

2、配置参数:在sparkdefaults.conf文件中添加以下配置,指定Jar包的位置。

- spark.yarn.jars hdfs://localhost:9000/spark/jars/*.jar

3、重启服务:重启Spark服务以应用新的配置。

- startall.sh

4. 环境变量未正确设置导致的启动失败

错误信息:

- When running with master 'yarn' either HADOOP_CONF_DIR or YARN_CONF_DIR must be set in th environmwnt

原因分析:

这是由于环境变量HADOOP_CONF_DIR或YARN_CONF_DIR未正确设置,导致Spark无法找到Hadoop和YARN的配置文件。

解决方法:

1、设置环境变量:在~/.bashrc或~/.profile文件中添加以下内容。

- export HADOOP_CONF_DIR=/path/to/hadoop/etc/hadoop

- export YARN_CONF_DIR=/path/to/hadoop/etc/hadoop

2、刷新环境变量:执行以下命令以应用更改。

- source ~/.bashrc

3、验证配置:重新启动Spark Shell并验证配置是否正确。

- sparkshell master yarn

相关FAQs

Q1:如何解决Spark Shell启动时提示“YARN内存不足”的错误?

A1:可以通过增加YARN配置中的yarn.scheduler.maximumallocationmb和yarn.nodemanager.resource.memorymb参数的值来解决,具体步骤如下:

1、登录Cloudera Manager,找到YARN服务。

2、在配置页面中搜索并修改上述参数,将其值设置为2GB或更高。

3、保存更改并重启YARN服务。

4、重新运行sparkshell命令。

Q2:如何解决Spark Shell启动时提示“用户权限不足”的错误?

A2:可以通过以下步骤解决:

1、使用具有适当权限的用户(如hdfs用户)来启动Spark Shell。

- sudo u hdfs sparkshell

2、确保HADOOP_CONF_DIR和YARN_CONF_DIR环境变量已正确设置。

- export HADOOP_CONF_DIR=/path/to/hadoop/etc/hadoop

- export YARN_CONF_DIR=/path/to/hadoop/etc/hadoop

3、检查HDFS权限,确保目标目录对当前用户可写。

- hadoop fs chmod R 775 /user

通过以上分析和解答,用户可以更好地理解和解决在使用CDH环境中的Spark Shell时遇到的常见报错问题,如果仍然遇到其他问题,建议查阅官方文档或寻求社区支持。