在CentOS系统上安装Hadoop需要经过多个步骤,包括环境准备、安装依赖软件、下载并配置Hadoop、以及启动和测试Hadoop,下面将详细介绍这些步骤:

一、环境准备

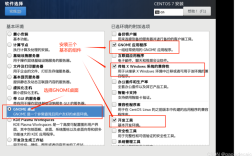

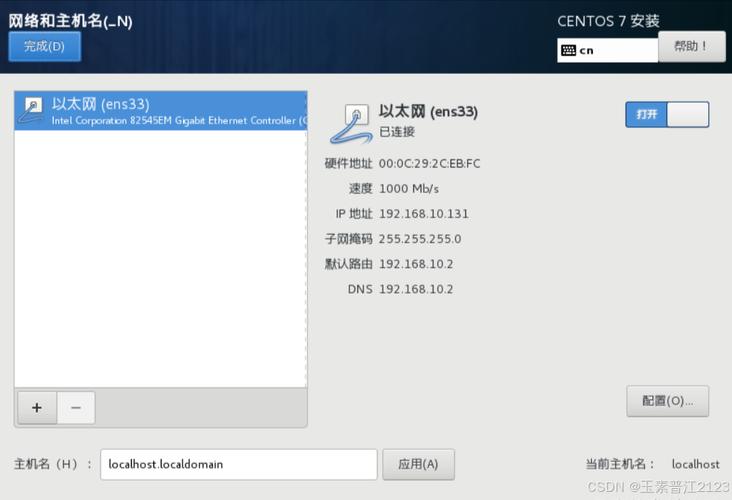

1、操作系统:CentOS 7或更高版本。

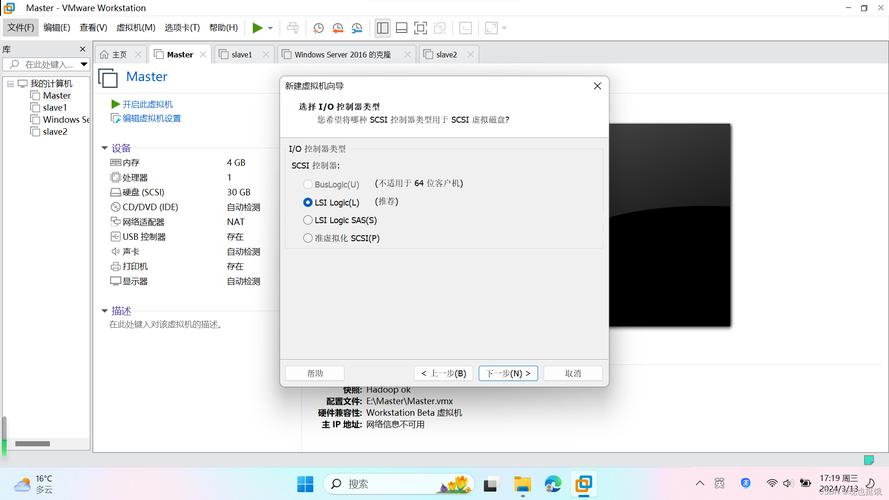

2、硬件要求:至少4GB的RAM(建议8GB以上),足够的磁盘空间用于存储数据和日志文件。

3、网络配置:确保网络连接正常,以便下载必要的软件包和文档。

二、安装依赖软件

1、SSH:Hadoop集群中的节点之间需要通过SSH进行通信,如果CentOS系统中未预装SSH,可以使用以下命令安装:

- sudo yum install opensshserver y

启动并设置SSH服务开机自启:

- sudo systemctl start sshd

- sudo systemctl enable sshd

2、Java:Hadoop运行需要Java环境,安装OpenJDK 1.8:

- sudo yum install java1.8.0openjdkdevel y

验证Java安装:

- java version

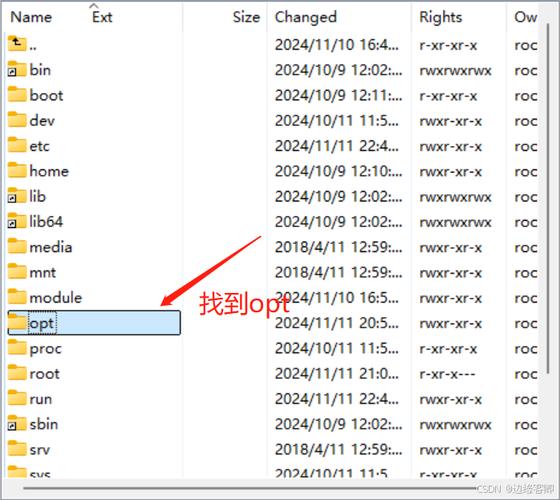

三、下载并解压Hadoop

从apache Hadoop官网或镜像站点下载Hadoop二进制包,下载Hadoop 3.3.4:

- wget https://mirrors.cnnic.cn/apache/hadoop/common/hadoop3.3.4/hadoop3.3.4.tar.gz

- tar xzvf hadoop3.3.4.tar.gz

- sudo mv hadoop3.3.4 /usr/local/hadoop

四、配置Hadoop环境变量

编辑~/.bashrc文件,添加以下内容:

- Hadoop environment variables

- export HADOOP_HOME=/usr/local/hadoop

- export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

使修改生效:

- source ~/.bashrc

五、配置Hadoop核心文件

Hadoop的核心配置文件位于$HADOOP_HOME/etc/hadoop/目录下,主要需要配置以下几个文件:

1、coresite.xml:配置HDFS的基本属性。

- <configuration>

- <property>

- <name>fs.defaultFS</name>

- <value>hdfs://localhost:9000</value>

- </property>

- </configuration>

2、hdfssite.xml:配置NameNode和DataNode的属性。

- <configuration>

- <property>

- <name>dfs.replication</name>

- <value>1</value>

- </property>

- </configuration>

3、mapredsite.xml:配置MapReduce的相关属性(可选,根据需求配置)。

- <configuration>

- <property>

- <name>mapreduce.framework.name</name>

- <value>yarn</value>

- </property>

- </configuration>

4、yarnsite.xml:配置YARN的相关属性(可选,根据需求配置)。

- <configuration>

- <property>

- <name>yarn.nodemanager.auxservices</name>

- <value>mapreduce_shuffle</value>

- </property>

- </configuration>

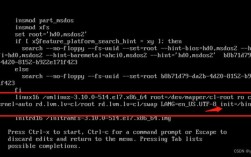

六、格式化HDFS并启动Hadoop

1、格式化HDFS:在首次启动Hadoop之前,需要格式化NameNode。

- hdfs namenode format

2、启动Hadoop:使用以下命令启动HDFS和YARN。

- startdfs.sh

- startyarn.sh

3、验证Hadoop是否成功启动:通过访问Hadoop Web界面或使用命令行工具检查进程状态。

- jps

你应该能看到NameNode、DataNode、ResourceManager和NodeManager等进程。

七、测试Hadoop安装

1、创建HDFS目录:在HDFS上创建一个测试目录。

- hdfs dfs mkdir /user

- hdfs dfs mkdir /user/hadoop

2、上传文件到HDFS:将本地文件上传到HDFS。

- hdfs dfs put /path/to/local/file.txt /user/hadoop/

3、列出HDFS中的文件:查看HDFS中的文件列表。

- hdfs dfs ls /user/hadoop/

八、常见问题及解决方法

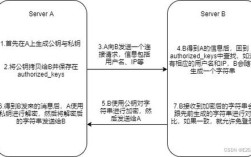

1、SSH免密登录问题:确保所有节点之间的SSH免密登录配置正确,否则Hadoop集群可能无法正常通信。

2、Java环境问题:确保Java安装正确且环境变量配置无误。

3、防火墙问题:关闭防火墙或配置防火墙允许Hadoop相关端口的通信。

4、权限问题:确保Hadoop安装目录及其子目录的权限正确,避免出现权限不足的错误。

通过以上步骤,你应该能够在CentOS系统上成功安装并配置Hadoop,如果在安装过程中遇到任何问题,可以参考Hadoop官方文档或相关社区论坛寻求帮助。