在社交媒体平台中,内容审核机制始终是用户关注的重点,当发现内容被平台屏蔽时,部分用户会产生困惑甚至质疑,本文将从平台规则、用户权益和内容生态三个角度,探讨如何理性看待此类现象。

平台规则的底层逻辑

任何社交平台的内容管理均基于国家法律法规及社区公约,以《网络安全法》《互联网信息服务管理办法》为框架,涉及虚假宣传、侵权行为或敏感话题的内容必然受到限制,2023年公布的《小红书社区规范(第七版)》明确标注了11类禁止传播的信息类型,包括但不限于医疗健康伪科学、未经验证的理财建议等,用户可通过客户端内“设置-帮助与客服-社区公约”查看完整条款。

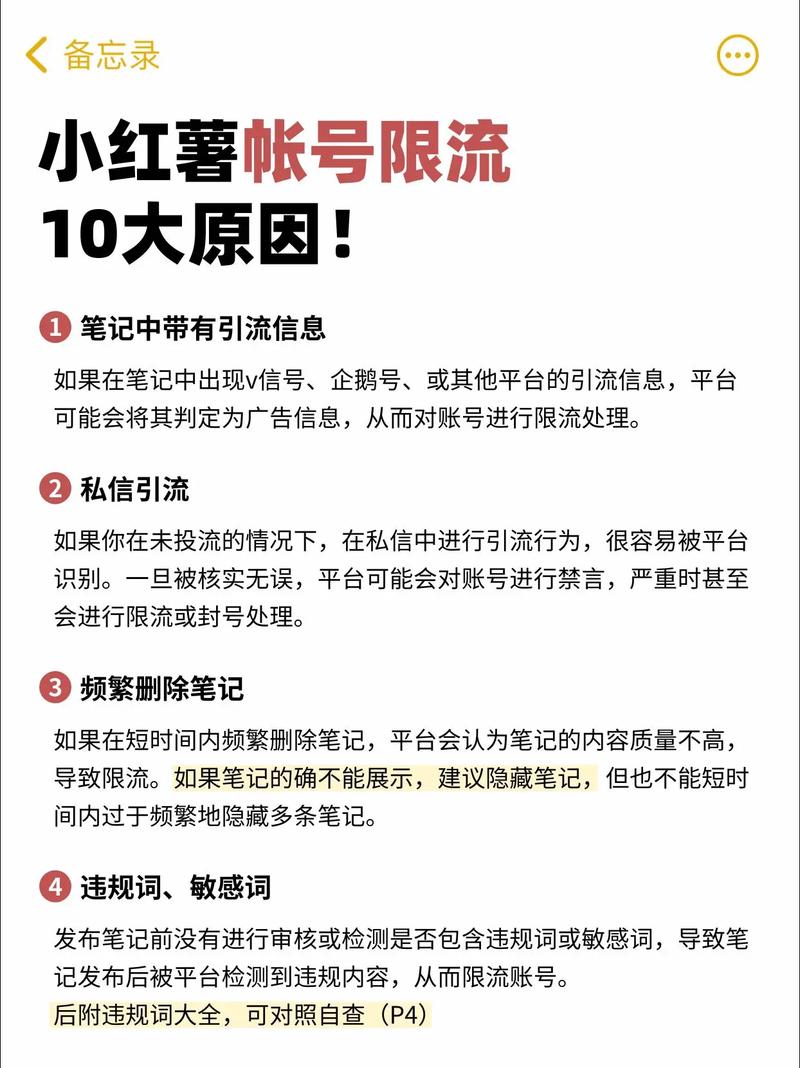

内容屏蔽的常见场景

1、触发关键词机制:系统通过AI模型实时扫描文本,例如涉及金融投资的“稳赚”“高回报”等词汇可能触发预警;

2、用户集体举报:当某条内容在24小时内被超过20人举报,将自动进入人工复核流程;

3、版权争议内容:搬运影视剧片段、未授权使用商业图片等行为,可能遭遇版权方直接投诉下架。

用户可采取的应对措施

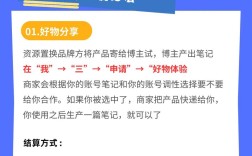

- 在创作页面使用“预审功能”,上传内容前点击右上角“…”选择“内容预检”,系统将在30秒内反馈违规风险点;

- 建立原创素材库,特别是美妆、教育领域的图文内容,建议保留创作过程的时间戳截图作为凭证;

- 对处理结果存疑时,通过“创作者服务中心-申诉通道”提交材料,官方承诺48小时内给予书面答复。

内容生态的平衡法则

平台需要兼顾用户体验与法律合规,数据显示,2023年第二季度小红书人工审核团队处理了超过4200万条举报信息,其中67%的屏蔽内容涉及虚假营销,这侧面印证了严格审核对维护社区质量的必要性,对于创作者而言,理解规则本质是提升内容存活率的关键——将营销意图转化为价值输出,用专业资质背书替代夸张话术,往往能获得更稳定的流量。

当创作自由遇见公共责任,选择权永远在优质内容的生产者手中,建立可持续的内容生态,既需要平台方透明化操作流程,更依赖创作者对专业精神的坚守。