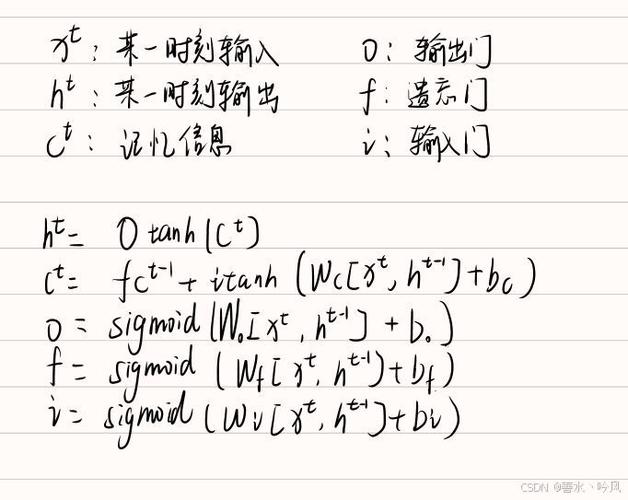

LSTM(长短期记忆网络)是一种常用于处理序列数据的深度学习模型,广泛应用于自然语言处理、时间序列预测等领域,在实际应用中,LSTM网络可能会遇到各种报错问题,以下将详细探讨LSTM报错的常见原因及解决方法:

一、LSTM报错的常见原因及解决方法

1、函数命名冲突

原因:定义LSTM网络的函数名与现有函数或模块名冲突。

解决方法:确保自定义函数的名称不与已有的函数或模块名称重复,可以将函数名从LSTM改为self_lstm或其他不冲突的名称。

2、参数格式错误

原因:LSTM层的参数格式不正确或不完整。

解决方法:检查并确保LSTM层的参数格式正确,在Keras中,LSTM层的参数应包括input_dim、output_dim和return_sequences等。

3、输入数据形状不匹配

原因:输入数据的形状不符合LSTM层的期望。

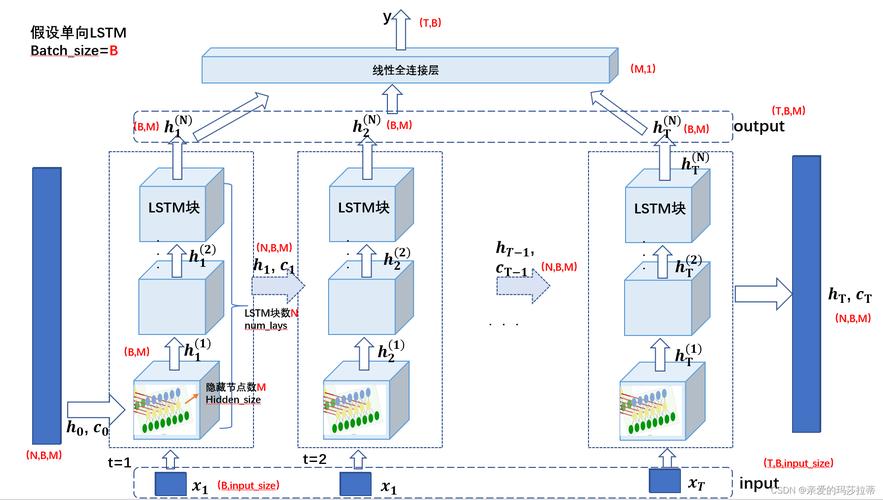

解决方法:确保输入数据的形状为(batch_size, timesteps, input_dim),如果输入数据形状不正确,可以通过reshape或调整数据来匹配。

4、隐藏状态初始化问题

原因:在使用PyTorch训练LSTM时,隐藏状态未正确初始化或在每个batch中未重置。

解决方法:在每个batch的开始处初始化隐藏状态,可以在模型的forward方法中使用self.hidden = self.init_hidden()来重置隐藏状态。

5、静态与动态形状推断问题

原因:TensorFlow中的静态形状和动态形状推断不一致。

解决方法:确保张量的形状在静态和动态形状推断中一致,可以使用get_shape().as_list()来检查张量的静态形状。

6、版本兼容性问题

原因:使用的LSTM实现或相关库版本不兼容。

解决方法:确保使用兼容的版本,某些版本的TensorFlow可能不支持某些操作,可以尝试升级或降级TensorFlow版本。

7、模型转换工具不支持LSTM节点

原因:在使用模型转换工具(如RKNN)时,LSTM节点不被支持。

解决方法:尝试使用其他支持LSTM节点的转换工具,如TensorRT或OpenVINO。

8、batch_size不一致

原因:训练和测试时batch_size不一致。

解决方法:确保训练和测试时使用相同的batch_size,如果必须使用不同的batch_size,可以通过复制权重来创建新模型。

二、LSTM报错的FAQs

问题1:在使用Keras定义LSTM网络时,为什么总是报参数有错误?

答:在使用Keras定义LSTM网络时,如果总是报参数有错误,可能是由于以下几个原因:函数命名冲突、参数格式错误、输入数据形状不匹配,解决方法包括确保函数名称不冲突、检查并修正参数格式、确保输入数据形状为(batch_size, timesteps, input_dim)。

问题2:在使用PyTorch训练LSTM时,为什么在loss.backward()上报错?

答:在使用PyTorch训练LSTM时,如果在loss.backward()上报错,通常是由于隐藏状态未正确初始化或在每个batch中未重置,解决方法是在每个batch的开始处初始化隐藏状态,例如在模型的forward方法中使用self.hidden = self.init_hidden()来重置隐藏状态。

LSTM报错的原因多种多样,但大多数问题都可以通过仔细检查代码、参数和数据来解决,通过以上分析和建议,希望能帮助开发者更好地理解和解决LSTM报错问题。