在Spark启动过程中,可能会遇到各种报错情况,这些错误可能由多种原因引起,包括环境配置问题、依赖库缺失、网络连接问题等,为了帮助您更好地理解和解决这些问题,我们将从以下几个方面进行详细探讨:

常见Spark启动报错类型及解决方案

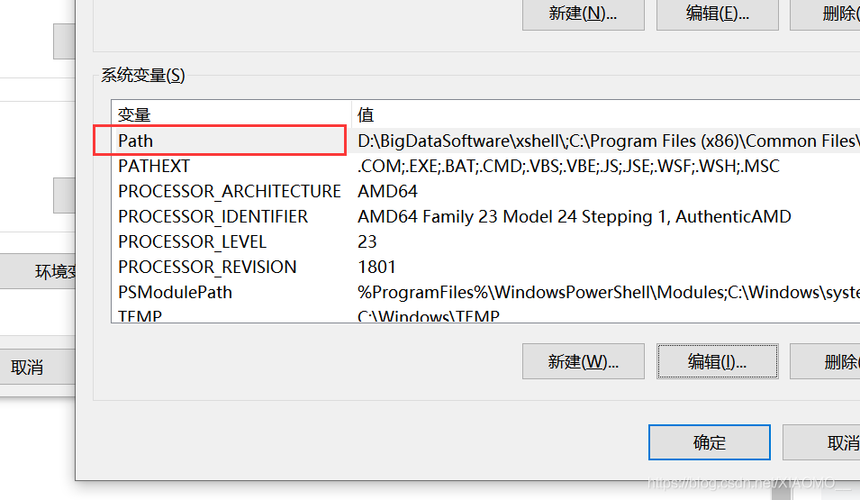

1. 环境配置问题

错误现象:java.lang.IllegalArgumentException: Java gateway process exited before sending the driver program

解决方案:

检查Java版本:确保安装了正确版本的Java(通常为JDK 8)。

设置环境变量:确保JAVA_HOME和SPARK_HOME环境变量设置正确。

配置文件:检查sparkenv.sh和sparkdefaults.conf中的配置是否正确。

| 环境变量 | 描述 | 示例值 |

| JAVA_HOME | Java安装路径 | /usr/lib/jvm/java8openjdkamd64 |

| SPARK_HOME | Spark安装路径 | /usr/local/spark |

| SPARK_CONF_DIR | Spark配置文件目录 | /etc/spark/conf |

2. 依赖库缺失

错误现象:ClassNotFoundException或NoClassDefFoundError

解决方案:

添加依赖库:确保所有必要的依赖库已添加到classpath中。

检查Maven/Gradle配置:如果使用Maven或Gradle构建项目,确保pom.xml或build.gradle中包含所有需要的依赖。

更新依赖:有时依赖库版本不兼容,尝试更新到最新版本。

| 依赖管理工具 | 配置文件 | 操作建议 |

| Maven | pom.xml | 检查并添加缺失的依赖项 |

| Gradle | build.gradle | 添加缺失的依赖项并同步项目 |

3. 网络连接问题

错误现象:Connection refused或TimeoutException

解决方案:

检查网络配置:确保集群中的所有节点之间的网络连接正常。

防火墙设置:检查防火墙设置,确保没有阻止Spark所需的端口。

主机名解析:确保所有节点的主机名能够正确解析,可以通过修改/etc/hosts文件来实现。

| 网络问题 | 检查项 | 操作建议 |

| 连接超时 | 网络延迟、带宽 | 优化网络设置,增加带宽 |

| 连接被拒绝 | 防火墙、端口 | 开放所需端口,检查防火墙规则 |

| 主机名解析失败 | /etc/hosts文件 | 更新/etc/hosts文件,确保主机名正确解析 |

排查步骤与调试技巧

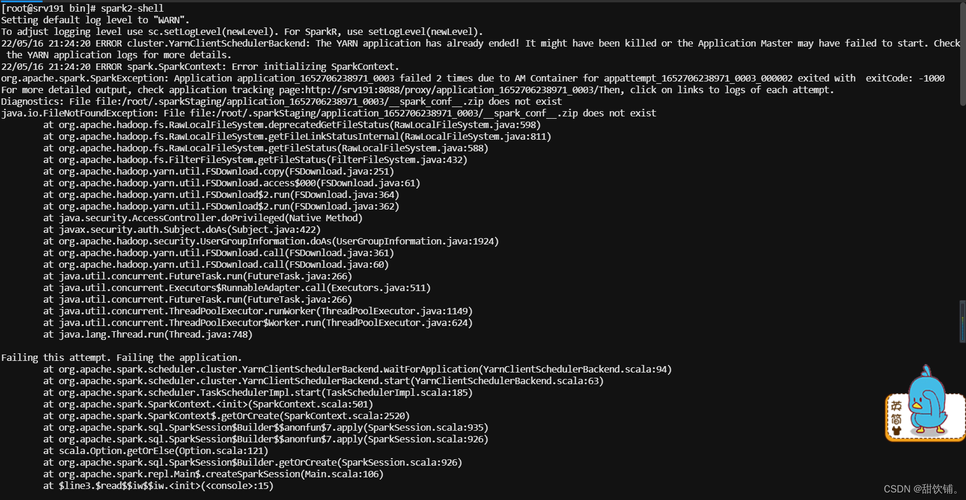

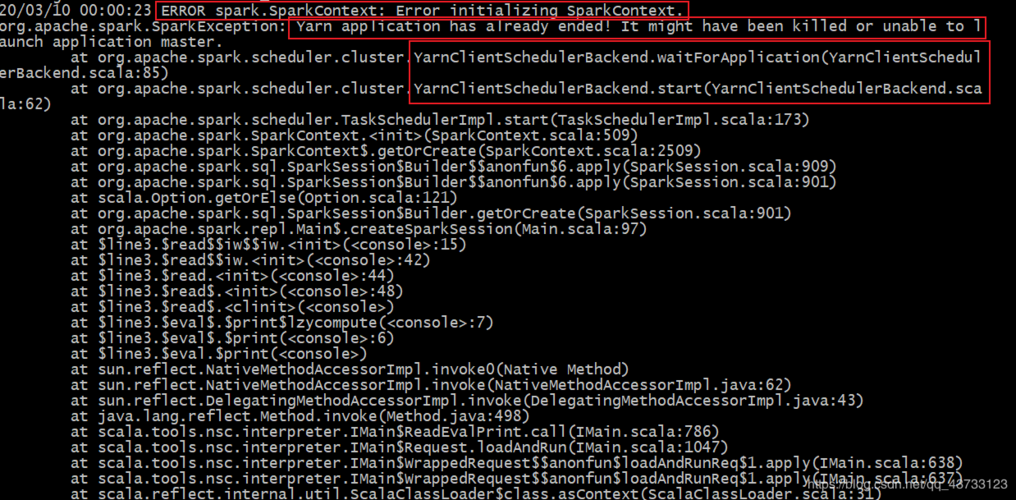

1. 日志分析

Spark提供了详细的日志信息,可以帮助定位问题,常见的日志文件包括:

stderr和stdout:查看标准输出和标准错误流中的信息。

sparkrootorg.apache.spark.deploy.master.Master:Master节点的日志。

sparkrootorg.apache.spark.deploy.worker.Worker:Worker节点的日志。

通过分析这些日志,可以获取更多关于错误的详细信息。

2. 逐步排查

采用逐步排查的方法,可以有效地缩小问题范围:

最小化配置:使用最简单的配置启动Spark,排除复杂配置带来的干扰。

单节点测试:先在本地单节点模式下运行Spark,确认基本功能是否正常。

逐步添加节点:确认单节点运行正常后,逐步添加更多节点进行测试。

相关问答FAQs

Q1: Spark启动时提示“Failed to bind on port XXXX”,如何解决?

A1: 这个错误通常是由于端口被占用引起的,解决方法如下:

检查端口占用:使用命令netstat tuln | grep XXXX检查端口是否被其他进程占用,如果是,可以选择停止该进程或者更改Spark的默认端口。

修改配置文件:编辑sparkdefaults.conf,将spark.driver.port和spark.fileserver.port设置为未被占用的端口。

Q2: Spark提交作业时出现“Executor lost”错误,如何排查?

A2: “Executor lost”错误可能由多种原因引起,以下是一些常见的排查方法:

资源不足:检查集群的资源使用情况,确保有足够的内存和CPU供Spark使用,可以通过增加executor的内存分配或增加节点来解决。

JVM崩溃:检查Executor的日志,查看是否有JVM崩溃的详细信息,如果有,可以尝试调整JVM参数,如增加堆内存大小。

网络问题:确保集群中的网络连接稳定,没有丢包或高延迟的现象,可以通过ping命令或其他网络诊断工具进行检查。