CentOS 6.5环境下Hadoop的部署与实践

在大数据技术快速发展的今天,Hadoop作为分布式计算的基石,依然是企业处理海量数据的核心工具之一,尽管CentOS 6.5已不再是主流操作系统,但其稳定性与兼容性仍被部分用户认可,本文将详细探讨如何在CentOS 6.5环境下搭建Hadoop集群,并分享实际应用中的注意事项,帮助用户高效完成部署。

**一、环境准备与基础配置

1、系统要求与依赖安装

CentOS 6.5默认内核版本为2.6.32,需确保系统更新至最新补丁,Hadoop依赖Java环境,推荐安装OpenJDK 1.7或Oracle JDK 1.8,并通过以下命令验证安装:

java -version

若需手动配置环境变量,可编辑/etc/profile文件,添加:

export JAVA_HOME=/usr/lib/jvm/java-1.7.0-openjdk export PATH=$PATH:$JAVA_HOME/bin

2、节点规划与网络设置

Hadoop集群通常包含NameNode(主节点)与多个DataNode(从节点),需确保所有节点间SSH免密登录,并通过/etc/hosts文件配置主机名解析:

192.168.1.100 master-node 192.168.1.101 slave-node1 192.168.1.102 slave-node2

二、Hadoop安装与核心参数调优

1、Hadoop版本选择与解压

CentOS 6.5对Hadoop 2.x版本兼容性较好,建议使用Hadoop 2.7.7,下载后解压至/opt目录:

tar -zxvf hadoop-2.7.7.tar.gz -C /opt/

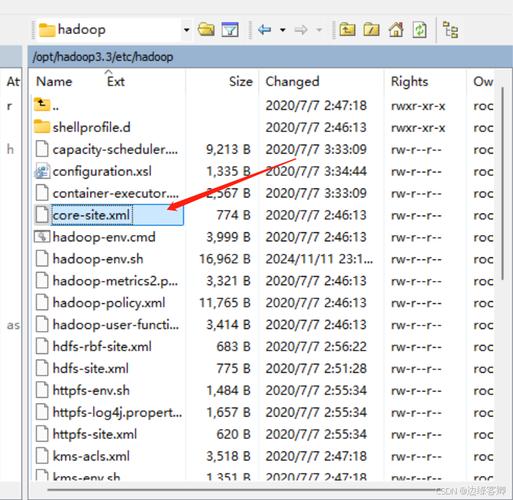

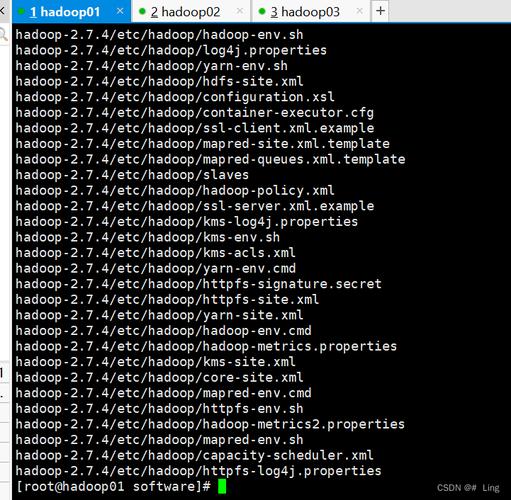

2、配置文件详解

Hadoop核心配置文件包括core-site.xml、hdfs-site.xml、mapred-site.xml及yarn-site.xml,以下为关键参数示例:

core-site.xml:定义文件系统入口与临时目录

<property>

<name>fs.defaultFS</name>

<value>hdfs://master-node:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/tmp</value>

</property>hdfs-site.xml:配置副本数量与数据块大小

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.blocksize</name>

<value>128m</value>

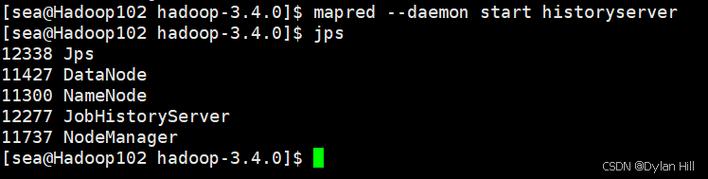

</property>3、启动集群与验证

格式化HDFS并启动服务:

hdfs namenode -format start-dfs.sh start-yarn.sh

通过jps命令检查进程状态,访问http://master-node:50070确认Web UI正常。

**三、常见问题与性能优化建议

1、兼容性问题处理

CentOS 6.5默认GLIBC版本较低,若运行Hadoop时出现libc.so.6报错,需升级至GLIBC 2.12以上,或改用预编译兼容版本。

2、内存与磁盘优化

JVM参数调整:在hadoop-env.sh中增加HADOOP_HEAPSIZE限制内存使用。

数据目录分离:将HDFS数据存储挂载至独立磁盘,避免系统盘IO瓶颈。

3、安全性增强

启用Kerberos认证可提升集群安全性,但需同步配置core-site.xml中的hadoop.security.authentication参数。

**四、应用场景与局限性分析

CentOS 6.5与Hadoop 2.x的组合适合中小规模数据处理场景,例如日志分析、离线计算等,但在实际使用中需注意:

内核限制:CentOS 6.5默认不支持CGroup资源隔离,可能影响YARN任务调度效率。

社区支持弱化:Hadoop 2.x已逐步被3.x取代,新功能与安全补丁支持有限。

对于长期运行的业务,建议升级至CentOS 7或更高版本,并迁移至Hadoop 3.x,以获取更好的资源管理能力与容器化支持。

观点

CentOS 6.5作为经典系统,其稳定性值得肯定,但技术演进不可忽视,Hadoop部署需权衡环境适配性与未来扩展性,合理规划技术栈生命周期,才能在大数据领域持续释放价值。