XGBoost报错详解及解决方案

背景介绍

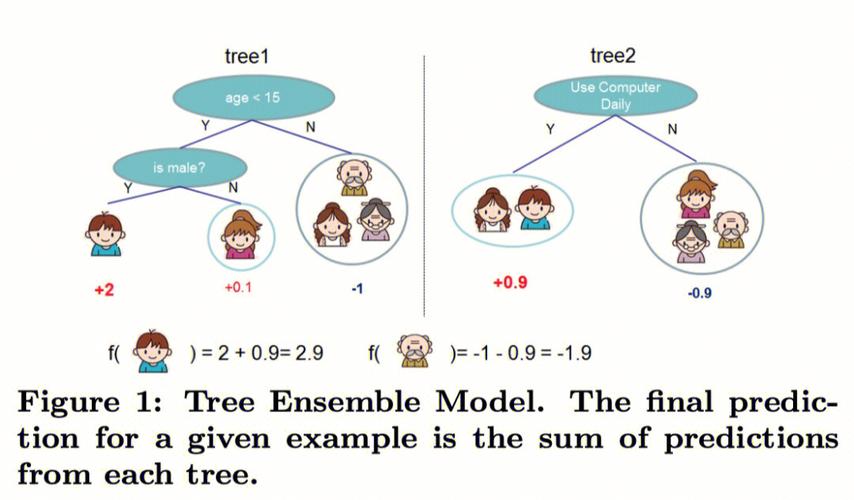

XGBoost(eXtreme Gradient Boosting)是一种高效、灵活且强大的机器学习算法,尤其在处理分类和回归问题时表现出色,在使用XGBoost进行模型训练时,可能会遇到各种错误和问题,本文将详细探讨XGBoost报错的常见原因及其解决方案,并结合具体案例进行分析。

一、常见报错及解决方法

1. DMatrix或Booster对象未初始化

报错信息:

- raise XGBoostError(_LIB.XGBGetLastError()) xgboost.core.DMatrix/Booster has not been initialized

原因分析:

在使用XGBoost库时,需要先创建一个DMatrix对象来存储训练数据,然后再创建一个Booster对象来进行训练,如果忘记初始化这些对象,就会导致该错误的发生。

解决方法:

确保在创建DMatrix对象时正确调用xgboost.DMatrix函数。

确保在创建Booster对象后,通过train方法对其进行初始化。

检查随机种子设置是否正确,避免因随机种子不一致导致初始化失败。

2. 标签值不在预期范围内

报错信息:

- SoftmaxMultiClassObj: label must be in [0, num_class)

原因分析:

在使用多分类任务时,标签值必须在[0, num_class)范围内,如果标签值超出了这个范围,就会引发错误。

解决方法:

确保标签值从0开始,最大值为类别总数减一,对于6个类别的分类问题,标签值应为0到5。

如果标签值是从1开始的,可以通过简单的数据处理将其转换为从0开始。

3. 缺少必要的库文件

报错信息:

- XGBoostError: XGBoost Library (libxgboost.dylib) could not be loaded.

原因分析:

这是由于XGBoost库文件未能正确加载导致的。

解决方法:

在终端中删除现有的XGBoost安装:conda remove xgboost

然后重新安装XGBoost:conda install pyxgboost

检查安装是否成功:import xgboost

4. 模块未找到或命名冲突

报错信息:

- ModuleNotFoundError: No module named 'xgboost' or cannot import name 'XGBClassifier' from 'xgboost'

原因分析:

这可能是由于环境配置问题或命名冲突导致的。

解决方法:

确保在正确的环境中安装了XGBoost,并且Python能够找到它。

如果存在命名冲突(例如自己创建了一个名为xgboost.py的文件),请重命名该文件以避免与库文件冲突。

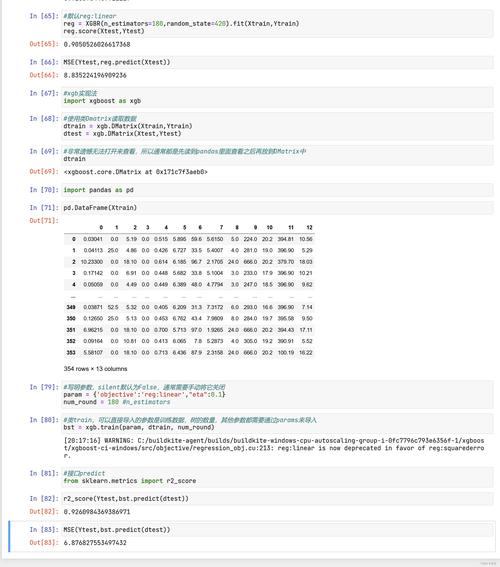

二、案例分析

以一个具体的案例来说明如何解决XGBoost报错问题,假设我们有一个多标签分类预测任务,使用的是XGBoost算法。

步骤1:导入必要的库

- import time

- from sklearn.datasets import load_iris

- import xgboost as xgb

- from xgboost import plot_importance, plot_tree

- from sklearn.model_selection import train_test_split

- from sklearn.metrics import accuracy_score

- import matplotlib.pyplot as plt

- import matplotlib

- %matplotlib inline

步骤2:加载数据集

- 这里使用Iris数据集作为示例

- iris = load_iris()

- X, y = iris.data, iris.target

- print('X:

- ', X, '

- Y:

- ', y)

- print('X.shape:

- ', X.shape, '

- y.shape:

- ', y.shape)

步骤3:分割数据集

- X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=1234567)

步骤4:设置算法参数

- params = {

- 'booster': 'gbtree',

- 'nthread': 4,

- 'silent': 0,

- 'seed': 1000,

- 'objective': 'multi:softmax', # 多分类问题

- 'num_class': 3, # 类别总数,与multi softmax并用

- 'gamma': 0.1,

- 'max_depth': 6,

- 'lambda': 2,

- 'subsample': 0.7,

- 'colsample_bytree': 0.7,

- 'min_child_weight': 3,

- 'eta': 0.1,

- }

- plst = params.items()

- print("plst:

- ", plst)

- plst = list(params.items())

步骤5:生成数据集格式并训练模型

- dtrain = xgb.DMatrix(X_train, label=y_train)

- num_rounds = 500 # 迭代次数

- model = xgb.train(plst, dtrain, num_rounds)

在这个案例中,如果遇到了上述任何一种报错,可以根据前面提供的解决方案逐一排查和解决,特别需要注意的是,对于多分类问题,确保标签值在[0, num_class)范围内,否则会引发SoftmaxMultiClassObj: label must be in [0, num_class)的错误。

XGBoost作为一种强大的机器学习算法,在实际应用中可能会遇到各种报错和问题,通过本文的介绍,我们了解了XGBoost常见的报错类型及其解决方法,并通过一个具体的案例进行了实践,希望这些内容能够帮助读者更好地理解和应用XGBoost,提高模型训练的效率和准确性。

在未来的研究和应用中,随着技术的不断发展和优化,我们可以期待XGBoost在更多领域发挥更大的作用,也需要不断学习和掌握新的技术和方法,以应对日益复杂的数据分析和建模需求。