Hadoop 报错分析与解决方案

背景介绍

Hadoop是一个开源的分布式计算框架,广泛应用于大数据处理和存储,在使用Hadoop过程中,用户经常会遇到各种报错问题,本文将详细介绍几种常见的Hadoop报错及其解决方案,帮助用户更好地理解和解决这些问题。

常见报错及解决方案

1. java.lang.OutOfMemoryError

错误信息:java.lang.OutOfMemoryError

原因: Hadoop作业内存不足。

解决方案: 增加作业的内存限制,可以通过调整Hadoop配置文件中的mapreduce.map.memory.mb和mapreduce.reduce.memory.mb参数来增加内存限制,将内存限制设置为4GB:

- export HADOOP_HEAPSIZE=4096

2. java.io.IOException: Filesystem /user/hadoop is not operational

错误信息:java.io.IOException: Filesystem /user/hadoop is not operational

原因: Hadoop文件系统无法访问或挂载失败。

解决方案: 检查文件系统的状态,并确保所有节点都可以正常访问,可以通过运行hdfs dfs ls /命令来检查文件系统状态,如果出现问题,可能需要重新挂载文件系统或修复文件系统损坏。

3. java.lang.InterruptedException

错误信息:java.lang.InterruptedException

原因: Hadoop作业被中断。

解决方案: 检查是否有其他作业或进程与当前作业冲突,或者是否有足够的资源运行作业,可以通过调整资源分配或增加节点数来解决资源不足问题。

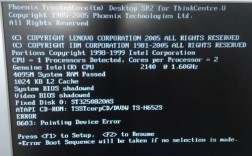

4. java.net.ConnectException: Connection refused

错误信息:java.net.ConnectException: Connection refused

原因: Hadoop节点之间的通信问题。

解决方案: 检查节点之间的网络连接是否正常,防火墙设置是否允许通信,以及是否有足够的端口可用,可以通过检查网络配置和调整防火墙规则来解决通信问题。

详细解决方案步骤

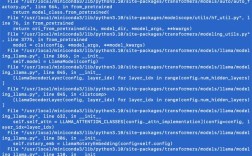

查看日志文件

Hadoop的日志文件通常包含详细的错误信息和堆栈跟踪,在Hadoop的日志目录下查找最近的日志文件,并仔细阅读其中的错误信息。

搜索解决方案

一旦了解了具体的错误信息,可以在搜索引擎中输入错误信息,尝试找到其他人遇到的相同问题和解决方案,也可以在相关的技术论坛和社区中寻求帮助,比如Stack Overflow等。

检查配置文件

确保Hadoop集群的配置文件设置正确,特别是与内存、网络和文件系统相关的配置,有时候配置文件的错误设置会导致报错。

更新和升级

如果遇到的问题与软件版本相关,尝试更新Hadoop到最新版本,或者升级到更稳定的版本,新版本可能已经修复了旧版本中的问题。

确保系统资源充足

确保集群中的所有节点都有足够的系统资源(如内存、CPU和磁盘空间)来运行Hadoop作业,资源不足可能导致作业失败或异常终止。

检查依赖关系

确保所有依赖的库和组件都已正确安装并配置在Hadoop集群中,缺失的依赖可能导致作业无法正常执行。

权限和安全设置

检查Hadoop集群中的权限设置和安全策略,确保所有用户都有适当的权限来访问和执行作业。

FAQs

Q1: 如何增加Hadoop作业的内存限制?

A1: 可以通过调整Hadoop配置文件中的mapreduce.map.memory.mb和mapreduce.reduce.memory.mb参数来增加内存限制,将内存限制设置为4GB:

- export HADOOP_HEAPSIZE=4096

Q2: Hadoop文件系统无法访问或挂载失败怎么办?

A2: 检查文件系统的状态,并确保所有节点都可以正常访问,可以通过运行hdfs dfs ls /命令来检查文件系统状态,如果出现问题,可能需要重新挂载文件系统或修复文件系统损坏。