一、配置类问题

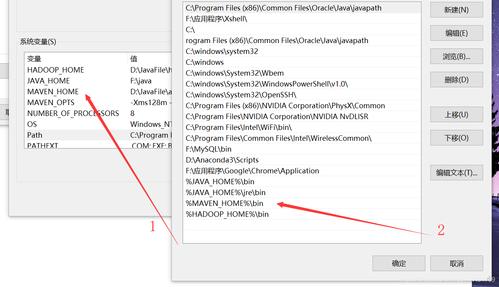

1、环境变量未正确设置

问题描述:HADOOP_HOME、HADOOP_CONF_DIR 等环境变量未正确指向 Hadoop 安装目录和配置文件目录,导致系统无法找到相关文件和依赖。

解决方法:在终端或命令行中检查并正确设置环境变量,在 Linux 系统中,可以在~/.bashrc 文件中添加如下配置:

- export HADOOP_HOME=/path/to/hadoop

- export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

- export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

然后执行source ~/.bashrc 使配置生效。

2、配置文件缺失或错误

问题描述:Hadoop 的核心配置文件如 coresite.xml、hdfssite.xml、mapredsite.xml 等缺失或配置错误,可能导致 WordCount 程序无法正确运行。

解决方法:确保 Hadoop 配置文件完整且配置正确,coresite.xml 中需要配置 HDFS 的 NameNode 地址:

- <configuration>

- <property>

- <name>fs.defaultFS</name>

- <value>hdfs://localhost:9000</value>

- </property>

- </configuration>

3、YARN 相关配置错误

问题描述:如果在 YARN 模式下运行 WordCount,可能会遇到与 ResourceManager、NodeManager 相关的配置问题,如 NodeManager 的辅助服务配置错误等。

解决方法:检查 yarnsite.xml 文件中的配置,确保 NodeManager 的辅助服务包括 mapreduce_shuffle 等必要的服务,并且配置正确。

- <configuration>

- <property>

- <name>yarn.nodemanager.auxservices</name>

- <value>mapreduce_shuffle</value>

- </property>

- <property>

- <name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name>

- <value>org.apache.hadoop.mapred.ShuffleHandler</value>

- </property>

- </configuration>

二、输入输出路径问题

1、输入路径不存在

问题描述:指定的输入路径在 HDFS 上不存在,导致 WordCount 程序无法找到输入数据。

解决方法:使用hdfs dfs ls 命令检查输入路径是否存在,如果不存在,需要先创建输入目录并将数据上传到 HDFS。

- hdfs dfs mkdir p /user/atguigu/wcinput

- hdfs dfs put /local/path/to/data /user/atguigu/wcinput

2、输出路径已存在

问题描述:指定的输出路径在 HDFS 上已经存在,可能会导致 WordCount 程序运行失败或覆盖已有结果。

解决方法:在运行 WordCount 之前,先删除已有的输出目录或指定一个新的输出路径。

- hdfs dfs rm r /user/atguigu/wcoutput

然后再运行 WordCount 程序时指定新的输出路径。

三、权限问题

1、用户对输入输出路径没有足够权限

问题描述:当前用户对指定的输入或输出路径没有足够的读、写、执行权限,导致 WordCount 程序无法正常访问这些路径。

解决方法:使用hdfs dfs chmod 命令修改输入输出路径的权限,确保当前用户有相应的权限。

- hdfs dfs chmod 755 /user/atguigu/wcinput

- hdfs dfs chmod 755 /user/atguigu/wcoutput

2、本地文件系统权限不足:在本地文件系统上,WordCount 程序需要创建临时文件或目录,但当前用户没有在这些位置创建文件的权限,也会导致失败,在某些 Linux 系统中,默认情况下用户可能无法在/tmp 目录下创建文件,此时可以尝试更改临时文件的存放位置,或者联系系统管理员获取相应权限。

四、集群相关问题

1、NameNode 或 DataNode 故障:HDFS 的 NameNode 或 DataNode 出现故障,可能会导致 WordCount 程序无法与 HDFS 正常交互,从而出现各种错误,可以通过 Hadoop 管理界面或相关监控工具检查 NameNode 和 DataNode 的状态,重启故障节点或进行故障排除。

2、网络问题:在分布式环境下,网络问题可能导致客户端与服务器之间的通信中断,影响 WordCount 程序的执行,检查网络连接是否正常,防火墙是否阻止了 Hadoop 相关的端口通信等,如果是网络问题,需要修复网络连接或调整防火墙设置。

3、资源不足:当集群资源紧张时,如内存、磁盘空间或 CPU 使用率过高,可能会导致 WordCount 作业无法获得足够的资源而失败,可以查看集群的资源使用情况,合理分配资源,必要时增加硬件资源或优化其他作业的资源占用。

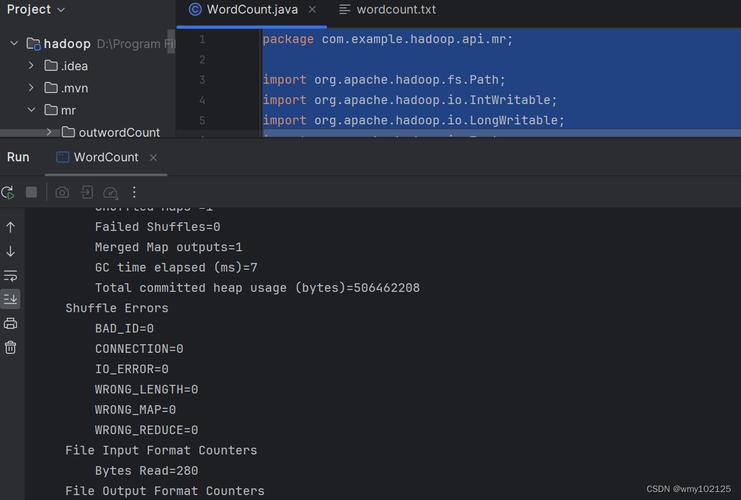

五、程序逻辑问题

1、代码编写错误:如果是自己编写的 MapReduce 程序来实现 WordCount,可能存在代码逻辑错误,如 Map 函数或 Reduce 函数实现不正确、键值对处理不当等,仔细检查代码逻辑,确保符合 MapReduce 编程模型的要求,可以通过调试代码、添加日志信息等方式来查找和解决代码中的问题。

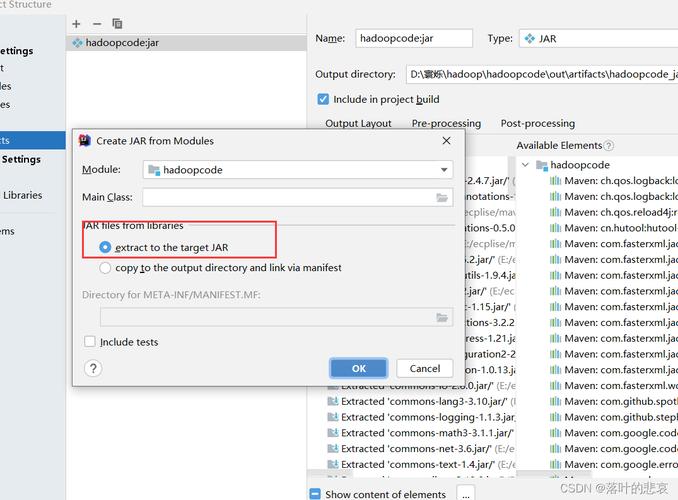

2、依赖库问题:如果程序依赖于特定的 Hadoop 版本或其他第三方库,可能会出现兼容性问题或库文件缺失的情况,确保使用正确的 Hadoop 版本,并在需要时添加相应的依赖库,对于 Java 程序,可以使用构建工具如 Maven 或 Gradle 来管理项目依赖。

六、常见问题解答(FAQs)

1、Q:为什么运行 WordCount 时报 “FileNotFoundException”?

A:通常是因为指定的输入路径不存在或拼写错误,请使用hdfs dfs ls 命令检查输入路径是否正确,并确保数据已经上传到该路径下。

2、Q:WordCount 作业长时间处于 “ACCEPTED” 状态怎么办?

A:这可能是由于集群资源紧张,作业正在等待调度,可以查看集群的资源使用情况,如有大量作业排队等待,可以考虑调整作业优先级或增加集群资源,检查作业配置是否正确,如内存分配、并行度等参数是否合理。

3、Q:运行 WordCount 时出现 “OutOfMemoryError” 是什么原因?

A:可能是为 WordCount 作业分配的内存不足,导致 JVM 内存溢出,可以尝试增加作业的内存配置,在 MapReduce 作业配置中调整mapreduce.task.io.sort.mb、mapreduce.map.memory.mb 和mapreduce.reduce.memory.mb 等参数的值,以分配更多的内存给作业,检查输入数据的大小是否合适,避免一次性处理过大的数据量。