Spark 报错是一个常见的问题,特别是在处理大数据和分布式计算时,下面将详细分析 Spark 报错的原因,并提供解决方案。

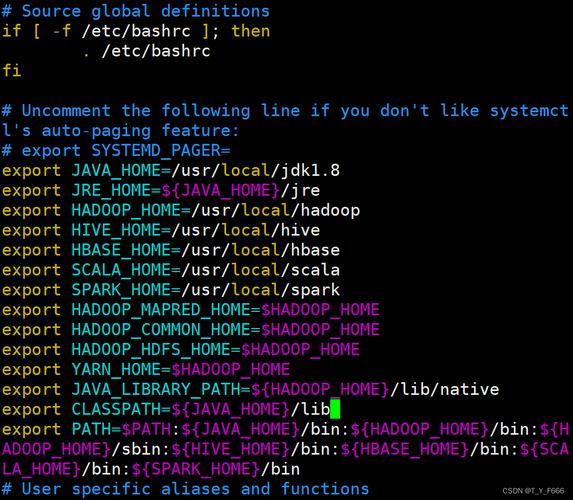

一、环境配置问题

1、Spark安装及环境变量配置:确保Spark安装正确,并且环境变量已经配置好,如果使用的是集群模式,还需要确保集群中的所有节点都已正确安装Spark,并且配置了正确的环境变量。

2、Hadoop配置:如果Spark是在Hadoop集群上运行,需要确保Hadoop的配置文件(如coresite.xml、hdfssite.xml等)已经正确配置,并且Hadoop集群已经启动。

3、Java和Scala版本:检查Java和Scala的版本是否与Spark的要求一致,如果不一致,可能会导致运行出错。

二、依赖关系问题

1、外部库支持:Spark自带样例通常需要一些外部库的支持,如果这些库没有正确安装或者版本不匹配,也可能会导致运行出错。

2、Maven或SBT工具:通过Maven或者SBT等工具进行安装或者更新所需的依赖库,对于Maven项目,可以在pom.xml文件中添加相应的依赖项,然后执行Maven的update project命令。

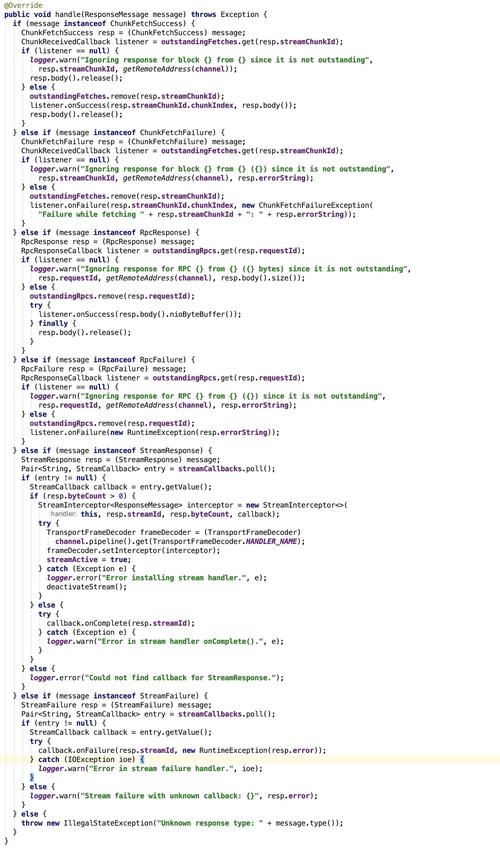

三、代码错误

1、参数设置错误:检查代码中所有的参数设置是否正确,包括输入数据的路径、输出结果的路径等。

2、逻辑错误:检查代码中的逻辑处理部分是否正确,在SparkPi样例中,需要计算每个数据点的值和计数的总和,如果逻辑处理错误,会导致结果不正确。

3、数据类型不匹配:检查代码中所有的数据类型是否匹配,在读取数据时,需要确保读取的数据类型与预期的数据类型一致。

四、其他问题

1、资源不足:确保有足够的资源(如内存、CPU)来运行Spark作业。

2、网络问题:检查是否存在网络连接问题,特别是在分布式环境中。

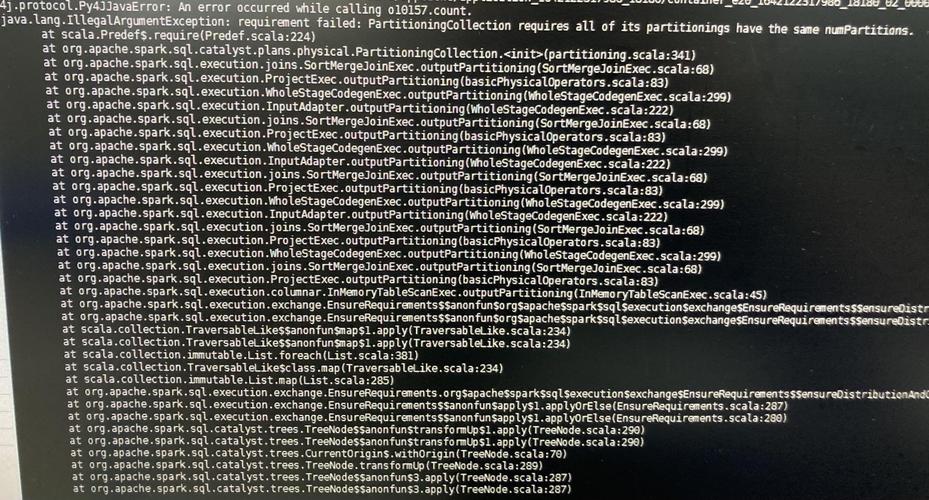

3、日志分析:利用Spark提供的日志文件和Web UI来分析错误信息和调试信息。

五、示例

以下是一个使用PySpark进行简单数据处理的例子,并展示如何处理可能出现的错误:

from pyspark.sql import SparkSession

from pyspark.sql.functions import *

创建SparkSession

spark = SparkSession.builder \

.appName("SimpleExample") \

.getOrCreate()

创建一个包含整数的DataFrame

data = [(1, "Alice"), (2, "Bob"), (3, "Cathy")]

df = spark.createDataFrame(data, ["id", "name"])

计算平均值

average_age = df.agg({"id": "avg"}).collect()[0][0]

print(f"Average age: {average_age}")

停止SparkSession

spark.stop()在这个例子中,我们创建了一个SparkSession,并使用它来创建一个包含整数的DataFrame,我们计算了id列的平均值,并打印结果,如果在运行过程中出现错误,可以通过查看日志文件来获取更多的错误信息。

六、FAQs

1、Q: Spark任务长时间不结束怎么办?

A: 可以通过Spark Web UI查看Executor页面,分析driver的thread dump,如果很多orc相关的线程,可以在Spark任务启动前设置conf spark.hadoop.hive.exec.orc.split.strategy=BI,再重新启动Spark任务。

2、Q: Spark作业出现java.lang.ClassNotFoundException怎么办?

A: 根据Class的信息找到对应的JAR包,并通过提交Spark任务时使用jars把JAR包提交上去,也可以使用spark.driver.extraclasspath和spark.executor.extraclasspath来指定额外的类路径。

解决Spark报错问题需要仔细排查环境配置、依赖关系和代码错误等方面的问题,利用Spark提供的日志文件和Web UI可以有效地帮助定位问题所在。