Hadoop CentOS 伪分布:新手小白的入门指南

在大数据的世界里,Hadoop 就像是一个超级明星,而 CentOS 则是它舒适的舞台,对于刚踏入这个领域的新手小白来说,搭建一个 Hadoop 的 CentOS 伪分布环境,就像是开启一场奇妙的冒险,你是不是也想在这个数据海洋里畅游一番呢?别着急,咱们一步步来。

一、啥是 Hadoop 和 CentOS 伪分布?

先来说说 Hadoop,它其实是一个能处理海量数据的框架,就像一个超级大仓库,能把好多好多的数据分类整理好,方便我们使用,CentOS 呢,就是一种操作系统,就像电脑的管家,让各种软件能乖乖听话运行,那什么是伪分布模式呢?这就好比你在自己的小房间里模拟一个大公司的各个部门运作,虽然只有你一个人,但每个环节都能体验到,这就是 Hadoop 的伪分布模式,自己一台电脑模拟出多节点的分布式环境,方便学习测试。

二、准备工作要做好

咱得有个得力的“助手”,也就是安装好 CentOS 系统,可以去官方网站下载 CentOS 的镜像文件,然后通过一些工具,U 盘启动盘制作工具,把镜像文件装到 U 盘里,再设置电脑从 U 盘启动,就能开始安装 CentOS 啦,安装过程中,分区、设置网络这些步骤可得走心点,就像盖房子打地基一样重要。

接着就是给 Hadoop 找个合适的“落脚地”,也就是下载安装 Hadoop,去 apache 官网下载对应版本的 Hadoop 压缩包,解压到你想放的地方,一般放在类似“/usr/local/hadoop”这样的目录就挺好。

三、配置 Hadoop,这可是个精细活

1、先得改改 Hadoop 的配置文件,找到“hadoop env.sh”这个文件,在里面设置一下 Java 的环境变量,让 Hadoop 知道 Java 在哪,不然它可就不乐意干活啦,比如说,你的 Java 安装在“/usr/lib/jvm/java 8”,那就把这个路径加进去。

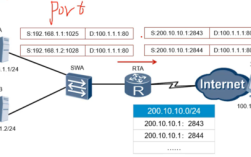

2、核心配置文件“core site.xml”也不能放过,这里面要配置 HDFS(Hadoop 分布式文件系统)的地址,把“fs.defaultFS”改成“hdfs://localhost:9000”,这就告诉 Hadoop,数据默认存到本地的 9000 端口对应的 HDFS 上。

3、还有“hdfs site.xml”,要设置一下副本系数,伪分布模式下设为 1 就行,就是数据只存一份,毕竟就你一台电脑嘛,还要配置好 NameNode 和 DataNode 的地址,都指向“localhost”。

4、“mapred site.xml”这个文件也要动一动,设置一下 MapReduce 的框架地址,改成“yarn”就行,这样能让 Hadoop 更好地分配任务处理数据。

四、启动 Hadoop,见证奇迹的时刻

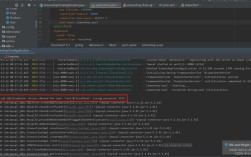

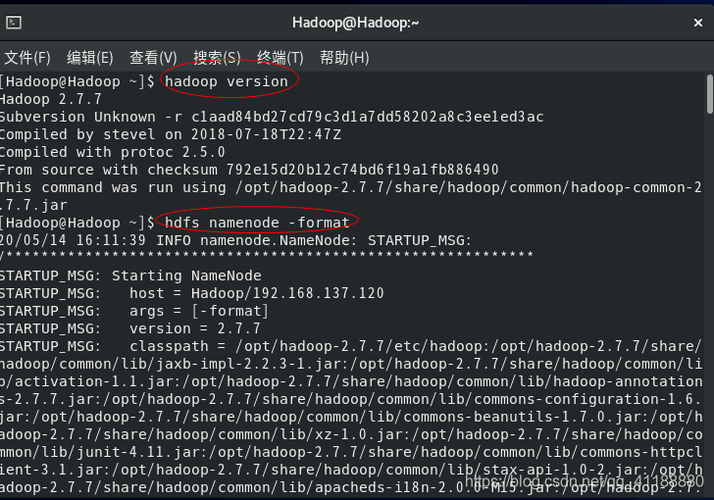

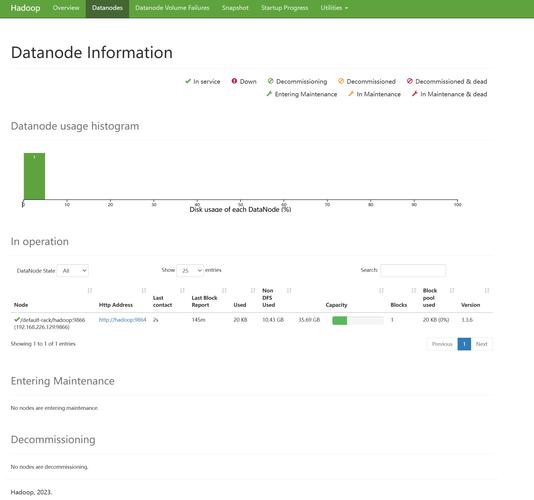

配置完,就可以启动 Hadoop 啦,进入 Hadoop 的安装目录,有个“sbin”文件夹,里面有好多脚本命令,先格式化一下 NameNode,就像给新硬盘分区一样,执行“hdfs namenode format”,然后输入“start dfs.sh”启动 HDFS,再输入“start yarn.sh”启动 YARN,看到没有,Hadoop 的各种服务就开始跑起来啦,你可以在浏览器里输入“http://localhost:50070”看看 HDFS 的状态,是不是感觉特有成就感?

五、简单验证一下,心里更踏实

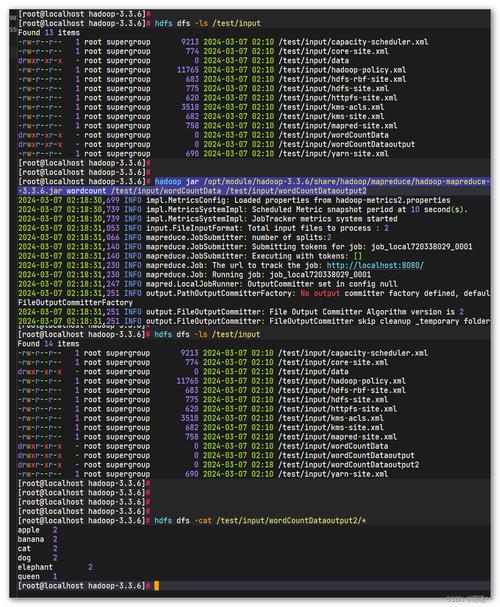

怎么验证 Hadoop 装好了呢?咱可以上传个文件试试,进入 HDFS 的命令行界面,执行“hdfs dfs mkdir /user/hadoop”创建一个目录,然后再执行“hdfs dfs put localfile.txt /user/hadoop”上传一个本地文件到 HDFS 上,最后再执行“hdfs dfs ls /user/hadoop”看看文件是不是传上去了,要是能看到文件列表里有你刚传的文件,那恭喜你,Hadoop 在 CentOS 上的伪分布环境搭建成功啦!

其实啊,搭建 Hadoop 的 CentOS 伪分布环境也没那么难,只要一步一步按照流程走,多注意细节,就像搭积木一样,肯定能搭出你想要的大数据“城堡”,在这个过程中,你可能会遇到一些小问题,别慌,上网查查资料,或者问问社区里的大神,办法总比困难多,等你玩转了 Hadoop 伪分布,再去挑战分布式集群,那又是另一番精彩的天地咯!加油,大数据的世界等你来闯荡!