HBase ImportTSV 报错排查与解决方案

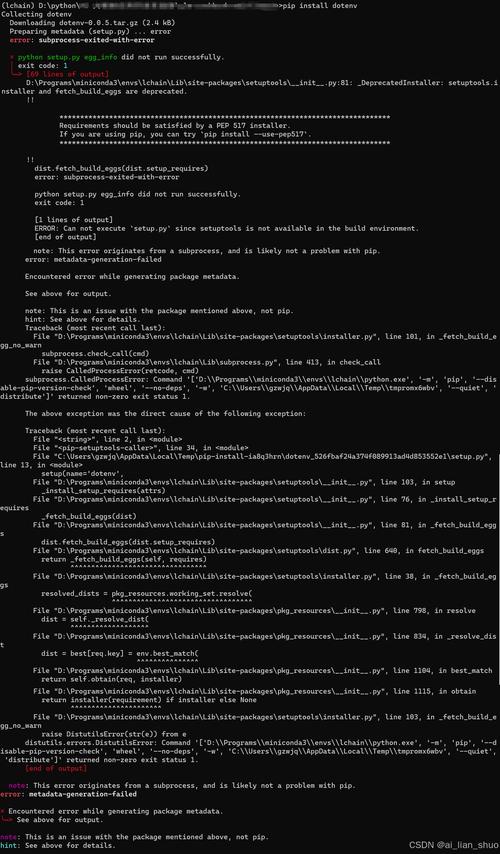

在使用HBase进行数据导入时,importtsv工具是一个常用且高效的选择,许多开发者和运维人员在操作过程中会遇到各种报错,导致数据导入失败,本文将从常见错误场景出发,结合实际案例,分析问题根源并提供解决方法,帮助用户高效完成数据迁移任务。

一、ImportTSV工具的基本原理

在深入讨论报错之前,有必要简单了解importtsv的工作原理,该工具通过MapReduce任务将TSV(Tab-Separated Values)格式的数据文件转换为HBase的HFile文件,随后通过completebulkload将HFile加载到HBase表中,这一过程依赖以下关键配置:

1、HBase表结构:必须预先创建目标表,并确保列族与数据文件中的列匹配。

2、Hadoop环境:需要正确配置Hadoop集群的路径、权限及资源分配。

3、数据格式:TSV文件的列分隔符必须为制表符(\t),且字段顺序需与表结构一致。

若任一环节配置不当,都可能引发报错。

二、常见报错场景及解决方案

1.ClassNotFoundException 或 NoClassDefFoundError

错误现象:

- java.lang.ClassNotFoundException: org.apache.hadoop.hbase.mapreduce.ImportTsv

原因分析:

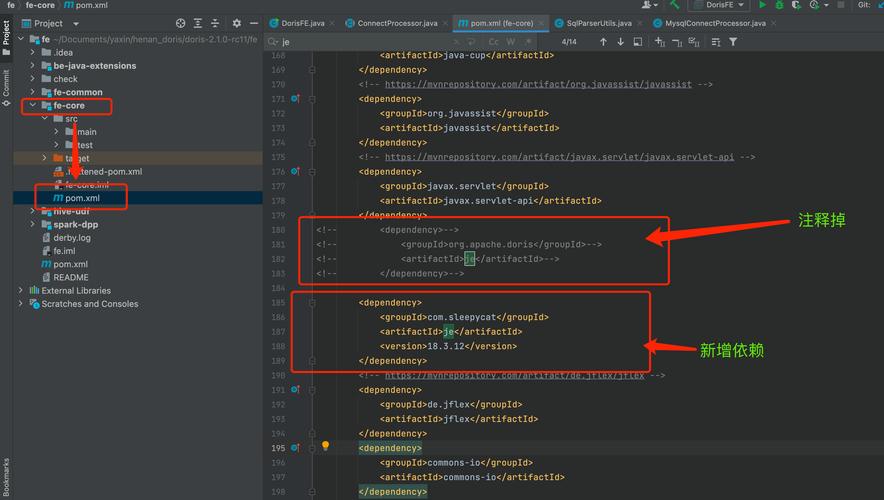

- Hadoop或HBase的依赖库未正确加载,通常发生在未将HBase的JAR包添加到Hadoop的类路径中。

- 环境变量(如HBASE_HOME)未配置,或配置后未生效。

解决方案:

- 检查环境变量:确保HBASE_HOME和HADOOP_HOME已正确设置,并添加到PATH中。

- 显式指定JAR包路径:在执行命令时通过-libjars参数加载HBase的相关JAR包。

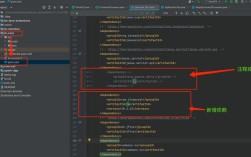

- hadoop jar $HBASE_HOME/lib/hbase-mapreduce-*.jar importtsv \

- -Dimporttsv.columns=HBASE_ROW_KEY,cf:col1,cf:col2 \

- -libjars $HBASE_HOME/lib/hbase-mapreduce-*.jar \

- table_name /input/path

2.InvalidFamilyFormatException

错误现象:

- org.apache.hadoop.hbase.InvalidFamilyFormatException: Column family name can't be empty

原因分析:

- TSV文件的列描述符(-Dimporttsv.columns)配置错误,例如列族名缺失或格式不符合family:qualifier的规范。

- 数据文件中存在空列或多余的分隔符。

解决方案:

- 检查列描述符:确保参数格式正确,

- -Dimporttsv.columns=HBASE_ROW_KEY,cf1:col1,cf2:col2

- 验证数据文件:使用awk -F '\t' '{print NF}' filename.tsv命令检查每行的字段数量是否一致。

3.RegionServer异常退出或超时

错误现象:

任务执行过程中RegionServer频繁崩溃,或日志中出现RegionTooBusyException。

原因分析:

- RegionServer资源不足(如内存、线程数)。

- 数据量过大,未合理拆分Region,导致单Region负载过高。

解决方案:

- 调整资源分配:在hbase-site.xml中增加RegionServer的堆内存(如-Xmx8G)和处理线程数(hbase.regionserver.handler.count)。

- 预分区表:在创建表时通过SPLITS参数预先划分Region,

- create 'table_name', 'cf', {SPLITS => ['rowkey1', 'rowkey2', 'rowkey3']}

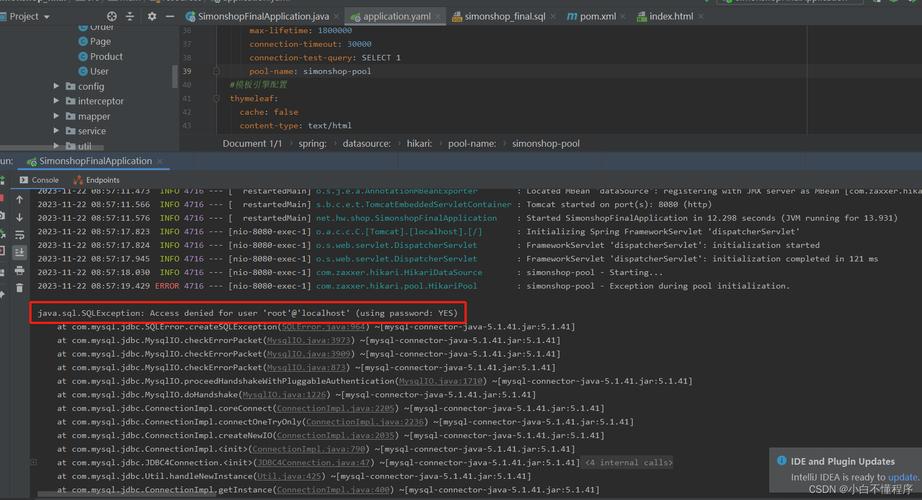

4.权限不足导致的HDFS写入失败

错误现象:

- org.apache.hadoop.security.AccessControlException: Permission denied

原因分析:

- 执行任务的用户对HDFS目录(如HBase的存储路径/hbase/data)缺乏写入权限。

- HBase的WAL(Write-Ahead Log)目录权限配置错误。

解决方案:

- 授予用户权限:通过HDFS命令修改目录权限:

- hdfs dfs -chmod -R 755 /hbase/data

- 检查HBase配置:确认hbase-site.xml中的hbase.rootdir和hbase.wal.dir路径权限正确。

三、高效使用ImportTSV的实践建议

1、数据预处理:

- 使用sed或awk清理TSV文件中的非法字符(如多余的空格、换行符)。

- 通过抽样检查确保数据格式与表结构完全匹配。

2、性能调优:

- 增大MapReduce任务的堆内存:在命令行中添加-Dmapreduce.map.memory.mb=4096。

- 启用批量导入模式(Bulkload),避免直接写入HBase导致RegionServer过载。

3、日志监控:

- 实时跟踪YARN的Application日志(yarn logs -applicationId <app_id>),定位任务失败的具体阶段。

个人观点

在实际运维中,importtsv报错多源于环境配置与数据规范性不足,与其依赖事后排查,不如在数据导入前制定标准化流程:例如通过自动化脚本校验数据格式,预先测试资源配额,对于超大规模数据迁移,建议优先考虑HBase Bulkload结合Spark的方案,以降低对线上服务的冲击。