Hadoop fs ls命令报错排查指南

在使用Hadoop处理大数据时,hadoop fs -ls命令是高频操作之一,用于查看HDFS(Hadoop分布式文件系统)中的目录或文件列表,这条看似简单的命令在实际操作中可能因各种原因报错,导致用户无法正常访问数据,本文将针对常见报错场景,从原因分析到解决方案,提供一套完整的排查思路。

一、为什么hadoop fs -ls会报错?

hadoop fs -ls报错通常与以下四类问题相关:

1、路径权限不足

HDFS的权限模型与Linux类似,如果用户对目标路径没有读取权限(r),执行ls命令时会触发Permission denied错误。

典型报错:

ls: Permission denied: user=user1, access=READ_EXECUTE, inode="/data"2、路径不存在或格式错误

输入路径拼写错误、路径层级缺失,或未遵循HDFS路径规范(如未以/开头),均会导致No such file or directory报错。

典型报错:

ls: `/user/invalid_path': No such file or directory3、HDFS服务异常

如果Hadoop集群的NameNode或DataNode服务未启动,或处于安全模式(Safe Mode),用户将无法正常访问HDFS。

典型报错:

Call From node1/192.168.1.10 to node2:8020 failed on connection exception4、网络或配置问题

客户端与集群节点之间的网络中断,或Hadoop配置文件(如core-site.xml、hdfs-site.xml)中的参数错误(如误配NameNode地址),均可能引发报错。

**二、系统化排查步骤

**1. 验证路径是否正确

检查路径拼写:确认路径是否存在大小写错误或多余空格。

逐级排查路径:

若目标路径较深(如/user/project/data/2023),建议从根目录逐级查看:

hadoop fs -ls /user hadoop fs -ls /user/project ...

使用绝对路径:避免因相对路径的上下文环境不一致导致问题。

**2. 检查用户权限

查看路径权限:

hadoop fs -ls -d /target_path

输出结果中的权限字段(如drwxr-xr-x)表示目录的读写执行权限。

临时提升权限(需管理员操作):

hdfs dfs -chmod 755 /target_path

或为用户添加所属组:

hdfs dfs -chown user1:group1 /target_path

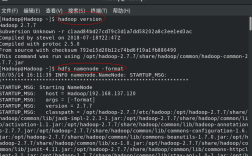

**3. 确认HDFS服务状态

检查NameNode与DataNode:

在集群主节点执行以下命令,确认服务是否运行:

jps | grep -E 'NameNode|DataNode'

退出安全模式:

若集群处于安全模式,执行:

hdfs dfsadmin -safemode leave

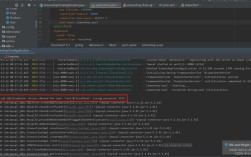

**4. 分析日志定位问题

查看客户端日志:

在提交命令的客户端节点,检查Hadoop日志(默认路径:$HADOOP_HOME/logs),过滤ERROR或WARN级别信息。

查看服务端日志:

登录NameNode节点,检查hadoop-hdfs-namenode-*.log,重点关注权限校验失败或连接超时的记录。

**三、常见错误场景与解决方案

场景1:Permission denied

原因:用户对路径无读取权限。

解决方案:

- 联系管理员授权;

- 临时方案:使用-sudo参数(需配置sudoers权限)。

场景2:No such file or directory

原因:路径不存在或客户端缓存了旧元数据。

解决方案:

- 重新创建路径:hadoop fs -mkdir -p /target_path;

- 刷新元数据:hdfs dfsadmin -refreshNodes。

场景3:Connection refused

原因:NameNode服务未启动,或防火墙拦截端口(默认8020)。

解决方案:

- 启动NameNode服务:hadoop-daemon.sh start namenode;

- 检查端口连通性:telnet namenode_host 8020。

**四、预防报错的建议

1、规范路径命名:统一使用小写字母和短横线()命名目录,避免特殊字符。

2、定期检查服务健康状态:通过HDFS Web UI(默认50070端口)监控集群状态。

3、备份关键数据:使用hadoop fs -cp或DistCp工具定期备份,防止误删导致路径失效。

4、更新Hadoop版本:老旧版本可能存在已知Bug,升级至稳定版可减少异常。

观点

Hadoop报错往往源于细节操作,例如路径拼写错误或权限配置疏忽,解决问题时,优先通过日志定位原因,避免盲目尝试,对于频繁使用的生产环境,建议将HDFS命令封装为脚本,并加入异常检测逻辑,以降低人为操作风险,保持集群配置文档的更新,也是提升运维效率的关键。