在使用Spark Shell进行数据处理或开发过程中,遇到报错是开发者常见的挑战,无论是环境配置问题、语法错误,还是资源不足导致的异常,都需要快速定位原因并解决,本文将从实际案例出发,梳理Spark Shell常见报错场景,并提供可操作的排查思路,帮助开发者提升问题解决效率。

**一、环境配置类报错

典型现象

启动Spark Shell时出现java.lang.NoClassDefFoundError或java.io.IOException: Could not locate executable等错误提示,通常指向环境变量缺失或版本冲突。

原因分析

1、Java版本不兼容:Spark对Java版本有严格限制(如Spark 3.x需Java 8或11)。

2、Hadoop依赖缺失:若本地未安装Hadoop且未配置对应环境变量,可能引发HDFS相关报错。

3、Spark安装路径错误:SPARK_HOME未正确设置或路径包含特殊字符(如空格)。

解决方案

- 检查Java版本:

- java -version

若版本不符,需卸载后安装指定版本,并更新JAVA_HOME环境变量。

- 确认Hadoop配置:

若无需连接Hadoop集群,可在spark-defaults.conf中设置spark.hadoop.fs.defaultFS为本地文件路径(如file:///)。

- 重新配置环境变量:

确保SPARK_HOME指向正确的安装目录,并在系统PATH中添加$SPARK_HOME/bin。

二、依赖冲突引发的ClassNotFoundException

典型现象

执行spark-shell命令后,控制台抛出java.lang.ClassNotFoundException,尤其是在引入第三方JAR包时。

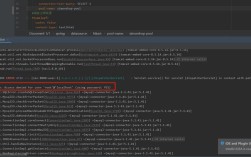

排查步骤

1、检查依赖包完整性

通过--jars参数加载外部依赖时,需确认JAR文件路径正确且文件未损坏。

- spark-shell --jars /path/to/your.jar

2、解决版本冲突

若项目同时依赖多个库(如不同版本的Jackson),可通过spark.driver.extraJavaOptions指定优先级:

- spark-shell --conf "spark.driver.extraJavaOptions=-Djava.class.path=/path/to/preferred-library.jar"

3、使用Maven坐标统一管理

在spark-shell中直接加载Maven仓库的依赖,避免手动管理JAR包:

- :require org.apache.spark:spark-sql_2.12:3.3.1

**三、内存不足导致的OOM异常

错误特征

任务执行时出现java.lang.OutOfMemoryError: Java heap space或Container killed by YARN for exceeding memory limits,表明内存分配不足。

优化方案

1、调整Driver内存

启动Spark Shell时通过--driver-memory参数增加内存:

- spark-shell --driver-memory 4g

2、优化Executor配置

对于分布式任务,需同步调整Executor内存及核心数:

- spark-shell --executor-memory 2g --num-executors 4

3、减少数据倾斜

使用repartition()或salt技术分散热点数据,避免单个Task负载过高。

**四、语法错误与API误用

常见案例

RDD与DataFrame混淆:错误调用map()方法处理DataFrame,应改用selectExpr()或UDF。

惰性求值未触发:忘记调用collect()或show()导致代码逻辑未执行。

序列化问题:在闭包中使用未实现Serializable接口的类。

调试技巧

- 启用详细日志:

- spark-shell --conf "spark.logConf=true"

- 分步执行:

在REPL环境中逐行验证代码,而非一次性运行完整脚本。

**五、资源竞争与集群配置问题

场景还原

提交任务后出现org.apache.spark.SparkException: Job aborted due to stage failure,可能与资源调度策略有关。

应对策略

1、调整动态资源分配

在spark-defaults.conf中启用:

- spark.dynamicAllocation.enabled=true

- spark.shuffle.service.enabled=true

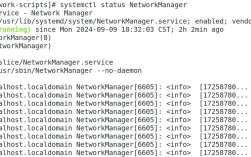

2、检查集群状态

通过YARN ResourceManager或Spark UI确认节点存活情况,排除网络分区或硬件故障。

**个人观点

处理Spark Shell报错的核心在于建立系统化的排查思维:从日志堆栈定位模块,结合环境配置与代码逻辑交叉验证,建议开发者养成以下习惯:

1、记录报错上下文:包括Spark版本、集群规模、数据量级等关键信息;

2、最小化复现:通过剥离业务代码构建可复现的测试用例;

3、善用社区资源:参考Spark官方JIRA列表确认是否为已知问题。

遇到复杂问题不必焦虑,多数报错均有迹可循,保持耐心,逐层拆解,技术债终会转化为经验值。