一、问题描述与分析

在使用 Beeline 连接到 Hive 时,可能会遇到各种报错,以下是一些常见的错误及其解决方案:

1、无法找到 JAR 文件

问题描述:Beeline 启动时提示找不到相关的 JAR 文件。

原因分析:可能是由于环境变量未设置正确,或者所需的 JAR 文件不存在于指定路径。

解决方案:确保HIVE_HOME 和HADOOP_HOME 环境变量已正确设置,并且指向包含所需 JAR 文件的目录,如果问题仍然存在,请检查 Beeline 的安装是否完整,或者尝试重新安装 Beeline。

2、用户权限不足

问题描述:用户尝试以不允许的用户身份连接到 Hive 时报错。

原因分析:Hadoop 引入了安全伪装机制,不允许上层系统直接将实际用户传递到 Hadoop 层,而是通过一个超级代理来执行操作,如果用户没有正确的权限配置,就会报错。

解决方案:在coresite.xml 文件中添加以下配置,允许特定用户通过代理访问 Hadoop 集群:

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>然后重新启动 Hadoop 集群。

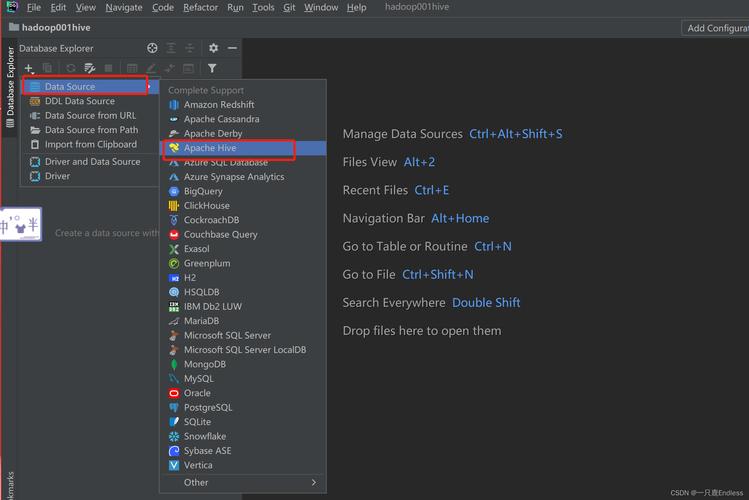

3、JDBC 连接错误

问题描述:Beeline 无法与 Hive 建立 JDBC 连接。

原因分析:可能的原因包括 Hive 服务未启动、端口号错误、防火墙限制或网络问题。

解决方案:

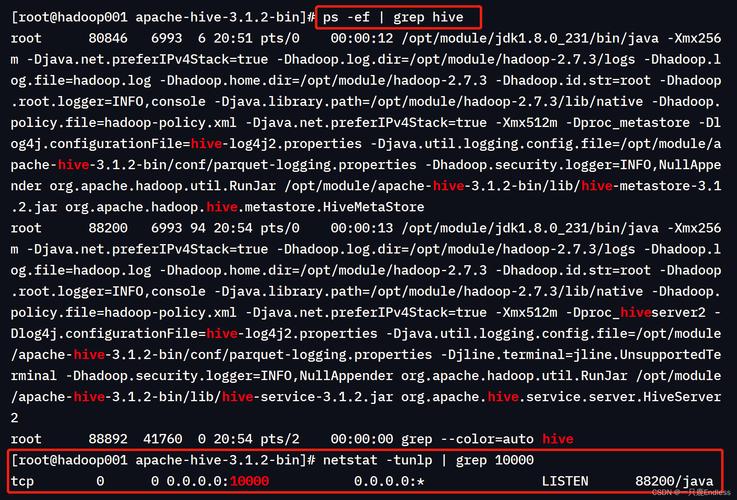

确保 Hive 服务已经启动并且正在运行。

检查 Hive 配置文件(如hivesite.xml)中的 JDBC 端口号设置是否正确,默认情况下,Hive 使用 10000 端口号。

确保防火墙允许从 Beeline 所在的机器到 Hive 的 JDBC 端口的流量,可以尝试临时禁用防火墙进行测试。

检查网络连接是否正常,尝试 ping Hive 服务器的 IP 地址以确保网络连接没有问题。

4、Tez 引擎执行报错

问题描述:在 Beeline 客户端连接 Hive 时,更换引擎为 Tez 执行报错,而使用 MR 引擎则不报错。

原因分析:可能是由于 Hive 的配置文件中某些参数设置不正确,导致 Tez 引擎无法正常工作。

解决方案:检查 Hive 的配置文件(如hivesite.xml),特别是与 Tez 引擎相关的参数设置,确保它们正确无误,如果问题仍然存在,可以尝试升级 Hive 或 Tez 的版本,或者查看官方文档寻求进一步的帮助。

5、SparkBeeline 命令行参数无效

问题描述:在 SparkBeeline 的命令中指定hivevar 选项无效。

原因分析:MRS 集群因新增多 session 管理功能,Hive 的特性hivevar <VAR_NAME>=<VAR_VALUE> 在 Spark 中已不再支持。

解决方案:如果需要在 Spark 中使用变量,可以考虑其他替代方案,如在 Spark SQL 语句中直接定义和使用变量,或者在 Spark 程序中通过代码逻辑来实现变量的传递和使用。

二、FAQs

1、Q: Beeline 启动时提示找不到 JAR 文件怎么办?

A: 确保HIVE_HOME 和HADOOP_HOME 环境变量已正确设置,并指向包含所需 JAR 文件的目录,如果问题仍然存在,请检查 Beeline 的安装是否完整,或者尝试重新安装 Beeline。

2、Q: 用户权限不足导致无法连接到 Hive 怎么办?

A: 在coresite.xml 文件中添加允许特定用户通过代理访问 Hadoop 集群的配置,并重新启动 Hadoop 集群。

3、Q: Beeline 无法与 Hive 建立 JDBC 连接怎么办?

A: 确保 Hive 服务已经启动并且正在运行;检查 Hive 配置文件中的 JDBC 端口号设置是否正确;确保防火墙允许从 Beeline 所在的机器到 Hive 的 JDBC 端口的流量;检查网络连接是否正常。

4、Q: 更换引擎为 Tez 执行报错怎么办?

A: 检查 Hive 的配置文件中与 Tez 引擎相关的参数设置,确保它们正确无误,如果问题仍然存在,可以尝试升级 Hive 或 Tez 的版本,或者查看官方文档寻求进一步的帮助。

5、Q: SparkBeeline 命令中指定hivevar 选项无效怎么办?

A: MRS 集群因新增多 session 管理功能,Hive 的特性hivevar <VAR_NAME>=<VAR_VALUE> 在 Spark 中已不再支持,如果需要在 Spark 中使用变量,可以考虑其他替代方案,如在 Spark SQL 语句中直接定义和使用变量,或者在 Spark 程序中通过代码逻辑来实现变量的传递和使用。