爬虫运行中常见报错类型与解决方案

在网络数据采集过程中,遇到报错几乎是每个开发者或数据分析师的必经之路,本文从实际案例出发,梳理爬虫运行中的高频报错场景,并提供针对性解决思路,帮助用户快速定位问题并优化代码。

**1. HTTP状态码异常

典型表现:403 Forbidden、404 Not Found、500 Internal Server Error

原因分析:

- 目标网站识别爬虫请求并拒绝访问(如缺少合法请求头)。

- 请求的URL路径错误或页面已失效。

- 服务器内部处理异常。

解决方案:

- 添加完整请求头(User-Agent、Referer等),模拟浏览器行为。

- 检查URL有效性,确认目标页面是否存在。

- 捕获异常状态码,设置重试机制或切换代理IP。

- import requests

- headers = {

- 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36...'

- }

- response = requests.get(url, headers=headers, timeout=10)

- if response.status_code == 200:

- # 处理数据

- else:

- print(f"请求失败,状态码:{response.status_code}")

**2. 数据解析失败

典型表现:AttributeError、KeyError、JSONDecodeError

原因分析:

- 网页结构变动导致XPath或CSS选择器失效。

- API返回数据格式与预期不符(如非标准JSON)。

- 动态渲染内容未加载(如JavaScript生成的数据)。

解决方案:

- 使用更稳定的解析方式(如正则表达式结合多层级选择器)。

- 添加异常捕获逻辑,避免程序中断。

- 引入Selenium或Playwright处理动态页面。

- from bs4 import BeautifulSoup

- try:

- soup = BeautifulSoup(html_content, 'lxml')

- title = soup.select_one('.article-title').text

- except AttributeError:

- title = "解析失败,请检查页面结构"

**3. 反爬机制触发

典型表现:IP封禁、验证码弹窗、请求频率限制

原因分析:

- 高频访问触发网站防护策略。

- 请求特征异常(如无Cookies、固定IP)。

解决方案:

- 降低请求频率,随机化访问间隔(如time.sleep(random.uniform(1,3)))。

- 使用代理IP池轮换IP地址。

- 集成第三方验证码识别工具(需注意法律风险)。

**4. 超时与连接错误

典型表现:TimeoutError、ConnectionResetError

原因分析:

- 网络环境不稳定或目标服务器响应慢。

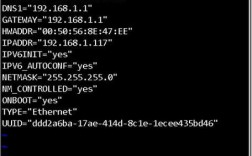

- 本地防火墙或代理配置错误。

解决方案:

- 调整超时参数(如requests.get(url, timeout=15))。

- 使用重试装饰器(retrying库)自动重新发起请求。

**优化建议:提升爬虫稳定性

1、日志记录:详细记录错误信息与请求参数,便于回溯分析。

2、分阶段测试:先验证单页面抓取,再扩展至多线程或分布式架构。

3、遵守Robots协议:避免抓取敏感目录(如/admin/)。

4、模拟人类行为:随机滑动页面、切换浏览器指纹。

**工具推荐

请求库:Requests(轻量)、Scrapy(框架级)

动态渲染:Selenium、Playwright

代理服务:付费IP池(高匿稳定性优先)

调试工具:Postman、Chrome开发者工具

个人观点

爬虫报错本质是开发者与网站防护策略的博弈,解决问题时,需平衡效率与合规性,优先通过技术手段优化代码,而非强行突破限制,长期来看,规范的数据获取方式既能降低法律风险,也能减少维护成本。