10343 lr 报错:深度解析与高效解决方案

在软件开发或机器学习模型训练过程中,遇到报错代码是开发者不可避免的挑战之一。“10343 lr”作为一种特定场景下的错误提示,常让用户感到困惑,本文将从技术原理、常见触发场景及解决方案入手,帮助开发者快速定位问题根源并高效修复。

一、什么是“10343 lr”报错?

“10343 lr”通常与机器学习框架(如TensorFlow、PyTorch)或数据处理工具中的学习率(Learning Rate,简称lr)配置相关,错误代码中的“10343”可能代表某种内部逻辑的异常标识,而“lr”则明确指向学习率参数,该报错的核心原因在于:系统检测到学习率设置与当前任务需求不兼容,导致训练过程无法正常进行。

当学习率过高时,模型参数更新幅度过大,可能引发梯度爆炸;而学习率过低则会导致收敛速度过慢,甚至陷入局部最优解,框架或工具在检测到这类潜在风险时,可能主动抛出“10343 lr”错误以中断进程,防止资源浪费。

二、触发“10343 lr”报错的四大常见场景

1、学习率超出合理范围

部分框架对学习率的取值范围有严格限制,某些优化器要求学习率必须为正数且小于1,若用户误设为负数或极大值(如100),可能直接触发报错。

2、版本兼容性问题

框架版本升级后,部分参数的默认值或校验规则可能发生变化,若用户沿用旧版本的配置代码,可能因新版本的学习率校验机制更严格而报错。

3、数据输入异常

输入数据中存在缺失值(NaN)或分布异常(如方差过大),可能间接导致优化器计算出的梯度异常,进而被框架判定为学习率相关错误。

4、硬件资源限制

当显存(GPU)或内存(CPU)不足时,框架可能无法正常完成学习率相关的计算任务,从而抛出错误代码。

三、分步解决方案:从排查到修复

步骤1:检查学习率参数的合法性

- 确认代码中学习率(lr)的赋值是否符合框架要求,PyTorch的Adam优化器默认学习率为0.001,若手动设置为0,可能直接报错。

- 使用动态学习率调整策略(如ReduceLROnPlateau)时,需确保回调函数的参数逻辑正确。

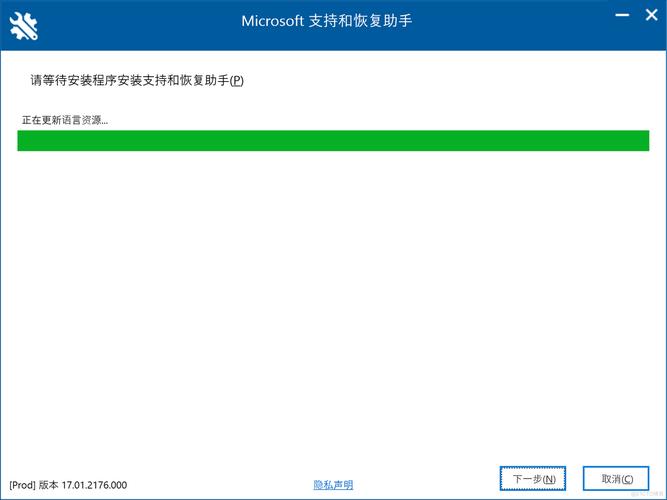

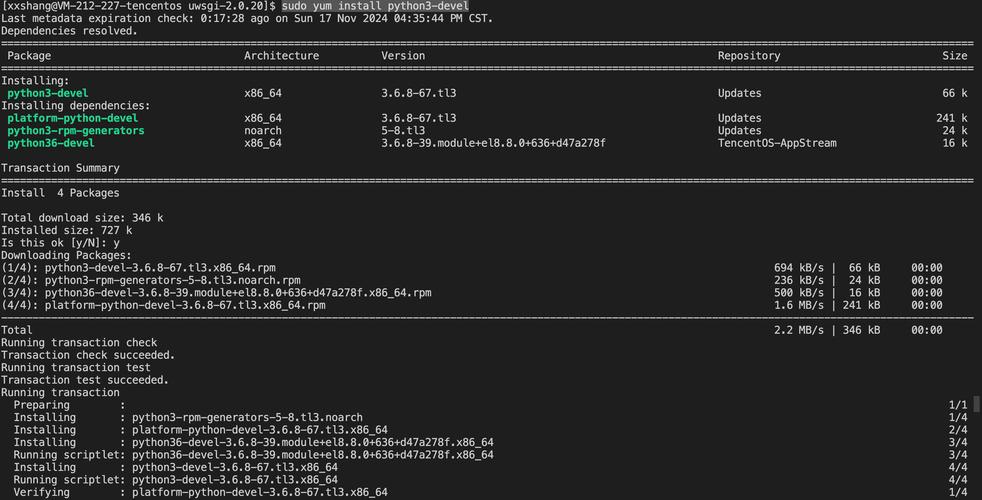

**步骤2:验证框架版本与依赖项

- 通过命令pip show tensorflow或conda list pytorch查看当前环境版本。

- 对照官方文档,确认代码中学习率的设置方式是否适配当前版本。

步骤3:数据预处理与异常值检测

- 对输入数据进行标准化(Normalization)或归一化(Standardization),避免因数据尺度差异导致梯度计算异常。

- 使用np.isnan()或torch.isnan()函数检查数据中是否存在NaN值。

**步骤4:监控硬件资源占用

- 在训练过程中,通过nvidia-smi(GPU)或任务管理器(CPU)实时监控资源使用情况。

- 若资源不足,可尝试减小批量大小(Batch Size)或升级硬件配置。

四、预防“10343 lr”报错的最佳实践

1、遵循官方文档的推荐配置

主流框架通常会提供不同任务的基准学习率范围,图像分类任务的学习率常设置在0.1到0.0001之间,而自然语言处理任务可能更低。

2、启用自动化调试工具

使用TensorBoard或WandB等工具可视化训练过程,实时观察学习率与损失值的变化趋势,提前发现潜在问题。

3、代码健壮性设计

在设置学习率时,添加合法性校验逻辑。

- assert lr > 0, "学习率必须为正值"

4、定期更新开发环境

关注框架社区的更新公告,及时适配新版本的API变更和功能优化。

**个人观点

“10343 lr”报错虽看似复杂,但其本质是系统对参数合理性的保护机制,开发者应将其视为优化模型的“警示信号”,而非单纯的技术障碍,通过规范化编码习惯、深入理解框架设计逻辑,不仅能快速解决此类问题,还能提升整体工程效率。

提示:若上述方法仍未解决问题,建议在开发者社区(如Stack Overflow、GitHub Issues)中提交完整的报错日志与代码片段,以便获得更精准的技术支持。