MongoDB常见报错解析与应对方案

在使用MongoDB的过程中,无论是开发还是运维人员,都可能遇到各种报错信息,这些报错看似复杂,但大多可以通过系统化的排查和调整快速解决,本文将针对高频出现的几类MongoDB报错,分析其成因并提供具体解决方案,帮助用户提升数据库管理效率。

1. 连接失败:MongoNetworkError: failed to connect to server

错误场景

尝试通过客户端或应用程序连接MongoDB时,提示网络连接失败。

原因分析

- MongoDB服务未启动,或监听地址配置错误(如绑定到127.0.0.1而非0.0.0.0)。

- 防火墙或安全组策略拦截了端口(默认27017)。

- 客户端与服务器版本不兼容,或认证机制不匹配(如SCRAM-SHA-1与SCRAM-SHA-256)。

解决方案

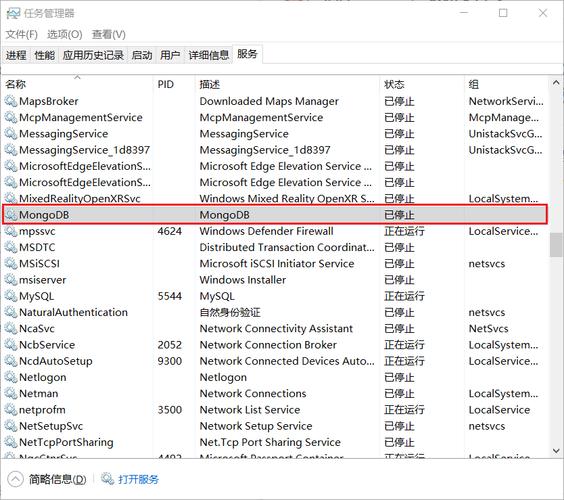

1、检查服务状态:

- systemctl status mongod

若服务未启动,执行systemctl start mongod。

2、修改监听地址:

在配置文件mongod.conf中,将bindIp设为0.0.0.0并重启服务。

3、开放防火墙端口:

- sudo ufw allow 27017

4、确认认证方式:

在客户端连接时显式指定认证机制,

- mongo --authenticationMechanism SCRAM-SHA-256

2. 主键冲突:E11000 duplicate key error

错误场景

插入或更新文档时,提示唯一索引字段值重复。

原因分析

- 显式定义的唯一索引(如_id或自定义字段)存在重复值。

- 未正确处理并发写入,导致多个线程同时生成相同主键。

解决方案

1、检查索引定义:

- db.collection.getIndexes()

确认冲突字段是否被标记为unique。

2、清理重复数据:

使用聚合管道找出重复值并删除:

- db.collection.aggregate([

- { $group: { _id: "$field", count: { $sum: 1 } } },

- { $match: { count: { $gt: 1 } } }

- ])

3、优化主键生成逻辑:

使用ObjectId()或分布式ID生成算法(如雪花算法)避免冲突。

3. 内存不足:MongoDB error: Out of memory

错误场景

数据库运行过程中突然崩溃,日志提示内存不足。

原因分析

- 未限制MongoDB内存使用,导致进程占用全部系统资源。

- 查询未使用索引,触发全表扫描,消耗大量内存。

解决方案

1、限制内存使用:

在配置文件中设置wiredTiger引擎缓存大小(通常为系统内存的50%-70%):

- storage:

- wiredTiger:

- engineConfig:

- cacheSizeGB: 4

2、优化查询性能:

- 通过explain()分析慢查询,添加缺失索引。

- 避免全表扫描,使用limit()和projection减少返回数据量。

4. 查询超时:cursor id not found

错误场景

执行复杂查询时,客户端抛出游标超时错误。

原因分析

- 默认游标存活时间(cursorTimeoutMillis)过短,长查询未及时返回结果。

- 查询未分页,返回数据量过大。

解决方案

1、延长游标超时时间:

- db.collection.find().maxTimeMS(60000) // 60秒

2、分批次获取数据:

使用skip()和limit()实现分页,或通过_id范围查询增量加载。

5. 写入拒绝:writeConcernError

错误场景

写入操作未按预期完成,提示写入确认失败。

原因分析

- 副本集模式下,主节点未收到足够从节点的写入确认。

- 网络延迟或从节点故障,导致写入无法同步。

解决方案

1、调整写入确认级别:

- db.collection.insertOne(doc, { writeConcern: { w: "majority" } })

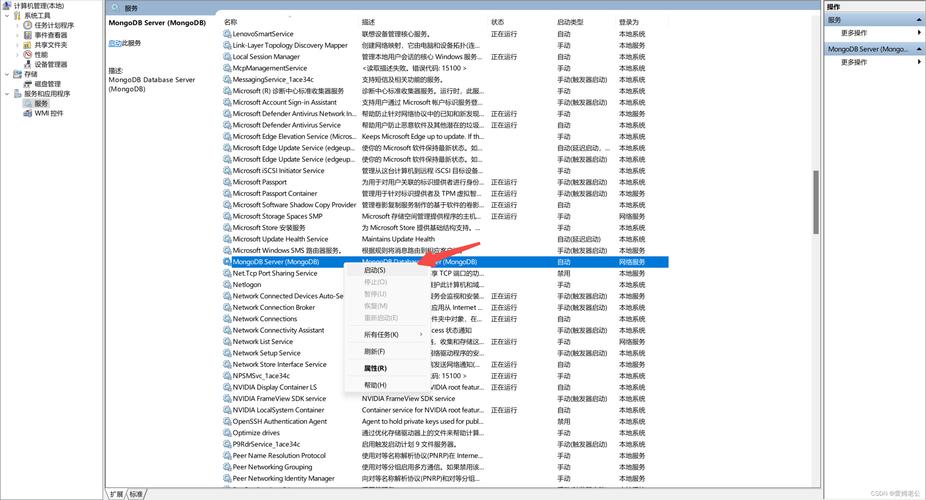

2、检查副本集状态:

- rs.status()

确保所有节点处于PRIMARY或SECONDARY状态,并修复异常节点。

6. 副本集同步异常:oplog size insufficient

错误场景

副本集从节点同步延迟,日志提示oplog过小。

原因分析

- 默认oplog大小(约5%磁盘空间)无法支撑高写入负载。

解决方案

1、动态调整oplog大小:

- db.adminCommand({ replSetResizeOplog: 1, size: 1024 }) // 单位:MB

2、监控同步延迟:

使用db.printReplicationInfo()定期检查oplog窗口时间。

**个人观点

MongoDB的报错信息通常直接反映了底层运行状态,解决问题的关键在于准确理解错误日志,并建立系统化的排查流程,建议结合监控工具(如Prometheus+Grafana)实时跟踪数据库健康度,同时在设计阶段遵循最佳实践(如索引优化、内存控制),可大幅降低运维风险,遇到复杂问题时,优先查阅官方文档与社区案例,避免盲目调整配置。