MySQL报错重复:常见原因与高效解决方案

在日常的数据库管理过程中,许多开发者或运维人员都遇到过MySQL报错重复的问题,这类报错不仅影响数据写入效率,还可能引发业务逻辑的混乱,本文将深入分析MySQL中重复报错的典型场景,并提供针对性的解决方案,帮助读者快速定位问题并优化数据库操作。

一、重复报错的典型场景与错误信息

MySQL中的重复报错通常与主键(Primary Key)或唯一约束(Unique Constraint)冲突相关,以下是几种常见情况:

1、插入重复的主键值

当尝试向表中插入一条数据,而该数据的主键字段值与已有记录完全相同时,MySQL会抛出错误:

ERROR 1062 (23000): Duplicate entry 'XXX' for key 'PRIMARY'

主键的唯一性决定了每条记录必须有唯一的标识,重复值会导致写入失败。

2、违反唯一索引约束

如果表中定义了唯一索引(Unique Index),插入或更新数据时若违反该约束,同样会触发报错:

ERROR 1062 (23000): Duplicate entry 'XXX' for key 'index_name'

用户表的邮箱字段设置为唯一索引,重复邮箱会导致此错误。

3、事务并发导致的数据冲突

在高并发场景下,多个事务同时操作同一行数据时,可能因隔离级别或锁机制不完善,导致“死锁”或“重复提交”问题。

4、批量导入数据时的疏忽

通过LOAD DATA或程序批量插入数据时,若未提前检查重复值,可能触发大量报错,影响执行效率。

**二、问题根源解析

要解决重复报错,需先理解其背后的数据库机制:

1、主键与唯一索引的作用

主键和唯一索引的本质是强制数据唯一性,它们通过B+树结构快速定位数据,确保特定字段(或字段组合)的值不重复。

2、事务隔离级别的影响

MySQL默认的隔离级别为可重复读(REPEATABLE READ),在此级别下,事务内多次读取同一数据的结果一致,但若未合理使用锁(如SELECT ... FOR UPDATE),可能导致并发写入冲突。

3、开发逻辑的疏漏

部分开发者习惯依赖程序层判断数据是否存在,而非直接利用数据库的唯一性约束,这种设计在并发场景下容易失效。

**三、高效解决方案与实操建议

**场景1:主键或唯一索引冲突

解决方案:

检查现有数据

执行插入操作前,先查询目标值是否已存在:

SELECT * FROM table WHERE unique_field = 'value';

若存在,则需更新原有数据或跳过插入。

使用INSERT IGNORE

INSERT IGNORE会忽略重复错误,仅插入不冲突的数据:

INSERT IGNORE INTO table (id, name) VALUES (1, 'John');

ON DUPLICATE KEY UPDATE语法

若需在冲突时更新其他字段,可使用此语法:

INSERT INTO table (id, name) VALUES (1, 'John') ON DUPLICATE KEY UPDATE name = 'John';

**场景2:高并发下的重复提交

解决方案:

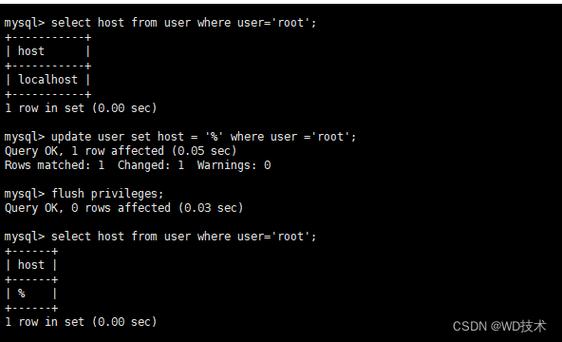

调整事务隔离级别

将隔离级别设为串行化(SERIALIZABLE),但可能牺牲性能,更推荐使用乐观锁或悲观锁控制并发。

添加唯一性校验

在业务代码中,结合数据库的唯一约束,对关键字段进行二次校验,注册时先查询邮箱是否已被占用。

分布式锁机制

在分布式系统中,使用Redis或ZooKeeper实现分布式锁,避免多节点同时操作同一数据。

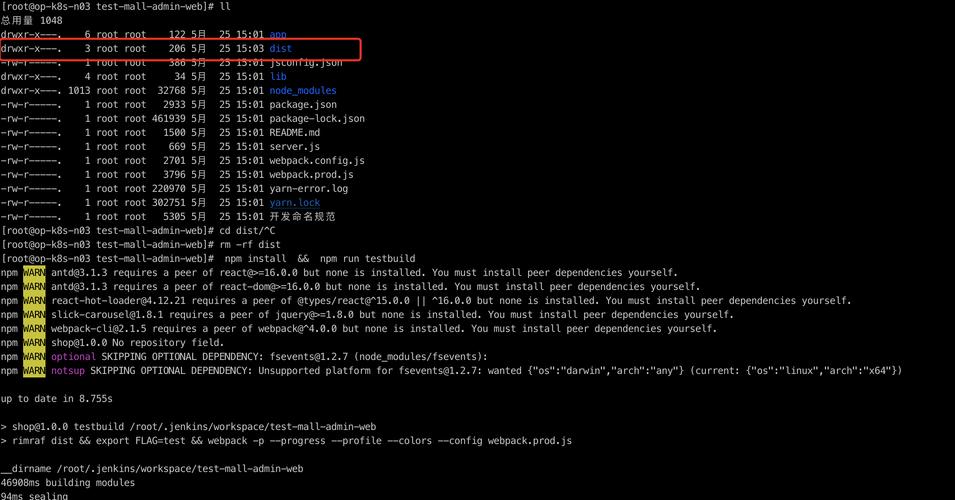

场景3:批量导入数据时的重复处理

解决方案:

预处理数据去重

在导入前,通过脚本或工具对数据源进行去重,例如使用Python的pandas库:

df.drop_duplicates(subset=['unique_field'], inplace=True)

使用REPLACE语句

REPLACE会先删除重复记录,再插入新数据,但需注意其可能导致的副作用(如自增ID不连续)。

分批次提交

将大批量数据拆分为小批次处理,每批次完成后立即提交事务,减少锁竞争和回滚风险。

**四、预防重复报错的最佳实践

1、合理设计表结构

- 主键尽量使用与业务无关的自增字段(如AUTO_INCREMENT)。

- 对需要唯一性的字段显式添加唯一索引,而非依赖程序逻辑。

2、规范数据操作流程

- 在代码层封装数据库操作,统一处理重复异常。

- 对高频写入的接口增加限流或队列机制,降低并发压力。

3、监控与日志分析

- 开启MySQL的慢查询日志,定期分析高频报错的SQL语句。

- 使用Prometheus或ELK监控数据库性能,及时发现潜在问题。

个人观点

作为长期与MySQL打交道的开发者,我认为重复报错的核心在于“防大于治”,在数据库设计阶段,明确唯一性约束并建立合理的索引,能从根本上减少此类问题,在高并发场景下,需结合业务特点选择锁机制,而非盲目提高隔离级别,建议团队定期复盘数据库报错日志,将典型问题转化为优化案例,逐步提升系统的健壮性。