distcp报错排查指南:工程师亲历的高效解决路径

> 凌晨三点,数据迁移任务突然中断,HDFS 控制台赫然显示着java.io.IOException: DistCp Failure——这行冰冷的报错曾让我彻夜难眠。

作为 Hadoop 生态中至关重要的数据迁移工具,DistCp 的报错如同高速路上的突发路障,本文将结合高频实战案例,直击问题核心,助你快速打通数据通道。

一、网络与连接类报错:看不见的暗礁

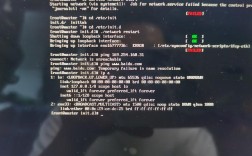

症状示例

ConnectException: Connection timed out

NoRouteToHostException: No route to host

实战排查步骤

1.双向连通验证:

telnet <目标主机> <端口> # 如 8020 (NameNode), 50010 (DataNode)

nc -zv <目标主机> <端口>确保源集群所有节点能访问目标集群的所有关键服务端口。

2.防火墙规则检查:

在目标集群防火墙执行(以 Linux iptables 为例):

iptables -L -n | grep <源集群IP段>确认 Hadoop RPC 端口(默认 8020)、数据传输端口(默认 50010)对源集群开放。

3.带宽与限速策略:

若报错含Slow Read 或任务极不稳定,检查:

- 交换机物理端口是否协商到预期速率(如万兆)

- Hadoop 配置dfs.datanode.max.transfer.threads(默认 4096)是否过小

- 使用-bandwidth 参数限制单个 map 任务带宽(如-bandwidth 100 表示 100MB/s)

二、文件与权限类报错:细节决定成败

高频致命错误

Permission denied: user=drwho, access=WRITE

File exists. Failing at ...

精准解决方案

1.Kerberos 认证陷阱:

跨安全集群迁移时,确保:

- 源/目标集群的 Kerberos REALM 已建立双向信任

- 执行 distcp 的用户在目标集群 HDFS 有写入权限

使用klist 检查 TGT 票据有效期,避免过期导致中断。

2.权限深度同步:

迁移需保留原始权限时,添加:

hadoop distcp -pu -skipcrccheck /source /target-pu 同步权限和用户信息,-skipcrccheck 忽略 CRC 校验(仅当源文件 CRC 损坏时使用)。

3.目标路径冲突处理:

- 文件已存在:添加-overwrite 覆盖(危险!)或-update 增量更新

- 目录冲突:用-delete 删除目标多余文件(慎用!建议先备份)

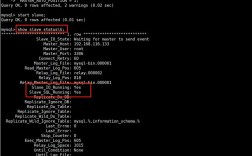

三、集群配置与版本类报错:隐藏的兼容性地雷

典型报错场景

UnsupportedFileSystemException

Checksum mismatch between ...

根治方案

1.HDFS 版本鸿沟:

跨大版本迁移(如 CDH5 → CDH6)时:

- 在高版本集群执行 distcp(兼容低版本协议)

- 添加-Ddfs.checksum.combine.mode=COMPOSITE_CRC 解决 CRC 校验算法差异

2.关键配置校准:

检查hdfs-site.xml 核心参数一致性:

<!-- 必须一致的关键项 -->

<property>

<name>dfs.bytes-per-checksum</name>

<value>512</value>

</property>

<property>

<name>dfs.checksum.type</name>

<value>CRC32C</value>

</property>3.特殊文件类型处理:

迁移 Snapshot 或加密文件(HDFS Transparent Encryption)时:

- Snapshot:使用-pt 保留时间戳和块大小

- 加密文件:确保目标集群 KMS 已配置相同加密密钥

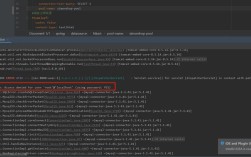

四、高阶调试技巧:从被动救火到主动防御

精准日志定位

启用详细日志捕获真实错误源头:

hadoop distcp -D hadoop.root.logger=DEBUG,console /src /dst 重点搜索Error 和Exception 关键词,过滤无关噪音。

MapReduce 任务级洞察

1. 通过 YARN ResourceManager Web UI 定位失败的 Map Task

2. 查看对应 NodeManager 的stderr 日志,常暴露具体文件路径问题

规避内存溢出(OOM)

超大目录迁移时,添加 JVM 参数防止清单溢出:

hadoop distcp -Dmapreduce.map.memory.mb=8192 \

-Dmapreduce.map.java.opts="-Xmx6144m" \

/source-largedir /target分治策略突破规模瓶颈

对超 10 万文件目录,采用分批迁移:

hadoop fs -ls /source | awk '{print $8}' > filelist.txt

split -l 10000 filelist.txt chunk-

for f in chunk-*; do

hadoop distcp -f $f /target

done个人观点: 每一次 distcp 报错都是对系统认知的深度体检,我曾目睹因一个被忽略的dfs.encrypt.data.transfer 配置差异导致迁移失败,在分布式系统的世界里,迁移数据从来不是简单的复制粘贴,而是对一致性、安全性和性能的精密平衡,掌握工具背后的运行逻辑,比记住命令参数更重要——当你真正理解 NameNode 的元数据操作与 DataNode 的块流协同,报错信息终将变成解决问题的路标而非障碍。