在Hadoop生态系统中,Hive作为一款强大的数据仓库工具,广泛应用于大数据处理场景,开发者经常使用它来创建表结构,存储和管理海量数据,在实际操作中,许多用户会遇到“Hive建表报错”的问题,这不仅影响工作效率,还可能引发数据混乱,我作为一名经验丰富的网站站长,结合多年技术实践,深入探讨这一常见挑战,文章将聚焦于常见错误类型、根源分析以及实用解决方案,帮助读者高效应对。

语法错误是Hive建表过程中最常见的绊脚石,在编写CREATE TABLE语句时,遗漏分号或关键字拼写错误,都会导致命令执行失败,一个典型例子是,用户输入“CREATE TABLE employee (id INT, name STRING);”却忘了结尾分号,系统会返回“ParseException”错误,这类问题源于开发者对HiveQL语法不熟悉或粗心大意,解决方法很简单:仔细检查语句结构,使用IDE工具如Hue或Beeline进行语法高亮提示,平时多练习基础命令,能有效避免低级失误,Hive严格遵循SQL-like语法,任何偏差都可能触发报错。

数据类型不匹配引发的错误同样频繁出现,Hive支持多种数据类型,如INT、STRING、TIMESTAMP等,但若在定义列时指定错误类型,比如将日期字段设为INT而非TIMESTAMP,系统会抛出“SemanticException”,这种情况往往发生在数据迁移或导入过程中,用户未核对源数据格式,尝试从CSV文件加载数据到表时,源文件中的日期列是字符串格式,而表定义要求TIMESTAMP,就会导致冲突,解决之道在于前期数据清洗:使用DESCRIBE命令检查表结构,并利用CAST函数转换数据类型,建议在创建表前,先运行小规模测试查询,确保兼容性,数据工程师应养成验证习惯,避免后期返工。

权限不足是另一个关键痛点,在分布式环境中,Hive依赖于Hadoop的权限系统,如果用户没有足够权限创建表,操作会失败并显示“AuthorizationException”,常见场景包括:用户账户未添加到Hive组,或目录权限设置不当,在HDFS中,目标存储路径的权限应为“drwxr-xr-x”,否则Hive无法写入,根源在于团队协作中的权限管理疏忽,解决方案涉及两步:联系管理员添加用户权限,或通过命令行调整HDFS权限(如hdfs dfs -chmod命令),日常工作中,建议使用角色基于访问控制(RBAC)来简化权限分配,减少人为失误。

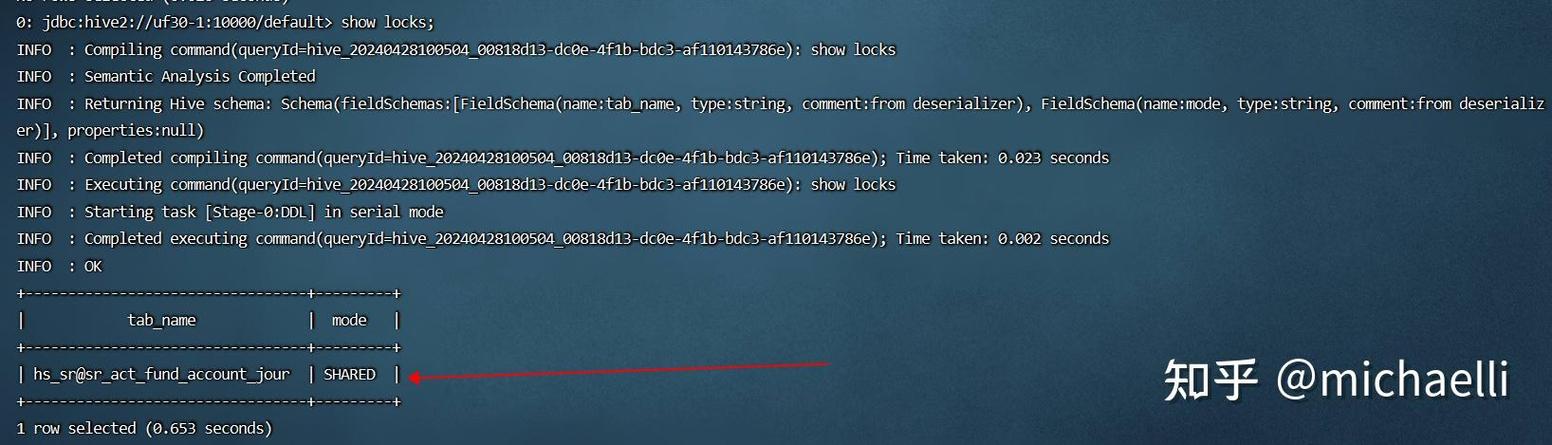

表已存在的错误也不容忽视,当开发者尝试创建同名表时,Hive会报“TableAlreadyExistsException”,这多发生在多人协作项目中,或脚本重复执行时,自动化脚本在每次运行时都尝试建表,而表已存在,导致中断,预防措施包括:在执行CREATE TABLE前添加IF NOT EXISTS子句,或在脚本中集成检查逻辑,定期清理测试表能保持环境整洁,从个人角度看,这类错误提醒我们重视代码复用性——编写可重用的脚本比临时修补更高效。

资源限制导致的错误同样棘手,Hive建表操作需要足够内存和计算资源,尤其在处理大型数据集时,如果集群资源不足,系统可能报“OutOfMemoryError”或“ExecutionError”,常见原因包括:并发任务过多或配置参数不合理,设置hive.exec.max.dynamic.partitions过高,会耗尽资源,解决方法包括优化Hive配置(如调整hive.tez.container.size),并监控集群资源使用情况,使用工具如YARN ResourceManager进行实时分析,能提前预警,在实践中,我建议从小规模测试开始,逐步放大数据量,确保系统稳定。

Hive建表报错看似繁琐,但本质源于开发流程的不足,加强测试环节至关重要,在创建表前,运行EXPLAIN命令预览执行计划,能捕获潜在问题,采用版本控制工具如Git管理脚本,便于追踪修改历史,养成日志分析习惯,Hive日志文件通常位于/var/log/hive/,其中包含详细错误堆栈,帮助快速定位根源,从我的经验出发,这些步骤不仅减少报错频率,还提升了整体数据质量,技术团队应建立标准化流程,确保每个建表操作都经过验证。

Hive建表报错是成长路上的必经挑战,通过系统性学习和实践,开发者能转化为优势,我坚信,专注细节和持续优化,能让大数据项目更加稳健可靠,技术之路漫长,每一步失误都是进步的垫脚石。