在使用Apache Spark时,启动错误可能会发生,这通常是由于配置问题、资源分配不当或环境设置不正确等原因造成的,以下是对Spark启动报错问题的详细分析:

1、配置问题

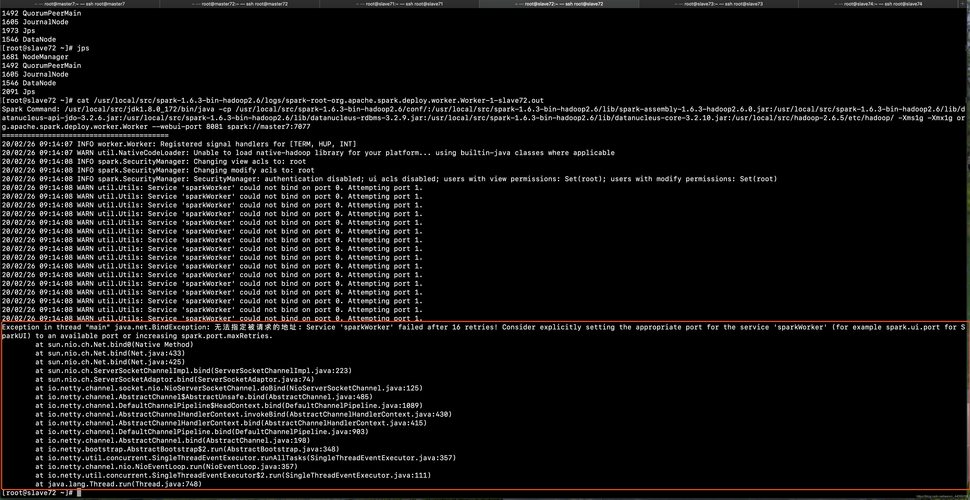

同一节点启动多个Spark Master或Worker:在同一节点上启动多个Spark Master或Worker可能会导致端口冲突或资源过载,从而导致启动失败,解决这个问题的方法是停止额外的Master或Worker进程,并确保每个节点上只运行一个实例。

环境变量配置错误:环境变量配置不当,如JAVA_HOME或SPARK_HOME设置不正确,也会导致Spark启动失败,需要检查并正确设置这些环境变量。

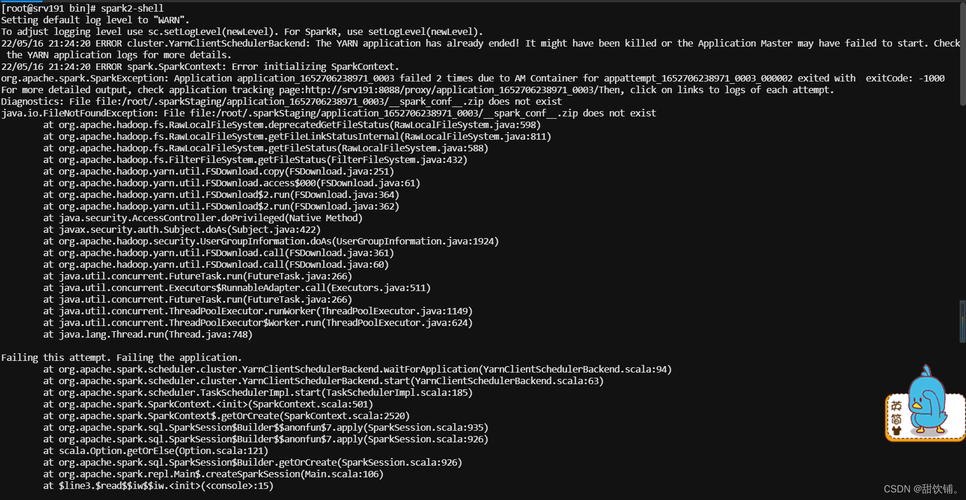

Hadoop和Spark配置不兼容:如果Hadoop和Spark的配置参数不兼容,例如YARN的资源分配内存限制过低,也会阻止Spark正常启动,需要调整yarn.scheduler.maximumallocationmb等参数以满足Spark的资源需求。

2、资源分配问题

内存分配不足:YARN或Spark资源配置中指定的内存量低于应用程序的需求,会导致启动失败,解决方法是增加yarn.nodemanager.resource.memorymb的值,以提供足够的内存资源。

CPU资源不足:在Spark集群中,如果CPU资源不足或者配置不当,也可能导致启动失败,需要检查和调整相关的CPU资源配置。

3、权限和路径问题

文件系统权限不足:在HDFS或其他分布式文件系统上,如果Spark的用户没有足够的权限写入必要的目录,会导致启动失败,需要调整文件系统的权限设置,确保Spark用户有适当的访问权限。

配置文件路径错误:如果Spark的配置文件路径设置错误,或配置文件不存在,也会导致启动失败,需要检查sparkenv.sh和sparkdefaults.conf等配置文件的路径和内容。

4、网络问题

网络配置不当:网络配置问题,如错误的主机名或IP地址,可能导致Spark无法建立与其他节点的连接,从而启动失败,需要检查和修正/etc/hosts或网络配置文件中的设置。

端口冲突:如果所需端口已被其他应用程序占用,Spark可能无法启动,需要查找并解决端口冲突问题。

5、软件兼容性和版本问题

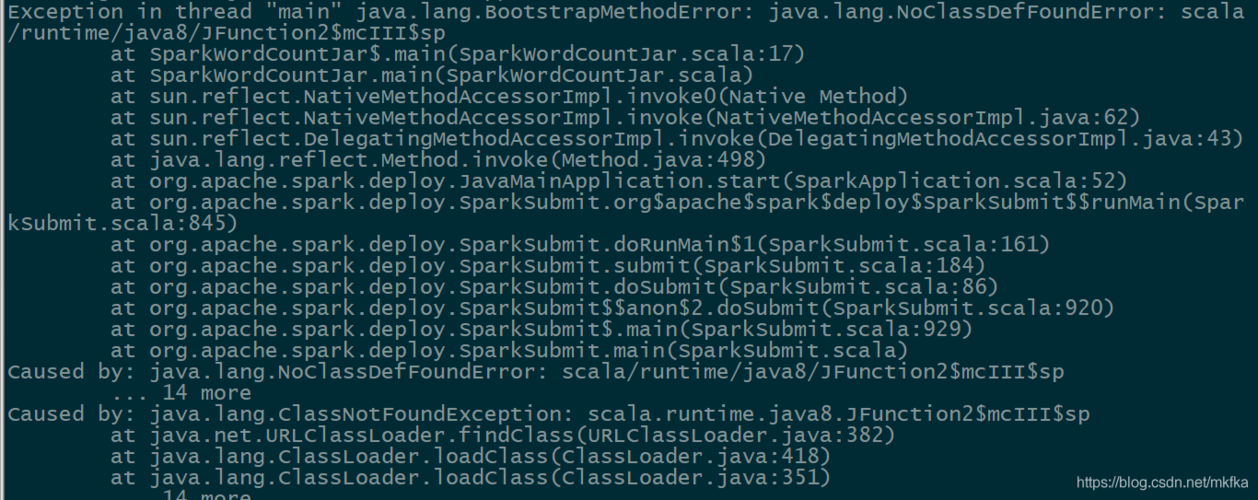

依赖库版本不匹配:Spark的某些依赖库可能与当前环境中的版本不兼容,导致启动失败,需要检查并确保所有依赖库的版本与Spark兼容。

操作系统兼容性问题:在某些操作系统上,可能需要特定的配置或补丁才能成功运行Spark,需要查阅相关文档以确保操作系统与Spark兼容。

针对这些问题,可以通过以下步骤进行诊断和解决:

1、查看错误日志,找出具体的错误信息和可能的原因。

2、根据错误信息调整配置文件,如sparkdefaults.conf和sparkenv.sh。

3、检查资源分配,如内存和CPU,确保它们满足Spark的要求。

4、确认所有的环境变量都已正确设置。

5、如果问题依旧存在,考虑在社区论坛或官方文档中寻找解决方案或寻求帮助。

FAQs:

1、为什么Spark启动时会报错?

Spark启动时可能会因为多种原因报错,包括配置错误、资源分配不当、环境变量设置错误、网络问题等,每个错误都有具体的原因和解决方法,重要的是根据错误日志中的信息来确定具体的问题所在,并采取相应的解决措施。

2、如何预防Spark启动时出现的错误?

预防Spark启动错误的最好方法是确保所有配置都正确无误,包括环境变量和资源分配,保持软件版本更新,确保所有依赖项都与Spark兼容也很重要,在做出任何重大更改之前备份配置文件,以便在出现问题时可以恢复原始设置,也是一个好的实践。

Spark启动报错可能由多种因素引起,从配置错误到资源分配问题,再到环境设置不当等,解决这些问题通常需要详细检查错误日志,并根据日志中的信息调整配置或解决其他相关问题,通过理解这些常见问题及其解决方法,用户可以更有效地管理和使用Spark集群。