在使用K折交叉验证(KFold Cross Validation)时,如果遇到了错误或报错,通常需要根据具体的错误信息来进行排查和解决,以下是一些常见的问题及其解决方法:

常见问题及解决方法

1、数据集为空

问题描述: 如果输入的数据集为空或者包含的数据量不足以进行K折交叉验证,会引发错误。

解决方法: 确保数据集不为空并且包含足够的数据,对于K折交叉验证,至少需要有K个样本。

2、标签与特征不匹配

问题描述: 在监督学习中,特征矩阵和标签向量的长度不匹配,会导致错误。

解决方法: 确保特征矩阵的行数与标签向量的长度相同,如果你有N个样本,那么特征矩阵应该是N x M的形状,标签向量应该是N x 1的形状。

3、模型训练失败

问题描述: 在某些情况下,模型可能无法成功训练,导致K折交叉验证失败。

解决方法: 检查模型的训练过程,确保没有其他问题,检查是否有适当的超参数设置、数据预处理是否正确等。

4、内存不足

问题描述: K折交叉验证可能会消耗大量内存,尤其是在处理大数据集时。

解决方法: 尝试减小数据集的大小,或者使用增量学习(Incremental Learning)的方法来减少内存消耗。

5、代码实现错误

问题描述: 代码中的逻辑错误或语法错误可能导致K折交叉验证无法正常运行。

解决方法: 仔细检查代码逻辑,确保没有语法错误或逻辑错误,可以使用调试工具来帮助发现问题。

6、库版本不兼容

问题描述: 使用的机器学习库版本不兼容,可能会导致K折交叉验证出错。

解决方法: 确保所有依赖库的版本都是最新的,并且相互兼容,可以通过pip list命令查看已安装库的版本。

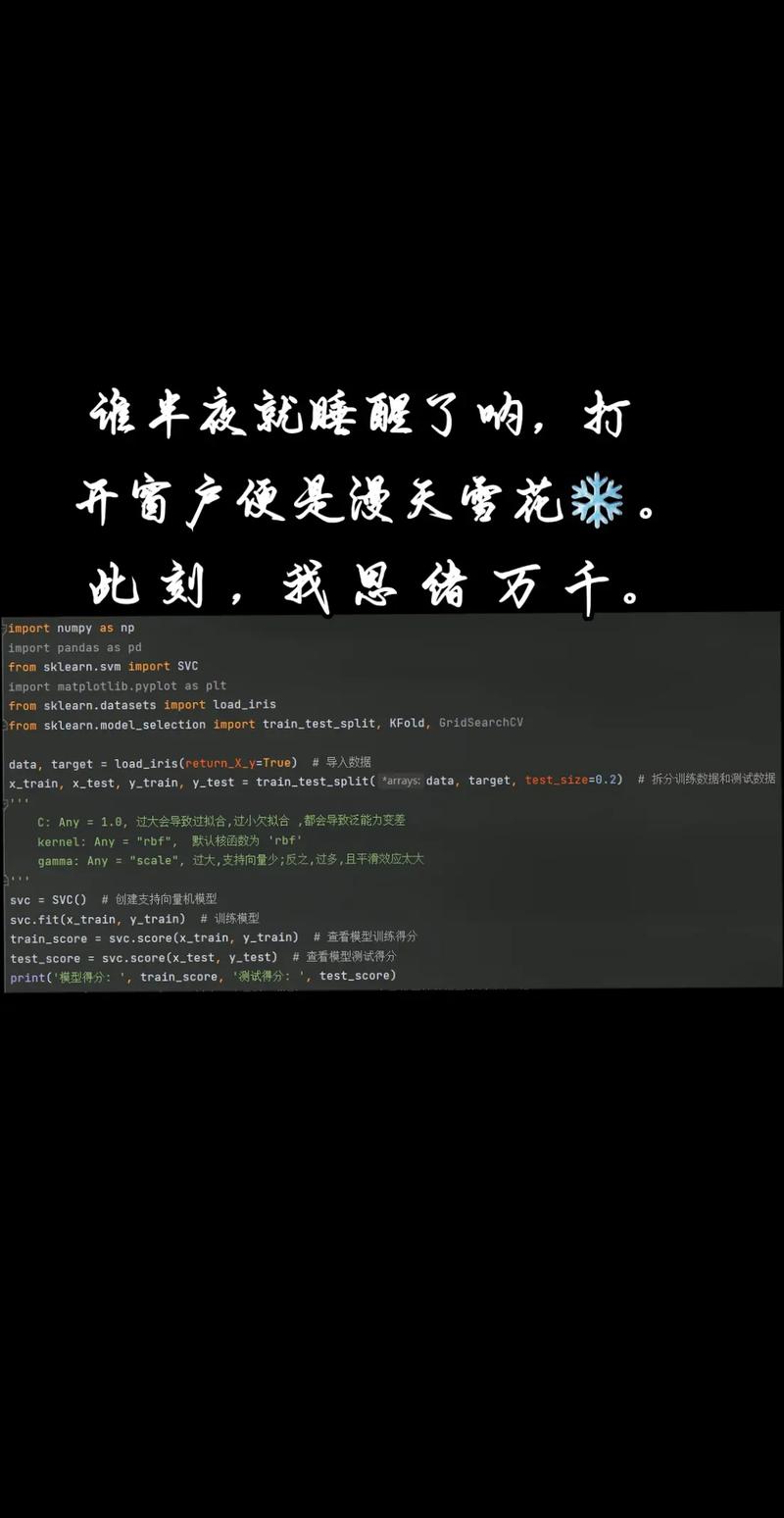

示例代码及错误分析

假设我们使用scikitlearn库进行K折交叉验证,以下是一个示例代码:

import numpy as np

from sklearn.model_selection import KFold

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

生成示例数据

X = np.random.rand(100, 5)

y = np.random.rand(100)

初始化K折交叉验证

kf = KFold(n_splits=5)

存储每折的结果

mse_scores = []

for train_index, test_index in kf.split(X):

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 训练模型

model = LinearRegression()

model.fit(X_train, y_train)

# 预测并计算均方误差

y_pred = model.predict(X_test)

mse = mean_squared_error(y_test, y_pred)

mse_scores.append(mse)

print("Mean Squared Error scores:", mse_scores)

print("Average MSE:", np.mean(mse_scores))在这个示例中,如果遇到错误,可以根据上述常见问题及解决方法进行排查,如果数据集为空,可以添加检查数据集大小的代码:

if len(X) == 0 or len(y) == 0:

raise ValueError("数据集不能为空")FAQs

Q1: K折交叉验证中的K值如何选择?

A1: K值的选择取决于数据集的大小和项目的具体要求,通常情况下,K值可以选择5或10,如果数据集较小,可以选择较小的K值以避免过拟合;如果数据集较大,可以选择较大的K值以获得更稳定的评估结果。

Q2: K折交叉验证的结果如何解释?

A2: K折交叉验证的结果通常包括每个折的评估指标(如均方误差MSE)以及平均指标,通过比较不同模型的平均评估指标,可以选择性能最好的模型,标准差也可以用来衡量模型的稳定性,如果标准差较大,说明模型对不同的数据划分较为敏感,可能需要进一步优化模型或增加数据量。