Scrapy是一个流行的Python网络爬虫框架,但在使用中可能会遇到各种问题,以下是一些常见的错误及其解决方法:

1、依赖项问题

描述:Scrapy依赖于许多第三方库,如lxml、cssselect、w3lib等,如果这些库未正确安装,会导致Scrapy运行时出现错误。

解决方案:确保所有依赖项已正确安装,可以使用pip命令来安装这些库。

pip install lxml cssselect w3lib2、配置错误

描述:Scrapy的配置文件是settings.py,其中包含了许多可配置的选项,如果配置不正确,可能会导致Scrapy运行失败。

解决方案:检查配置文件中的选项是否正确,特别是下载器、爬虫和代理的设置。

3、网络问题

描述:Scrapy需要访问互联网来下载网页内容,如果网络连接不稳定或被阻止,会导致Scrapy运行失败。

解决方案:检查网络连接是否正常,并确保Scrapy可以访问目标网站。

4、代理问题

描述:在使用Scrapy爬取数据时,有时需要使用代理来隐藏真实IP地址或绕过反爬虫机制,如果代理设置不正确,会导致Scrapy无法访问目标网站。

解决方案:检查代理设置是否正确,并确保代理服务器可用。

5、请求被目标网站封禁

描述:有些网站可能会封禁Scrapy的IP地址或UserAgent,导致请求被拒绝。

解决方案:更换UserAgent或使用代理来绕过封禁。

6、编码问题

描述:在爬取某些网站时,可能会遇到编码问题,导致Scrapy无法解析网页内容。

解决方案:检查网页的编码方式,并在请求头中设置正确的编码。

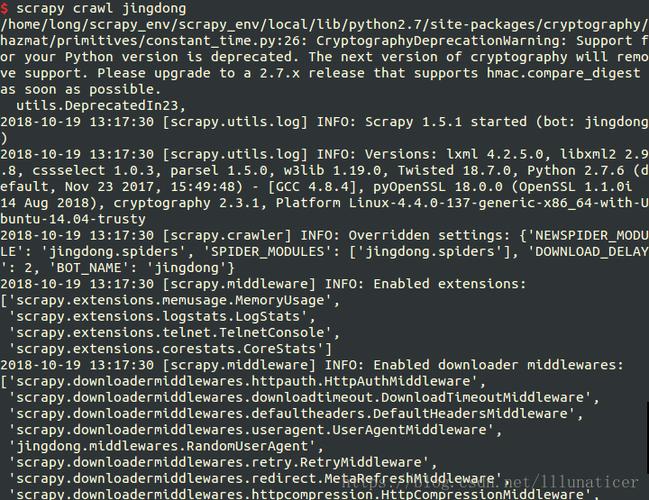

7、日志问题

描述:Scrapy的日志文件可能过于庞大或包含过多无用信息,导致无法快速定位问题。

解决方案:配置日志级别和输出格式,以便快速定位和解决问题。

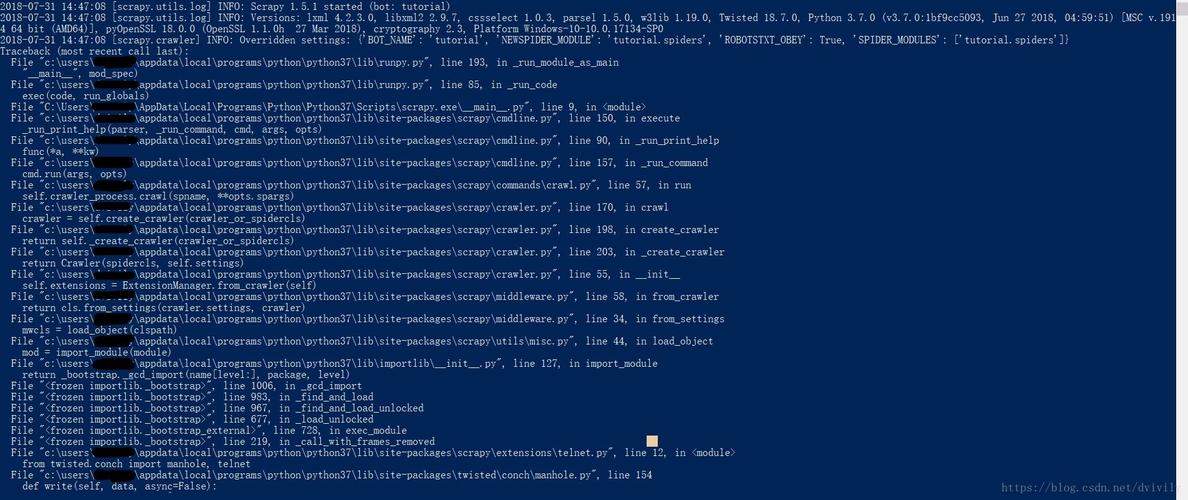

8、版本不兼容问题

描述:不同版本的Scrapy可能存在不兼容的情况,导致一些功能无法正常使用。

解决方案:检查所使用的Scrapy版本与依赖库的版本是否兼容。

9、数据库连接问题

描述:如果Scrapy需要将爬取的数据存储到数据库中,那么数据库连接设置就变得非常重要,如果数据库连接不正确或数据库服务未运行,会导致数据无法存储。

解决方案:检查数据库连接设置和数据库服务状态。

10、Spider未正确实现

描述:Spider是Scrapy中用于解析网页内容的类,如果Spider未正确实现或使用了不正确的解析方法,会导致爬取数据失败。

解决方案:仔细阅读Scrapy文档,了解Spider的正确实现方式,并确保使用正确的解析方法来提取数据。

11、创建scrapy工程时报错“ImportError: DLL load failed”

描述:在创建scrapy工程时,可能会出现“ImportError: DLL load failed: 找不到指定的模块。”的错误。

解决方案:确保系统路径(PATH)中包含Scrapy安装目录下的Scripts文件夹,或者使用Anaconda创建虚拟环境并在该环境中安装scrapy。

12、PyCharm中显示No module named ‘scrapy’

描述:即使已经安装了scrapy框架,但在PyCharm中运行时仍可能显示“No module named ‘scrapy’”。

解决方案:检查虚拟环境是否正确配置,并确保scrapy和twisted等模块已安装在虚拟环境中。

相关问答FAQs:

1、问:Scrapy在创建项目时报错怎么办?

答:确保您已正确安装了Scrapy及其所有依赖项,检查您的命令行输入是否正确,在PyCharm中可能需要在命令前添加py m,检查您的系统路径设置是否正确,确保包含Scrapy的Scripts文件夹。

2、问:Scrapy运行时提示“No module named 'win32api'”怎么办?

答:这个错误通常是由于缺少名为pypiwin32的库导致的,您可以通过以下命令安装这个库来解决这个问题:

pip install pypiwin32

这将解决大部分由于缺少win32api模块而导致的问题。