在apache Spark中,reduceByKey是一个常用的转换操作,用于将具有相同键的值进行聚合,有时在使用reduceByKey时会遇到各种错误,本文将详细探讨这些常见错误及其解决方案。

常见错误及解决方案

1. 数据类型不匹配

问题描述:

当使用reduceByKey时,如果传递给它的函数与RDD中的数据类型不匹配,就会引发错误,尝试对字符串类型的值进行数值运算。

解决方案:

确保传递给reduceByKey的函数能够正确处理RDD中的数据类型,可以通过mapValues来转换数据类型,使其与reduceByKey的操作兼容。

- val rdd = sc.parallelize(Seq(("a", 1), ("b", 2)))

- val result = rdd.reduceByKey((x: Int, y: Int) => x + y) // 确保数据类型为Int

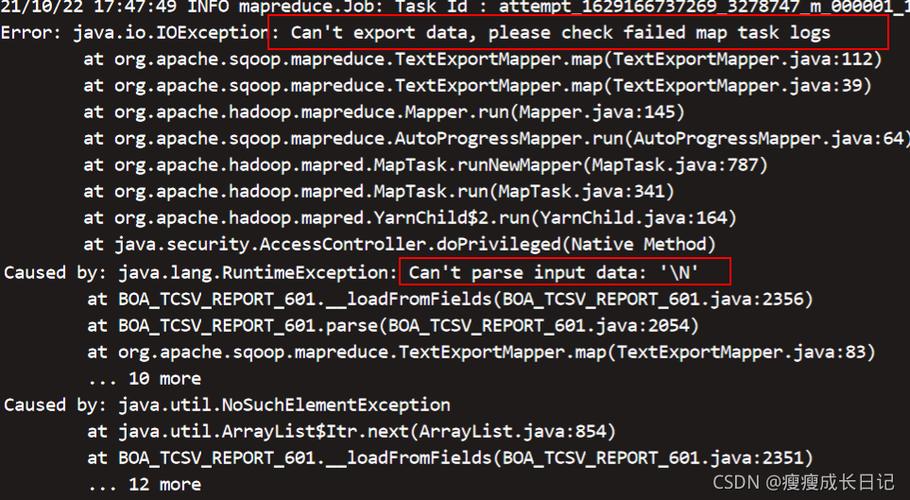

2. 缺少序列化器

问题描述:

在某些情况下,Spark需要将中间数据存储到磁盘或通过网络传输,这时就需要序列化和反序列化对象,如果没有合适的序列化器,可能会报错。

解决方案:

确保所有自定义类都实现了Serializable接口,如果使用的是Java,确保所有类都实现了java.io.Serializable。

- class MyClass(var value: Int) extends Serializable

3. 传递错误的函数给reduceByKey

问题描述:

reduceByKey需要一个满足结合律的二元操作函数,如果传递的函数不符合要求,会引发运行时错误。

解决方案:

确保传给reduceByKey的函数是结合律的,即对于任意的a,b,c,有f(f(a, b), c) == f(a, f(b, c))。

- val rdd = sc.parallelize(Seq(("a", 1), ("a", 2), ("a", 3)))

- val result = rdd.reduceByKey((x: Int, y: Int) => x + y) // 确保函数符合结合律

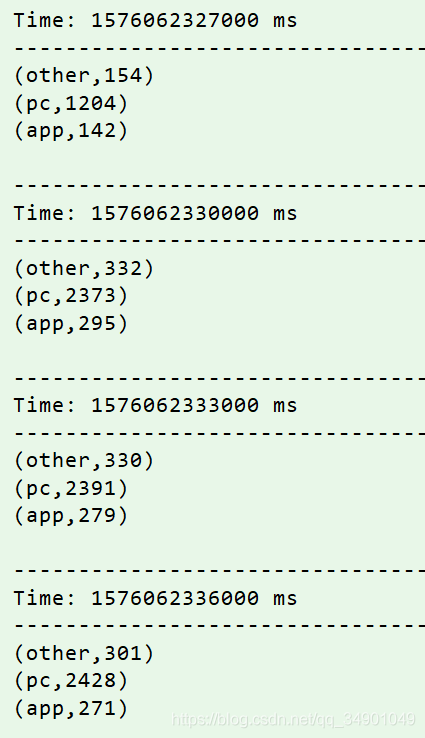

4. 内存不足

问题描述:

在处理大量数据时,如果集群资源不足,可能导致任务失败或超时。

解决方案:

增加集群的资源,调整Spark配置(如增加内存、调整分区数),或者优化代码以减少资源消耗。

- sparksubmit executormemory 4g numexecutors 10 your_application.jar

常见问题解答 (FAQs)

Q1: 为什么reduceByKey会导致“Task not serializable”错误?

A1: 这个错误通常是因为传递给reduceByKey的函数或闭包中的某个对象没有实现Serializable接口,确保所有使用的类和对象都是可序列化的,或者在Spark配置中启用Kryo序列化。

Q2:reduceByKey和aggregateByKey有什么区别?

A2:reduceByKey只支持二元操作符,而aggregateByKey支持更复杂的操作,包括零值和合并函数,这使得aggregateByKey更加灵活,但也需要更多的配置和注意。

- val rdd = sc.parallelize(Seq(("a", 1), ("b", 2)))

- // reduceByKey示例

- val resultReduce = rdd.reduceByKey(_ + _)

- // aggregateByKey示例

- val resultAggregate = rdd.aggregateByKey(0)(_ + _, _ + _)

通过理解这些常见问题及其解决方案,可以更好地使用reduceByKey进行大数据计算,避免常见的陷阱和错误。