RTX报错的原因及解决方案

一、常见原因与解决方案

1、设备禁用:

在声音面板中右键启用设备,如果麦克风被禁用了,会导致Chat with RTX找不到设备而报错。

解决办法:启动rtx voice程序,在声音面板中右键启用设备。

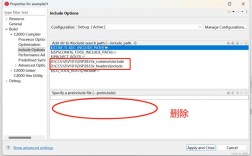

2、路径问题:

自定义安装路径可能导致安装失败,建议使用默认路径。

解决办法:确保安装路径为默认路径,且中间不包含中文或空格。

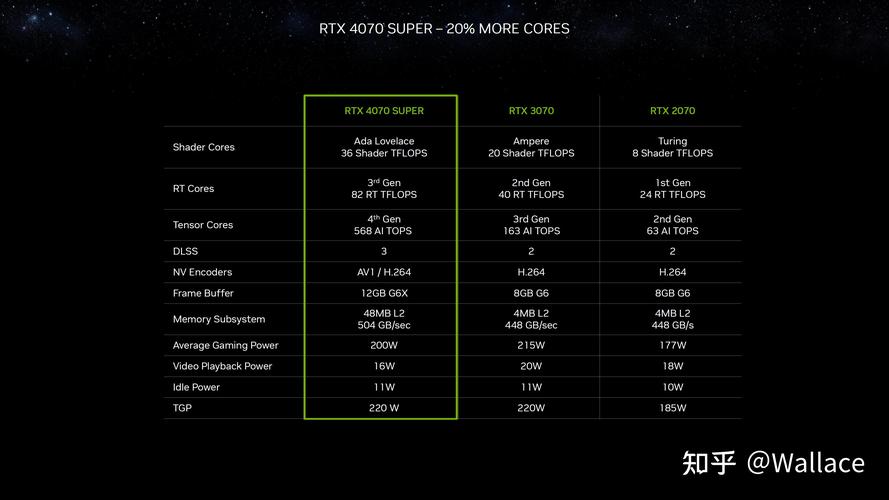

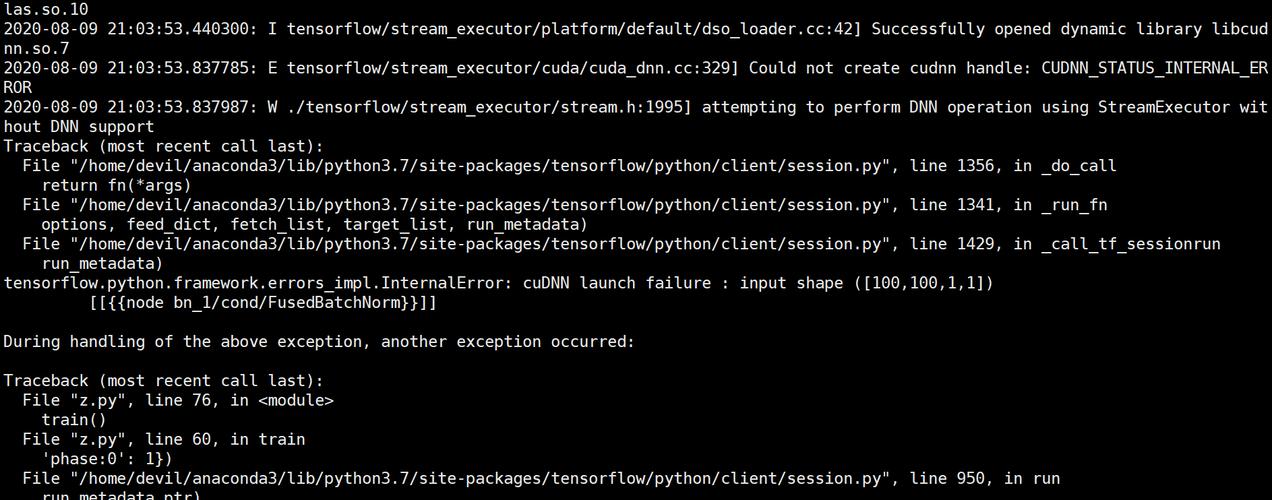

3、显卡驱动或不支持:

如果显卡驱动不是最新版本或者显卡本身不支持某些功能,也可能导致报错。

解决办法:更新显卡驱动程序,或者检查显卡是否支持所需的功能。

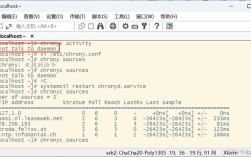

4、网络问题:

当localhost无法访问时,需要创建一个可共享的链接,并设置share=True或检查代理设置以允许访问localhost。

解决办法:确保网络连接正常,必要时修改gradio库的相关代码。

5、模型安装失败:

Llama模型的默认显存要求较高,当显卡显存不足时会报错。

解决办法:调整llama模型配置文件中的MinSupportedVRAMSize值,降低显存要求。

6、杀毒软件干扰:

安装过程中关闭所有杀毒软件,包括Windows自带的“病毒和威胁防护”。

解决办法:在安装过程中暂时关闭杀毒软件。

7、依赖库问题:

某些Python库(如httpx)可能引发报错。

解决办法:根据报错信息,更新或替换相应的Python库。

二、具体案例分析

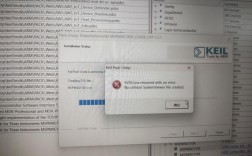

1、Chat with RTX安装失败:

用户在安装Chat with RTX时遇到多个报错,包括httpx问题和localhost不可访问问题。

解决办法:更新httpx库,修改gradio库的相关代码,并确保网络连接正常。

2、Llama模型安装失败:

由于显卡显存不足,Llama模型在安装时报错。

解决办法:调整llama模型配置文件中的MinSupportedVRAMSize值,降低显存要求。

3、Mistral模型安装失败:

Mistral模型在安装过程中总是失败,可能是由于网络问题或杀毒软件干扰。

解决办法:关闭杀毒软件,确保网络连接正常,并尝试重新安装。

三、归纳与建议

在解决RTX报错问题时,首先要仔细阅读报错信息,确定报错的具体位置和原因。

根据报错信息,采取相应的解决措施,如更新驱动程序、修改配置文件、关闭杀毒软件等。

如果问题仍然无法解决,可以尝试搜索相关的技术论坛或社区,寻求更专业的帮助。

在进行任何修改之前,建议备份重要数据,以防万一。

四、FAQs

Q1: RTX报错时如何快速定位问题?

A1: 仔细阅读报错信息,确定报错的具体位置和原因,是快速定位问题的关键。

Q2: 如果RTX报错是由于显卡驱动引起的,应该如何解决?

A2: 更新显卡驱动程序到最新版本,或者回滚到之前稳定的版本。

Q3: RTX报错是否一定意味着硬件故障?

A3: 不一定,很多时候RTX报错是由于软件配置、驱动问题或网络问题引起的,不一定是硬件故障。