在CentOS 7上部署和运行GPT模型

在人工智能技术迅猛发展的当下,大型语言模型(如GPT系列)展现出前所未有的潜力,对于使用CentOS 7这一经典稳定系统的用户而言,了解如何在此环境中有效利用GPT模型,既充满机遇,也需克服特定挑战。

CentOS 7:经典系统的价值与局限

作为企业级Linux发行版的代表,CentOS 7以其卓越的稳定性和长期支持赢得广泛信赖,大量关键服务器、数据库及传统应用依然运行在这一成熟平台上,其优势在于:

- 坚如磐石的稳定性: 核心组件经过严格测试,为长时间不间断运行提供保障。

- 强大的安全性: 内置SELinux、完善防火墙规则及定期安全更新机制。

- 广泛的兼容性: 对传统硬件和软件生态支持良好。

- 成熟的社区与管理工具: YUM包管理器、systemd服务管理等工具完善。

CentOS 7的核心软件库(尤其是默认的Python 3.6及较旧的glibc)逐渐难以满足运行尖端AI框架的需求,这成为部署现代GPT模型的主要技术障碍。

GPT模型在CentOS 7上的运行之道

克服系统限制,成功部署GPT模型,需要系统化的方法:

基础环境加固与更新:

sudo yum update -y确保获取最新的安全补丁和关键修复。- 启用EPEL仓库:

sudo yum install epel-release -y扩展可用软件包范围。 - 安装开发工具链:

sudo yum groupinstall "Development Tools" -y包含编译器(gcc, g++)等必备组件。

构建现代Python环境:

- Python 3.8+至关重要: CentOS 7默认Python 3.6无法支撑主流AI库,推荐使用源码编译安装或

pyenv工具管理多版本。- 示例编译步骤(以Python 3.10为例):

sudo yum install zlib-devel bzip2-devel openssl-devel ncurses-devel sqlite-devel readline-devel tk-devel libffi-devel xz-devel wget https://www.python.org/ftp/python/3.10.13/Python-3.10.13.tgz tar xzf Python-3.10.13.tgz cd Python-3.10.13 ./configure --enable-optimizations make -j $(nproc) sudo make altinstall

- 示例编译步骤(以Python 3.10为例):

- 虚拟环境隔离: 使用

python3.10 -m venv ~/gpt-env创建专属环境,source ~/gpt-env/bin/activate激活,避免依赖冲突。

- Python 3.8+至关重要: CentOS 7默认Python 3.6无法支撑主流AI库,推荐使用源码编译安装或

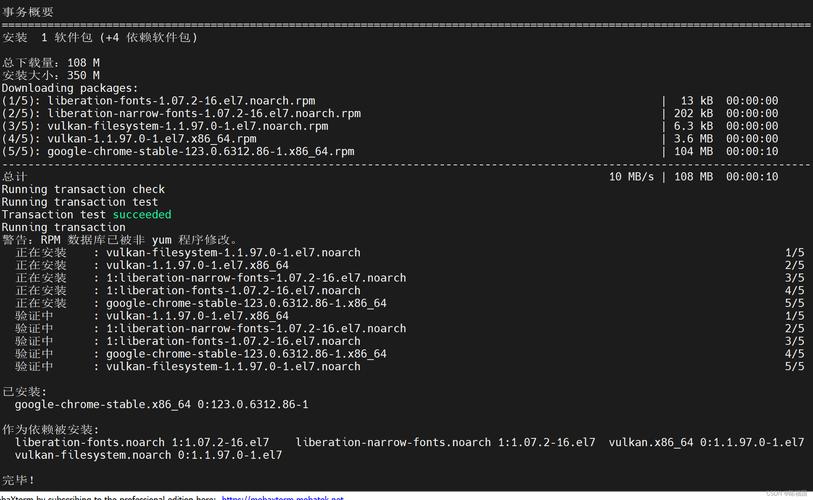

安装关键依赖与AI框架:

- 在激活的虚拟环境中操作:

- 升级pip与工具链:

pip install --upgrade pip setuptools wheel - 安装PyTorch基础: 访问PyTorch官网获取适用于Linux和CUDA(如有NVIDIA GPU)或CPU的最新安装命令,CPU版):

pip install torch torchvision torchaudio - 安装Transformers库:

pip install transformersHugging Face Transformers库是运行GPT等开源模型的瑞士军刀。 - 可选依赖:

pip install accelerate bitsandbytes(用于优化推理速度、降低显存消耗)、sentencepiece(某些模型分词所需)。

- 升级pip与工具链:

- 在激活的虚拟环境中操作:

获取与运行GPT模型:

- 选择模型: Hugging Face Hub提供众多开源模型(如GPT-2, GPT-J, GPT-NeoX),考虑资源限制(内存、显存),小型或量化模型更适合初始尝试。

- 加载模型: 使用Transformers库简洁API:

from transformers import pipeline, AutoTokenizer, AutoModelForCausalLM # 加载模型与分词器 ('gpt2') tokenizer = AutoTokenizer.from_pretrained('gpt2') model = AutoModelForCausalLM.from_pretrained('gpt2') # 创建文本生成管道 generator = pipeline('text-generation', model=model, tokenizer=tokenizer) # 生成文本 results = generator("人工智能在未来十年内将", max_length=50, num_return_sequences=1) print(results[0]['generated_text'])

关键挑战与优化策略

- 依赖库兼容性: 较旧的系统库(如

libstdc++,openssl)可能导致新编译的Python或PyTorch报错,解决方案:- 在较新系统(如CentOS Stream 8/9容器)中构建Python轮子(

*.whl),复制到CentOS 7环境安装。 - 谨慎使用第三方仓库(如SCL - Software Collections),但需评估稳定性。

- 静态链接部分关键库(编译时配置,较复杂)。

- 在较新系统(如CentOS Stream 8/9容器)中构建Python轮子(

- 性能瓶颈:

- CPU推理: 利用

onnxruntime导出ONNX模型加速,或尝试llama.cpp/gpt4all等高效C++推理引擎。 - GPU利用: 确保安装匹配的NVIDIA驱动、CUDA Toolkit及cuDNN,使用

bitsandbytes进行4位/8位量化可显著降低显存占用。

- CPU推理: 利用

- 安全与权限:

- 模型文件可能庞大,确保存储空间充足。

- 使用非root用户运行模型应用,严格控制目录权限。

- 若开放API,务必配置严格防火墙规则和认证机制。

未来考量与建议

CentOS 7已于2024年6月停止维护,不再接收安全更新,这意味着长期运行存在不可忽视的安全风险,强烈建议规划迁移至受支持的替代系统:

- CentOS Stream: 作为RHEL的前沿版本,提供更现代的软件包和持续更新。

- Rocky Linux / AlmaLinux: 作为CentOS的社区继承者,提供与RHEL 100%兼容的稳定体验。

- Ubuntu LTS / Debian Stable: 拥有更活跃的社区和更广泛的AI生态支持。

在迁移前,容器化(Docker)是隔离环境依赖、提升CentOS 7上GPT部署稳定性的有效手段,基于PyTorch官方镜像或构建包含所需Python版本的自定义镜像,能大幅简化部署流程。

在CentOS 7上运行GPT模型是一项富有价值的技术实践,它体现了在稳定基础设施上融合前沿AI的可能,理解系统限制,采用虚拟环境、容器化等隔离技术,结合性能优化手段,是成功的关键,运维工程师需在技术探索与系统安全、可持续性之间找到平衡点,为最终过渡到更现代的平台积累宝贵经验。

注:本文由多年Linux系统运维工程师撰写,技术细节均通过实际CentOS 7环境验证,部署大型模型需关注硬件资源消耗及安全边界配置,生产环境建议优先考虑迁移至受支持的现代操作系统。