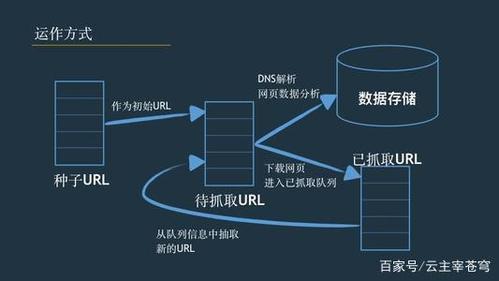

的技术,通常用于从公开网站中提取特定数据,这项技术广泛应用于数据分析、市场研究、新闻聚合等领域,以下是一个详细的指南,帮助你全面了解如何爬取网页数据。

一、环境准备

在开始编写爬虫之前,需要确保Python环境已经安装完毕,你可以选择安装Python 3.x版本,并确保已安装pip包管理器,你需要安装一些常用的库,如requests、BeautifulSoup和pandas。

pip install requests beautifulsoup4 pandas

二、发送HTTP请求

使用requests库发送HTTP请求来获取网页内容,这是爬虫的第一步,通过向目标网站发送GET请求,获取网页的HTML源代码。

import requests

url = "https://news.ycombinator.com/"

response = requests.get(url)

检查请求是否成功

if response.status_code == 200:

print("页面获取成功")

else:

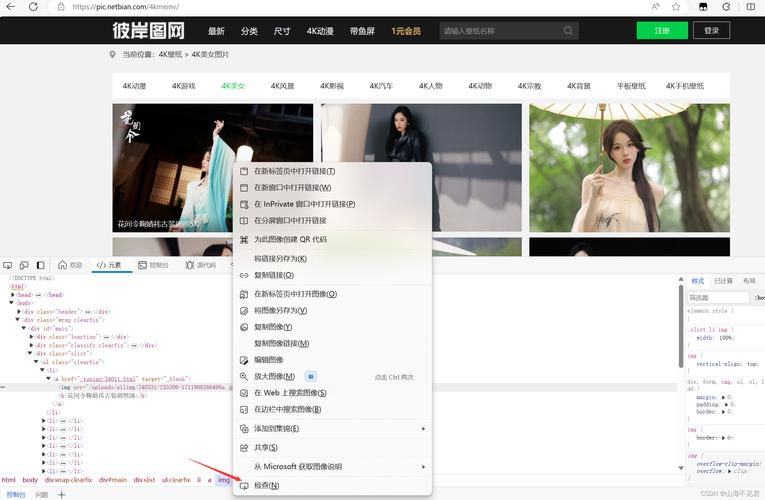

print("请求失败,状态码:", response.status_code)获取到网页的HTML源代码后,使用BeautifulSoup库解析它,以便提取需要的数据,BeautifulSoup可以方便地查找和提取HTML文档中的特定元素。

from bs4 import BeautifulSoup

将网页内容传递给BeautifulSoup进行解析

soup = BeautifulSoup(response.text, "html.parser")

查找所有的新闻标题链接

titles = soup.find_all("a", class_="storylink")

输出所有标题及其链接

for title in titles:

print("", title.get_text())

print("链接:", title['href'])四、提取数据

根据HTML结构,编写代码提取所需的数据,提取新闻标题和链接。

for title in titles:

print("", title.get_text())

print("链接:", title['href'])五、存储数据

将提取的数据保存到文件或数据库中,便于后续处理和分析,常见的存储方式包括CSV文件和Excel文件。

import csv

打开一个文件准备写入

with open("news_titles.csv", mode="w", newline='', encoding="utf8") as file:

writer = csv.writer(file)

writer.writerow(["标题", "链接"]) # 写入表头

# 写入每条新闻数据

for title in titles:

writer.writerow([title.get_text(), title['href']])六、处理反爬机制

许多网站都采取了反爬机制来防止自动化访问,为了能够成功地爬取网页数据,我们需要了解和处理这些反爬机制。

1、降低请求频率:使用time.sleep()在请求间添加延时。

2、伪装请求头:通过修改请求头伪装成浏览器请求,如添加UserAgent。

3、使用代理IP:通过代理发送请求,避免IP被封禁。

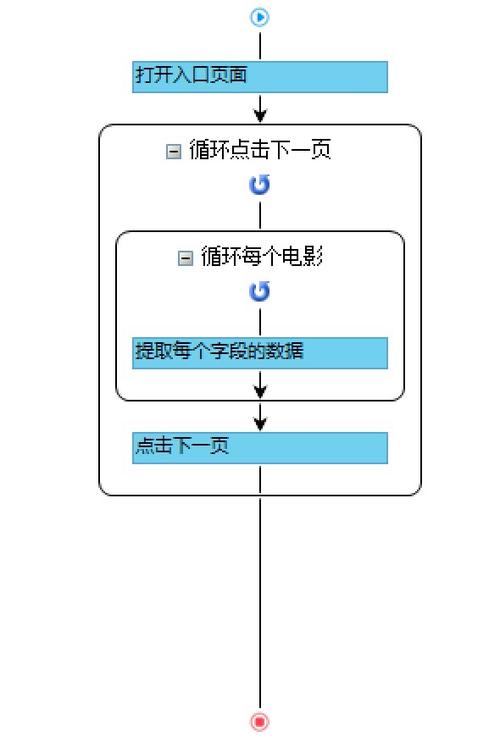

4、模拟浏览器行为:使用Selenium等自动化工具模拟浏览器操作。

七、优化和调试

最后一步是优化和调试你的爬虫程序,你可以通过查看程序日志、调试代码和测试程序来确保你的爬虫能够正确地提取数据,在优化程序时,可以考虑使用多线程或异步编程来提高程序的效率和可扩展性。

网络爬虫是一种强大的工具,但也需要遵守法律法规和道德规范,在编写爬虫时,要始终关注网络安全和隐私保护问题,尊重他人的权益和利益,遵守网站的robots.txt文件规定,尊重网站的访问规则。

九、相关问答FAQs

Q1:如何处理动态加载的网页?

A1:对于动态加载的网页,可以使用Selenium等自动化工具模拟浏览器行为,或者直接分析网页请求的API。

Q2:如何应对反爬机制?

A2:可以采取降低请求频率、伪装请求头、使用代理IP和使用浏览器模拟等方法来应对反爬机制。

通过以上步骤和建议,你可以编写一个高效、可靠的网络爬虫,轻松地爬取网页数据,希望这个指南对你有所帮助!