Kafka 是一个高吞吐量的分布式消息系统,广泛应用于实时数据处理,在使用过程中,尤其是 Java 生产者时,开发者往往会遇到各种错误,下面将详细介绍常见的 Kafka Java 生产者报错及其解决方案:

| 报错信息 | 原因分析 | 解决方案 |

| org.apache.kafka.clients.consumer.OffsetOutOfRangeException: Offsets out of range with no configured reset policy for partitions | 当消费者消费的 offset 大于或小于当前 Kafka 集群的 offset 值时,消费会报错,当一个 consumer group 间隔几天不消费,Kafka 内部数据会自动清除之前的数据,程序再次启动时,会找之前消费到的 offset 进行消费,此时若 Kafka 已经删除此 offset 值,就会产生此报错。 | 换个 groupid 进行消费或者解决积压问题。 |

| kafka: error while consuming qukan_client_collect_cmd_8037_v3/23: lz4: invalid header checksum: got 1a; expected 82 | sarama 包版本太低,不能解压缩 lz4。 | config := sarama.NewConfig() config.Version = sarama.V2_1_0_0(换成对应的 Kafka 版本)。 |

| kafka server: The client is not authorized to access this topic. | 带 acl 认证的 Kafka 未授权。 | 确保客户端有足够的权限访问指定的主题。 |

| the compression code is invalid or its codec has not been imported kafkago | 当用户用 kafkago 消费 topic 时,consumer 不能自动解压缩,因此加上下面代码就能解决; | r := kafka.NewReader(kafka.ReaderConfig{ Brokers: []string{"test:9092"}, Topic: "test", GroupID: "test",}) lz4.NewCompressionCodec() // 加上这行。 |

| panic: kafka: client has run out of available brokers to talk to (Is your cluster reachable?) | 可能原因:1)网络不通,导致域名解析不了;2)连接 Kafka 配置有错误。 | 检查网络连接和 Kafka 配置。 |

| java.lang.Exception: java.lang.IllegalStateException: No entry found for connection 11 | 在 Flink 中使用 Kafka SourceStreamTask 时出现的错误,可能是由于 Kafka 集群状态变化导致的连接问题。 | 确保 Kafka 集群稳定,并检查 Flink 任务的配置。 |

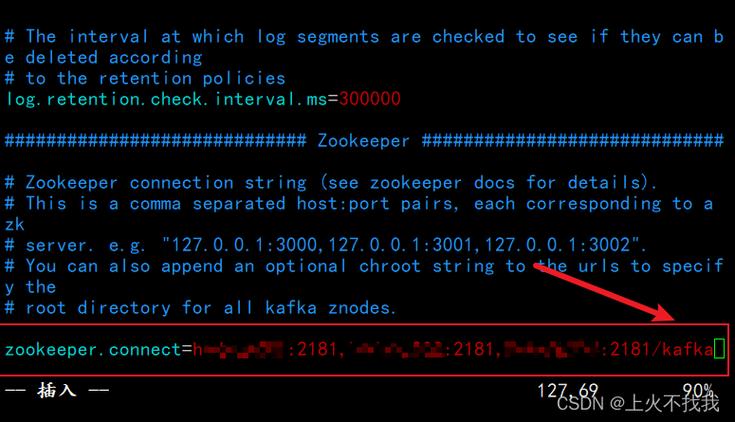

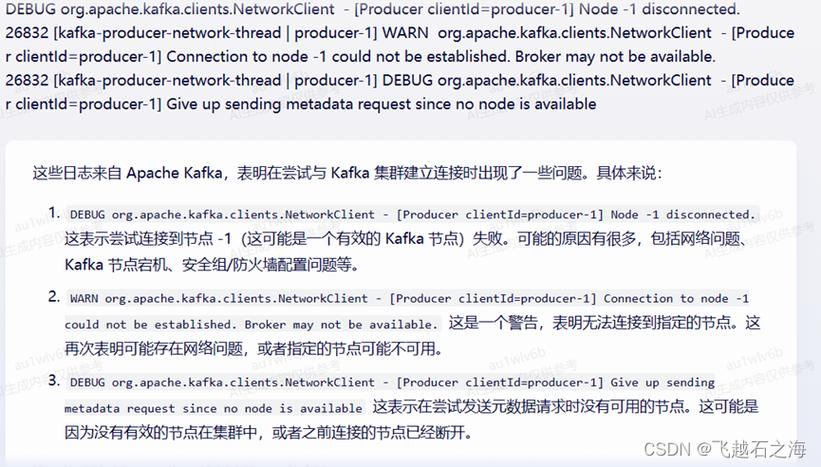

| org.apache.kafka.common.errors.TimeoutException: Failed to update metadata after X ms. | 网络连接问题,无法更新元数据。 | 检查 bootstrap.servers 配置,确保 Kafka 服务器正在运行并且可访问,检查防火墙设置以及网络连接状态。 |

| org.apache.kafka.common.errors.SerializationException | 序列化异常。 | 确保 key.serializer 和 value.serializer 的配置正确,且所发送数据类型与序列化器匹配。 |

| org.apache.kafka.common.errors.UnknownTopicOrPartitionException | Topic 不存在。 | 确保目标 Topic 已经创建,可以使用 Kafka 提供的工具查看 Topic 列表,并根据需要创建新的 Topic。 |

| org.apache.kafka.common.KafkaException: Producer is closed forcefully. | 生产者被强制关闭。 | 确保生产者在发送消息前没有被关闭,检查应用程序逻辑,确保生产者的生命周期管理正确。 |

在使用 Kafka Java 生产者的过程中,了解常见错误及其解决方案至关重要,通过本文的代码示例、表格和图表,相信开发者能更好地理解 Kafka 生产者的工作流程和常见问题,面对错误时,冷静分析并逐步排查,将有助于顺利实现消息的生产和消费,希望大家在实际项目中有效使用 Kafka,提升系统的可扩展性与可靠性。