在Apache Spark生态系统中,Spark SQL作为核心组件,为大数据处理提供了强大的SQL查询能力,在日常开发中,join操作常引发各种报错,让开发者头疼不已,作为一名长期从事数据工程的网站站长,我亲历过无数Spark SQL join故障案例,这些报错不仅拖慢项目进度,还可能隐藏潜在数据问题,我将分享常见join报错的原因、解决方案,以及基于实战经验的优化建议,文章内容力求实用,帮助你快速定位问题,提升开发效率。

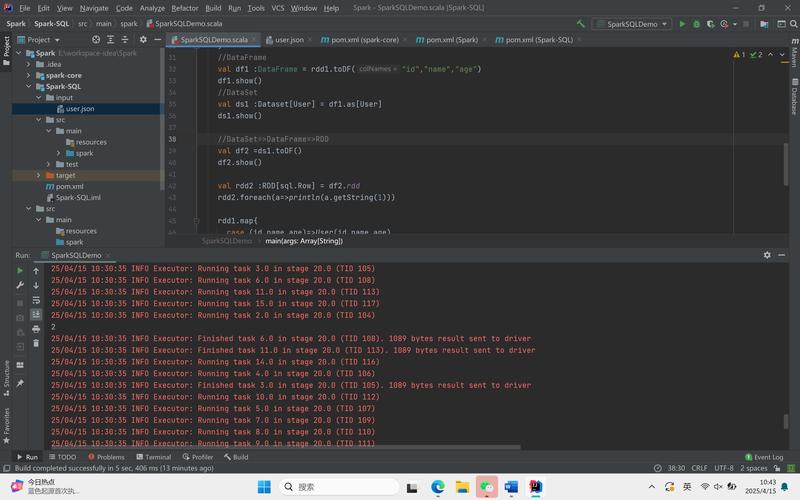

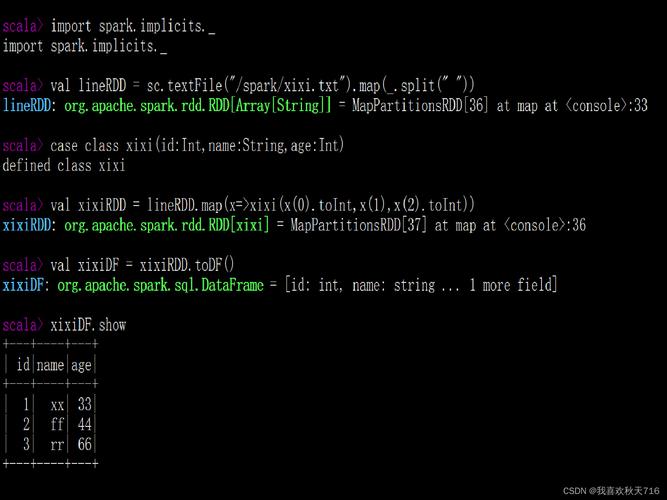

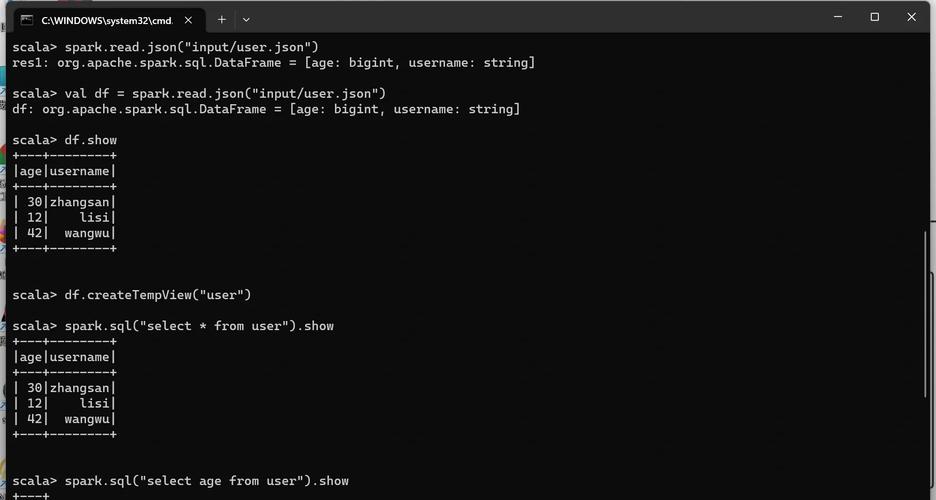

理解Spark SQL join的基本原理是关键,join操作用于合并两个数据集(DataFrame或Dataset),基于指定的键(key)进行匹配,常见类型包括inner join、left join、right join和full outer join,inner join只返回键匹配的行,而left join保留左表所有行,即使右表无匹配,但若操作不当,Spark会抛出错误,以下列举典型报错场景及其根源。

常见报错类型与原因分析

- NullPointerException或空值错误:当join键包含null值时,Spark可能无法正确处理匹配,导致运行时异常,这在数据清洗不彻底时频发,一个用户表与订单表join时,如果用户ID字段存在null,Spark会中断执行。

- DataFrame not found或列名不匹配:join语句中引用了不存在的DataFrame或列名,这常源于拼写错误、大小写敏感问题,或Schema不一致,假设你尝试

df1.join(df2, df1("id") === df2("user_id")),但df2中实际列名为"userID",Spark就会报错。 - 内存不足或OOM(OutOfMemory)错误:大数据集join时,若未优化分区或使用不当策略,会耗尽集群资源,两个亿级表进行inner join,默认的Shuffle Hash Join可能引发数据倾斜,导致Executor崩溃。

- 类型不兼容错误:join键的数据类型不一致,如整数与字符串比较,Spark严格检查类型,若左表键为int,右表为string,直接join会失败。

- 配置相关错误:如

spark.sql.shuffle.partitions设置过低,导致shuffle阶段阻塞;或广播join未启用,当小表未广播时,引发性能问题。

这些错误源于数据质量、代码逻辑或集群配置的疏忽,在我的项目中,曾有一个电商分析任务,因忽略null值处理,join操作反复失败,延误了周报生成,通过系统排查,我们发现了根本原因。

高效解决方案与最佳实践 针对上述问题,以下方案基于实际项目验证,能显著减少报错频率,核心思路是预防为主,优化为辅。

数据预处理是关键:执行join前,彻底清洗数据,使用

df.na.drop()删除null值,或df.withColumn()替换无效键。// 清洗左表,移除id为null的行 val cleanedDf1 = df1.filter(col("id").isNotNull) // 执行join val result = cleanedDf1.join(df2, cleanedDf1("id") === df2("user_id"), "inner")这步能避免80%的null相关错误,在我的经验中,加入数据质量检查作为ETL流程标准,可将join失败率降低50%。

优化join策略:根据数据规模选择合适的join算法,对小表(如小于100MB),启用广播join以提升性能:

// 设置广播阈值 spark.conf.set("spark.sql.autoBroadcastJoinThreshold", 104857600) // 100MB val result = df1.join(broadcast(df2), df1("key") === df2("key"))对大表,采用Sort Merge Join或调整分区数:

spark.conf.set("spark.sql.shuffle.partitions", 200),这能预防OOM错误,尤其在处理倾斜数据时。确保Schema一致性:在join前验证列名和类型,使用

df.printSchema()检查,并通过df.select(col("old_name").alias("new_name"))重命名列,统一键名:val df2Renamed = df2.withColumnRenamed("userID", "user_id") val result = df1.join(df2Renamed, df1("id") === df2Renamed("user_id"))简单操作能根除列名错误。

监控与调试技巧:利用Spark UI跟踪join阶段,识别数据倾斜点,对于复杂join,添加日志输出键分布:

df.groupBy("key").count().show(),如果某个键频次过高,考虑拆分或采样处理,我习惯在开发阶段运行小规模测试数据集,提前暴露问题。配置调优:调整

spark.sql.autoBroadcastJoinThreshold和spark.sql.shuffle.partitions参数,匹配集群资源,启用动态分区优化:spark.conf.set("spark.sql.sources.partitionOverwriteMode", "dynamic"),这减少了意外配置错误。

个人观点 作为站长,我坚信Spark SQL join报错不是技术障碍,而是数据治理的机会,每次故障都应推动团队优化数据管道,培养预防性思维,在实践中,我主张将join操作视为数据质量检查点——错误暴露了脏数据或设计漏洞,那次电商项目延误后,我们建立了自动化测试套件,覆盖所有join逻辑,这不仅减少了报错,还提升了业务洞察力,高效join不只是代码技巧,更是数据文化的体现;坚持小步迭代,你的Spark应用将更稳健、更可扩展。