在处理SparkSQL与Hive的交互时,经常会遇到一些报错问题,尤其是在SparkSQL中出现错误而Hive却能正常运行的情况,以下将详细分析这种情况的可能原因和解决方案:

可能的原因

1、Metastore配置不一致:SparkSQL使用其内置的Metastore,而不是Hive中使用的Metastore,这可能导致读取元数据时失败。

2、文件格式不兼容:SparkSQL内部读取的是Parquet格式的数据,而Hive中默认是ORC格式,这种格式不匹配会导致转换失败。

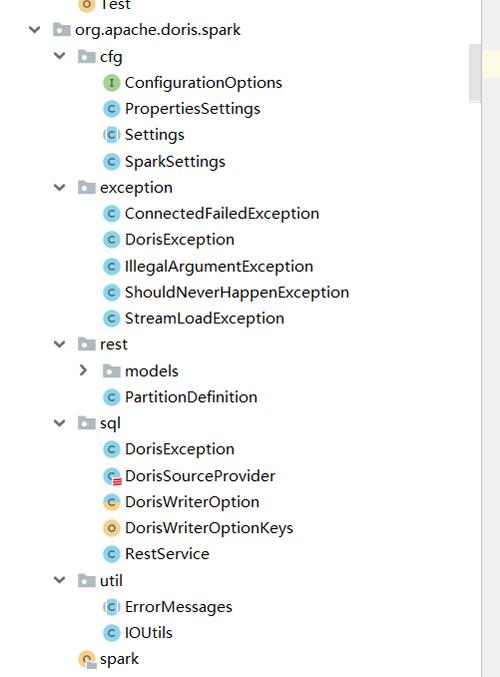

3、依赖冲突:pom文件中的依赖配置不当,如添加了不必要的依赖,可能导致依赖冲突,影响程序运行。

4、缓存问题:SparkSQL为了提高性能会缓存元数据信息,当表通过Hive或其他方式更新后,缓存的元数据未同步更新,导致查询结果不一致。

5、服务未启动:Hive的Thrift服务或metastore服务未启动,导致SparkSQL无法连接到Hive的元数据服务。

6、版本不兼容:SparkSQL的版本与Hive的版本不兼容,某些功能或API在不同版本间存在差异,可能导致执行失败。

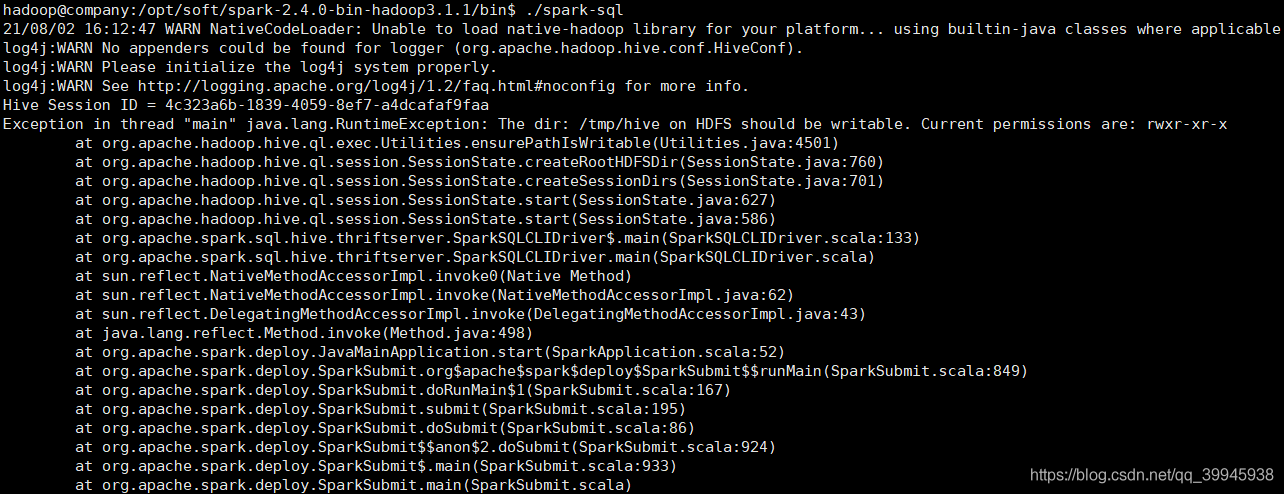

7、权限问题:执行SparkSQL的用户可能没有足够的权限访问Hive的元数据或数据文件。

8、网络问题:Spark集群与Hive服务器之间的网络连接不稳定或中断,导致SparkSQL无法正常访问Hive。

9、配置错误:Spark或Hive的配置文件中存在错误,如hivesite.xml中的配置项缺失或不正确。

解决方案

1、设置正确的配置:确保SparkSQL使用与Hive相同的Metastore,可以通过设置spark.sql.hive.convertMetastoreOrc=false来解决格式不兼容的问题。

2、解决依赖冲突:检查pom文件,移除不必要的依赖,特别是那些与Hive操作无关的依赖。

3、刷新缓存:在查询之前执行REFRESH TABLE tableName命令,或者设置spark.sql.filesourceTableRelationCacheSize为0来禁用缓存。

4、启动相关服务:确保Hive的Thrift服务和metastore服务已经启动,可以通过hive service metastore和./sbin/startthriftserver.sh来启动这些服务。

5、检查版本兼容性:确认SparkSQL和Hive的版本是否兼容,必要时升级或降级软件版本。

6、调整权限:确保执行SparkSQL的用户具有足够的权限访问Hive的元数据和数据文件。

7、网络检查:检查并确保Spark集群与Hive服务器之间的网络连接稳定。

8、修正配置错误:仔细检查Spark和Hive的配置文件,确保所有必要的配置项都已正确设置。

通过上述分析和解决方案,可以有效地诊断和解决SparkSQL报错但Hive没报错的问题,在实际操作中,需要根据具体情况灵活应用这些方法,以达到最佳效果。