在Spark集群的部署和配置过程中,sparkconf 文件扮演着至关重要的角色,该文件包含了Spark应用程序所需的各种配置参数,由于配置错误或环境问题,用户经常会遇到与sparkconf 相关的报错,本文将详细探讨一些常见的sparkconf 报错及其解决方法,并提供一个FAQ部分以解答常见问题。

常见sparkconf 报错及解决方案

| 报错信息 | 可能原因 | 解决方案 |

Error: Could not find or load main class | Spark应用程序的主类未正确指定。 | 确保在提交作业时通过class 参数正确指定主类名。sparksubmit class com.example.MainClass。 |

Failed to connect to master | Spark无法连接到Master节点。 | 检查spark.master 配置是否正确,确保Master节点正在运行且网络连接正常。 |

Unable to load nativehadoop library for your platform... using builtinjava classes where applicable | Hadoop本地库未加载成功。 | 设置HADOOP_HOME 环境变量指向正确的Hadoop安装目录,或者在sparkenv.sh 中添加export HADOOP_HOME=/path/to/hadoop。 |

Error initializing SparkContext: Java gateway process exited with code 1 | Java网关进程退出异常。 | 确保Java版本兼容,并检查内存配置是否合理,可以通过调整spark.driver.memory 和spark.executor.memory 参数来解决。 |

No FileSystem for scheme: file | 缺少对特定文件系统的支持。 | 确保Hadoop配置文件(如coresite.xml 和hdfssite.xml)包含对目标文件系统的正确支持。 |

Invalid configuration argument | Spark配置参数无效。 | 检查sparksubmit 或sparkshell 命令中的参数,确保语法正确。conf spark.some.config=value。 |

深入分析

1、主类未找到

原因: 提交Spark作业时未正确指定主类。

排查步骤:

1. 确认主类名称拼写正确。

2. 使用sparksubmit 命令时,通过class 参数指定主类。

3. 检查JAR包中是否包含该主类。

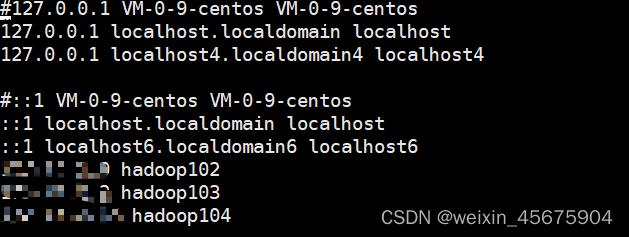

2、无法连接到Master节点

原因: Spark无法连接到指定的Master节点。

排查步骤:

1. 确认spark.master 配置正确,如spark://master:7077。

2. 检查Master节点是否启动并在监听指定端口。

3. 检查集群的网络连接是否正常,包括防火墙设置和主机名解析。

3、Hadoop本地库加载失败

原因: Hadoop本地库未正确加载。

排查步骤:

1. 设置HADOOP_HOME 环境变量,指向Hadoop的安装目录。

2. 在Spark环境配置文件(如sparkenv.sh)中添加export HADOOP_HOME=/path/to/hadoop。

3. 确认Hadoop库文件存在且路径正确。

4、Java网关进程退出异常

原因: Java网关进程异常退出。

排查步骤:

1. 检查Java版本是否与Spark兼容。

2. 调整内存配置参数,如spark.driver.memory 和spark.executor.memory。

3. 查看日志文件获取更多错误信息。

5、缺少文件系统支持

原因: Hadoop配置文件中缺少对特定文件系统的支持。

排查步骤:

1. 检查Hadoop配置文件coresite.xml 和hdfssite.xml。

2. 添加对目标文件系统的配置,如HDFS、S3等。

3. 确保配置文件格式正确,无语法错误。

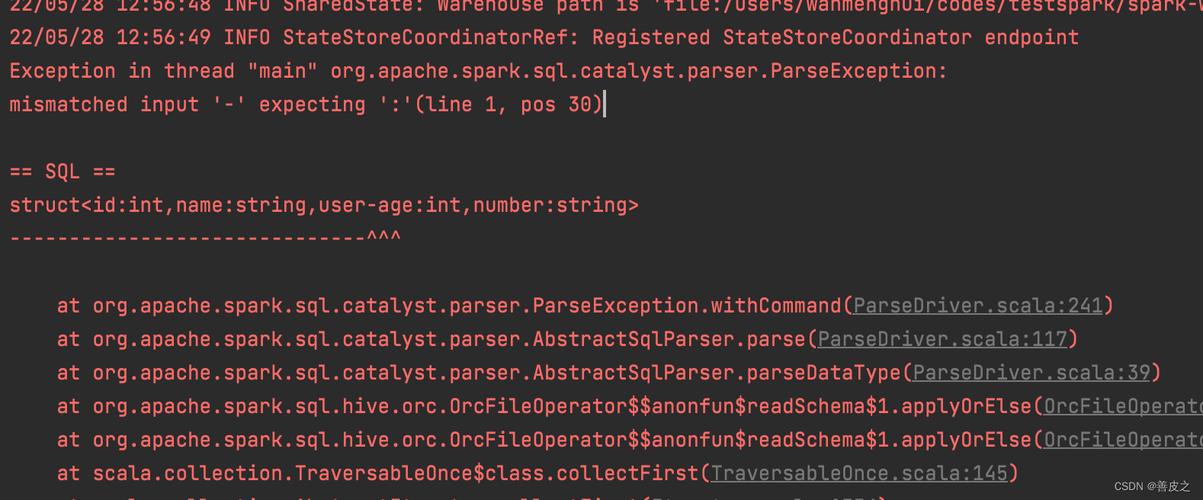

6、无效的配置参数

原因: 提交Spark作业时使用了无效的配置参数。

排查步骤:

1. 检查sparksubmit 或sparkshell 命令的参数。

2. 确保使用conf 参数进行配置,如conf spark.some.config=value。

3. 查看官方文档确认配置参数的正确格式和用法。

FAQs

Q1: 如何检查Spark和Hadoop的版本兼容性?

A1: 你可以使用以下命令检查Spark和Hadoop的版本:

检查Spark版本 $SPARK_HOME/bin/sparksubmit version 检查Hadoop版本 $HADOOP_HOME/bin/hadoop version

确保两者版本兼容,可以参考官方文档或社区发布的兼容性指南。

Q2: 如何调整Spark内存配置以避免OOM(内存溢出)错误?

A2: 你可以通过调整以下参数来优化Spark内存配置:

Driver内存配置 spark.driver.memory=2g Executor内存配置 spark.executor.memory=4g

根据实际需求和集群资源情况进行调整,确保分配的内存不会超出可用资源。

希望以上内容能够帮助你解决sparkconf 相关的问题,如果你有其他疑问或需要进一步的帮助,请随时联系我们。