CentOS 安装 Hadoop 详细步骤

一、环境准备

1. 系统要求

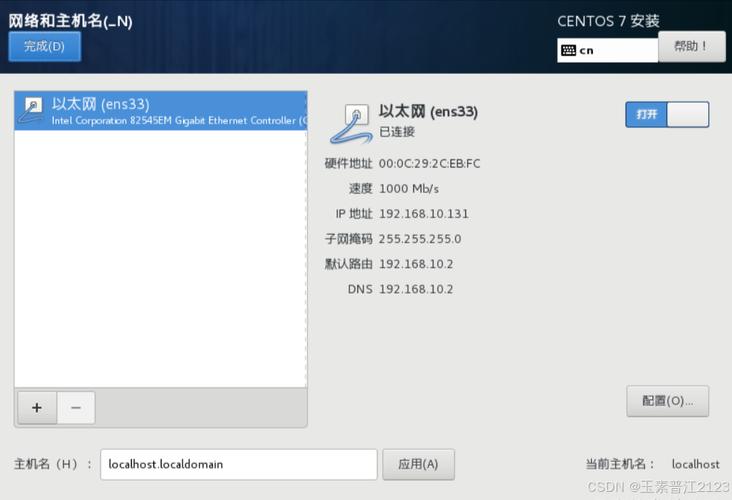

操作系统:CentOS 7 64位

内存:至少2GB(建议4GB或以上)

硬盘空间:至少50GB

2. 安装Java环境

Hadoop需要Java环境支持,首先确认是否已经安装了Java,如果未安装,可以使用以下命令进行安装:

sudo yum install java1.8.0openjdkdevel y

安装完成后,验证Java是否安装成功:

java version

输出类似如下信息则表示安装成功:

openjdk version "1.8.0_xxxxx" OpenJDK Runtime Environment (build 1.8.0_xxxxxbxx) OpenJDK 64Bit Server VM (build 25.xxxxxbxx, mixed mode)

3. 配置JAVA_HOME环境变量

编辑~/.bashrc文件,添加以下内容:

export JAVA_HOME=/usr/lib/jvm/java1.8.0openjdk export PATH=$PATH:$JAVA_HOME/bin

使配置生效:

source ~/.bashrc

验证配置:

echo $JAVA_HOME

应输出Java的安装路径。

二、创建hadoop用户并赋予权限

1、创建hadoop用户并设置密码:

sudo useradd m hadoop s /bin/bash

sudo passwd hadoop2、为hadoop用户增加管理员权限:

sudo visudo找到类似以下的行:

root ALL=(ALL) ALL在这行下面添加:

hadoop ALL=(ALL) ALL 保存并退出(按Ctrl+X,然后按Y,再按Enter)。

3、切换到hadoop用户:

su hadoop三、安装SSH并配置免密登录

1、检查是否已安装SSH:

rpm qa | grep ssh如果未安装,执行以下命令进行安装:

sudo yum install opensshclients y

sudo yum install opensshserver y2、启动SSH服务并设置为开机自启动:

sudo systemctl start sshd

sudo systemctl enable sshd3、配置SSH免密登录:

cd ~/.ssh/

sshkeygen t rsa P ""

cat id_rsa.pub >> authorized_keys

chmod 600 ./authorized_keys4、测试SSH免密登录:

ssh localhost 首次登录会提示是否继续连接,输入yes后按回车即可。

四、下载并安装Hadoop

1、下载Hadoop:

wget https://mirrors.cnnic.cn/apache/hadoop/common/hadoop3.3.4/hadoop3.3.4.tar.gz2、解压并移动Hadoop文件:

tar zxf hadoop3.3.4.tar.gz C /usr/local

sudo mv /usr/local/hadoop3.3.4 /usr/local/hadoop

sudo chown R hadoop:hadoop /usr/local/hadoop3、配置Hadoop环境变量:

vim ~/.bashrc在文件末尾添加:

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin保存并退出后,执行:

source ~/.bashrc五、配置Hadoop

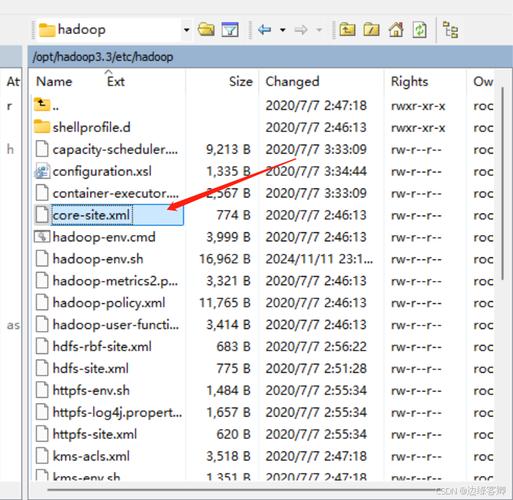

1. 配置coresite.xml

编辑$HADOOP_HOME/etc/hadoop/coresite.xml文件:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>2. 配置hdfssite.xml

编辑$HADOOP_HOME/etc/hadoop/hdfssite.xml文件:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>3. 配置maPRedsite.xml

编辑$HADOOP_HOME/etc/hadoop/mapredsite.xml文件:

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>4. 配置yarnsite.xml

编辑$HADOOP_HOME/etc/hadoop/yarnsite.xml文件:

<configuration>

<property>

<name>yarn.nodemanager.auxservices</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.auxservices.mapreduce.class</name>

<value>org.apache.hadoop.mapred.YarnChild</value>

</property>

</configuration>5. 配置hadoopenv.sh

编辑$HADOOP_HOME/etc/hadoop/hadoopenv.sh文件:

export JAVA_HOME=/usr/lib/jvm/java1.8.0openjdk

确保该文件存在且包含上述内容,如果不存在,可以复制模板文件并修改:

cp $HADOOP_HOME/etc/hadoop/hadoopenv.sh.template $HADOOP_HOME/etc/hadoop/hadoopenv.sh

6. 格式化HDFS名称节点:

hdfs namenode format

六、启动Hadoop

1、启动HDFS:

startdfs.sh2、启动YARN:

startyarn.sh3、验证Hadoop是否启动成功:

jps你应该能看到以下进程:

12345 NameNode

12346 DataNode

12347 SecondaryNameNode

12348 ResourceManager

12349 NodeManager4、访问Hadoop Web界面:

打开浏览器,访问以下地址以验证Hadoop是否运行正常:

NameNode Web UI: http://localhost:9870/

Yarn ResourceManager Web UI: http://localhost:8088/

至此,您已经在CentOS上成功安装并配置了Hadoop,通过以上步骤,您可以开始使用Hadoop进行大数据处理和存储,如果遇到任何问题,请参考Hadoop官方文档或相关技术社区获取更多帮助。