如何有效提升CentOS系统网络发包效率

在服务器运维中,网络性能直接影响业务响应速度与用户体验,针对CentOS系统,优化网络发包效率是提升整体性能的关键环节,以下从内核参数调优、协议配置、工具选择等角度,提供可落地的解决方案。

1. 调整内核参数释放带宽潜力

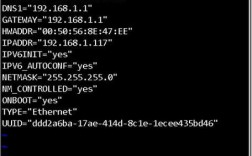

CentOS默认内核参数可能无法适应高并发场景,需针对性优化,通过修改/etc/sysctl.conf文件,调整以下核心参数:

- 增大TCP发送缓冲区范围

- net.ipv4.tcp_wmem = 4096 16384 4194304

- 启用TCP窗口缩放因子

- net.ipv4.tcp_window_scaling = 1

- 减少TIME_WAIT状态回收时间

- net.ipv4.tcp_fin_timeout = 30

- 禁用TCP慢启动重启(适用于长连接)

- net.ipv4.tcp_slow_start_after_idle = 0

执行sysctl -p生效后,可通过ss -nt观察发送窗口(Send-Q)变化,确保数值动态适应负载。

2. 优化TCP协议栈降低延迟

启用更高效的拥塞控制算法:

- 切换到BBR算法(需内核4.9+)

- echo "net.core.default_qdisc=fq" >> /etc/sysctl.conf

- echo "net.ipv4.tcp_congestion_control=bbr" >> /etc/sysctl.conf

BBR通过动态评估带宽与延迟,减少数据包重传率,实测在跨地域传输场景中,吞吐量可提升20%以上。

3. 选择高性能网络工具替代默认组件

替代netcat:使用socat或ncat支持多线程与异步IO,减少上下文切换开销。

批量发包测试:采用iperf3进行多流测试,命令iperf3 -c 目标IP -P 16启动16线程传输,精准定位瓶颈。

内核旁路技术:DPDK或XDP框架可绕过协议栈直接处理数据包,适用于万兆级网卡(需硬件支持)。

4. 网络硬件与驱动适配

- 检查网卡队列数量:ethtool -l eth0,若“Current hardware settings”中RX/TX队列小于最大值,可通过ethtool -L eth0 combined 32提升。

- 启用多队列RPS:将CPU核心绑定到中断号,均衡负载,脚本示例:

- echo ffffff > /sys/class/net/eth0/queues/rx-0/rps_cpus

- 更新驱动:定期从厂商官网获取最新驱动,例如Intel网卡建议使用ice驱动而非默认的i40e。

5. 监控与安全平衡

优化后需通过nload、iftop实时监控流量波动,避免突发流量触发限速策略,防火墙规则应精简:使用iptables的hashlimit模块替代全局限速,

- iptables -A OUTPUT -p tcp --dport 80 -m hashlimit --hashlimit-name http --hashlimit 5000/sec --hashlimit-burst 10000 -j ACCEPT

个人观点

网络优化需结合业务类型灵活调整参数,例如视频流服务器侧重带宽利用率,而API服务更需降低尾部延迟,建议在测试环境通过tcpreplay回放真实流量,对比优化前后指标(如RTT、Retransmits),避免过度调优导致稳定性下降,任何修改必须记录回滚方案,关键时刻能快速恢复基线配置。