理解网页数据抓取的基本概念

网页数据抓取是从互联网上自动提取结构化信息的过程,无论是市场分析、竞品研究还是内容聚合,合理使用抓取技术能有效提升效率,但这一过程需要技术知识、法律意识以及对数据源的理解,确保操作合法、高效且符合行业规范。

抓取前的准备工作

1、明确目标与需求

确定需要抓取的数据类型(如文本、图片、价格等)、网站范围以及更新频率,抓取电商平台价格时,需定位到商品页面的特定HTML标签,并设置定时任务。

2、分析目标网站结构

使用浏览器开发者工具(Chrome DevTools)查看网页源代码,识别数据所在的HTML标签、类名或ID,动态渲染的网站(如SPA页面)可能需要解析javaScript生成的内容。

3、遵守规则与法律限制

- 查看目标网站的robots.txt文件,确认允许抓取的路径和频率。

- 避免对服务器造成过高负载,设置合理的请求间隔(如1-2秒/次)。

- 遵守《数据安全法》和《个人信息保护法》,禁止抓取用户隐私或受版权保护的内容。

常用抓取方法与工具

1、手动编写代码(适合定制化需求)

Python + Requests/BeautifulSoup:适合静态页面,通过发送HTTP请求获取HTML内容,再用解析库提取数据。

Selenium/Puppeteer:模拟浏览器操作,适用于需要登录或动态加载数据的网站。

2、无代码工具(适合非技术用户)

Octoparse/Import.io:通过可视化界面选择页面元素,自动生成抓取流程。

浏览器插件(如Web Scraper):轻量级工具,适合小规模数据提取。

3、云端服务(适合企业级需求)

- 部分API服务商提供直接调用的数据接口,避免重复开发。

技术实现的核心步骤

1、发送HTTP请求

使用代码或工具向目标URL发送请求,获取响应内容,需处理反爬机制,如验证码、IP封禁等,可通过设置请求头(User-Agent、Cookie)模拟真实用户。

2、解析HTML内容

XPath/CSS选择器:精准定位元素,提取文本或属性值。

正则表达式:处理复杂文本匹配,但维护成本较高。

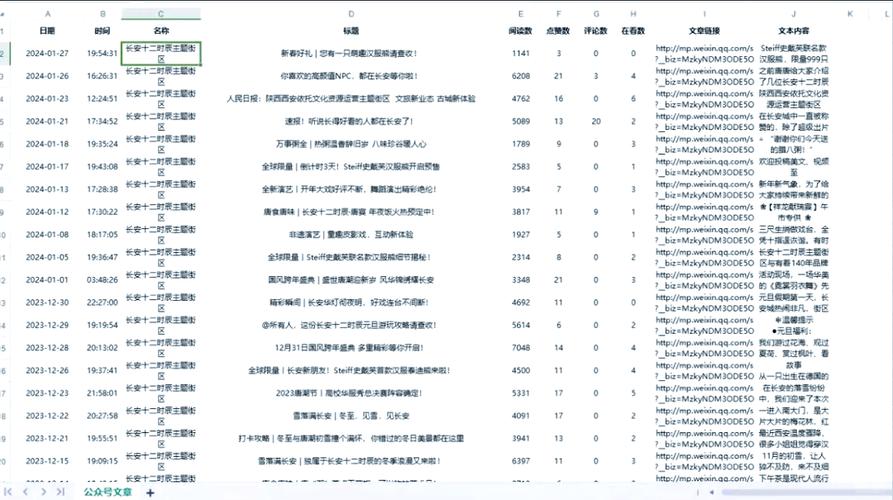

3、存储与管理数据

将抓取结果保存为结构化格式(CSV、JSON或数据库),便于后续分析,定期清理无效数据,确保存储效率。

常见问题与解决方案

反爬虫机制:

- 随机切换User-Agent和代理IP池,降低被封风险。

- 添加请求延迟,模拟人类操作间隔。

数据格式混乱:

- 清洗数据时,使用Python的Pandas库或OpenRefine工具去重、补全缺失值。

加载:

- 通过Selenium等待特定元素加载完成后再抓取,或直接调用网站内部API获取JSON数据。

道德与风险提示

1、尊重数据所有权

未经许可,禁止将抓取数据用于商业用途或重新分发,部分网站明确声明数据仅限个人研究使用。

2、避免法律纠纷

2021年某公司因抓取公开简历信息被判赔偿500万元,需警惕“合法公开≠可商用”的边界。

3、技术伦理

过度抓取可能导致目标网站服务崩溃,影响正常用户访问,技术应服务于正向价值,而非破坏竞争生态。

个人观点

网页数据抓取是工具而非目的,其价值取决于如何使用,掌握技术的同时,更需理解数据背后的业务逻辑,抓取舆情数据可辅助品牌决策,但单纯复制内容可能陷入侵权风险,建议从“需求驱动”出发,优先选择官方API或合作授权,在效率与合规间找到平衡,技术能力决定了抓取的上限,而法律意识决定了发展的下限。